Nadchodzące wybory mogą być zupełnie inne niż dotychczas. Deepfake i algorytmy sztucznej inteligencji w tak dokładny sposób potrafią zmanipulować obraz i dźwięk, że bardzo trudno jest odróżnić fałszywe treści od prawdziwych. A dopóki prawo nie reguluje w klarowny sposób tych metod cyberprzestępstw, skutki mogą być naprawdę bardzo poważne. Reprezentacją tego problemu jest sytuacja, która wydarzyła się w USA – Kari Lake, kandydatka do Senatu, starała się ofiarą deepfake’u.

Sztuczna inteligencja może zmienić bieg wyborów – Spis treści

AI będzie kolejnym graczem podczas wyborów

Deepfake staje się coraz poważniejszym zagrożeniem dla integralności wyborów – technologia ta może wpływać na proces demokratyczny poprzez manipulowanie informacjami i fałszowanie treści. Szybki rozwój sztucznej inteligencji pozwala na tworzenie coraz bardziej przekonujących materiałów, które mogą przedstawiać polityków w sytuacjach, które nigdy się nie wydarzyły. Wygenerowane przez AI treści są potem często dystrybuowane w mediach społecznościowych, gdzie zbierają kolosalne zasięgi, a wiele osób nie zdaje sobie nawet sprawy, że to podróbki mające na celu manipulację ich preferencjami politycznymi.

Technologiczne wyścigi między twórcami fałszywych materiałów a specjalistami próbującymi je wykryć ujawniają, że cyberprzestępcy szybko adaptują się do nowych metod wykrywania, czyniąc swoje „produkty” coraz trudniejszymi do odróżnienia od prawdziwych treści.

Najgorszą wiadomością jest chyba to, że wcale nie chodzi już tylko o dużych graczy w cyberprzestępczości. W zasadzie każdy przy odrobinie umiejętności jest w stanie wygenerować takie wideo. Wystarczy spojrzeć na skalę możliwości narzędzia SoraAI od OpenAI. Stworzenie takiego materiału nie wymaga nawet dobrego programu do montowania filmów.

Różne instytucje i organizacje, takie jak ESET (międzynarodowa firma zajmująca się cyberbezpieczeństwem) podkreślają potrzebę zdecydowanych działań w celu ochrony demokracji przed manipulacją AI, wskazując na konieczność wspólnych wysiłków zarówno na poziomie legislacyjnym, technologicznym, jak i społecznym, aby skutecznie przeciwdziałać dezinformacji. Dopóki jednak nie zostaną podjęte zdecydowane kroki, będziemy świadkami takich sytuacji jak niedawny incydent z Kari Lake.

Deepfake z Kari Lake

Organizacja Arizona Agenda wykorzystała sztuczną inteligencję i podobiznę kandydatki do senatu Kari Lake z Partii Republikańskiej, aby stworzyć fałszywy film z jej udziałem. Wideo prezentowało, jak technologia ta może być wykorzystana do manipulacji informacjami w kontekście wyborów.

Film, który początkowo przedstawiał kobietę wypowiadającą nieprawdziwe i kontrowersyjne stwierdzenia, zakończył się ostrzeżeniem o potencjalnym wykorzystaniu sztucznej inteligencji do wpływania na elektorat w wyborach. W skrócie – technologia została użyta po to, aby przed nią przestrzegać, podobnie jak w ostatniej słynnej reklamie T-Mobile.

Kari Lake nakazała firmie usunąć wideo ze wszystkich dostępnych kanałów, jednak tysiące Amerykanów zdążyło je obejrzeć. Według The Washington Post wiele wskazuje na to, że AI i towarzyszący jej niepokój już w taki sposób wpływają na wybory.

Jak deepfake może wpłynąć na wybory?

Fałszywe wideo lub nagrania audio mogą być używane do rozpowszechniania nieprawdziwych informacji o kandydatach, wprowadzając w błąd wyborców i potencjalnie wpływając na ich decyzje wyborcze. Realistyczne wideo pokazujące kandydata wygłaszającego kontrowersyjne oświadczenia może zaszkodzić jego reputacji i szansom wyborczym, nawet jeśli materiał zostanie później zdementowany.

Ale to niejedyne zagrożenie związane z tą technologią. Pojawienie się takich sfabrykowanych materiałów może przyczynić się do ogólnego wzrostu sceptycyzmu i dezorientacji wśród wyborców co do autentyczności wszelkich informacji, nawet tych pochodzących z wiarygodnych źródeł.

Deepfake w Polsce

W sieci jest bardzo dużo treści, które przedstawiają np. obecnego prezydenta Polski, Andrzeja Dudę, w różnych zabawnych sytuacjach. Wystarczy wpisać hasło „Andrzej Duda deepfake” i możemy zdać sobie sprawę, jaka siła drzemie w AI.

Warto także przypomnieć sobie jak w sierpniu 2023 roku Platforma Obywatelska wykorzystała sztuczną inteligencję do stworzenia głosu premiera Mateusza Morawieckiego. Materiał nie został odpowiednio oznaczony jako wygenerowany przez AI, co wzbudziło bardzo duże kontrowersje.

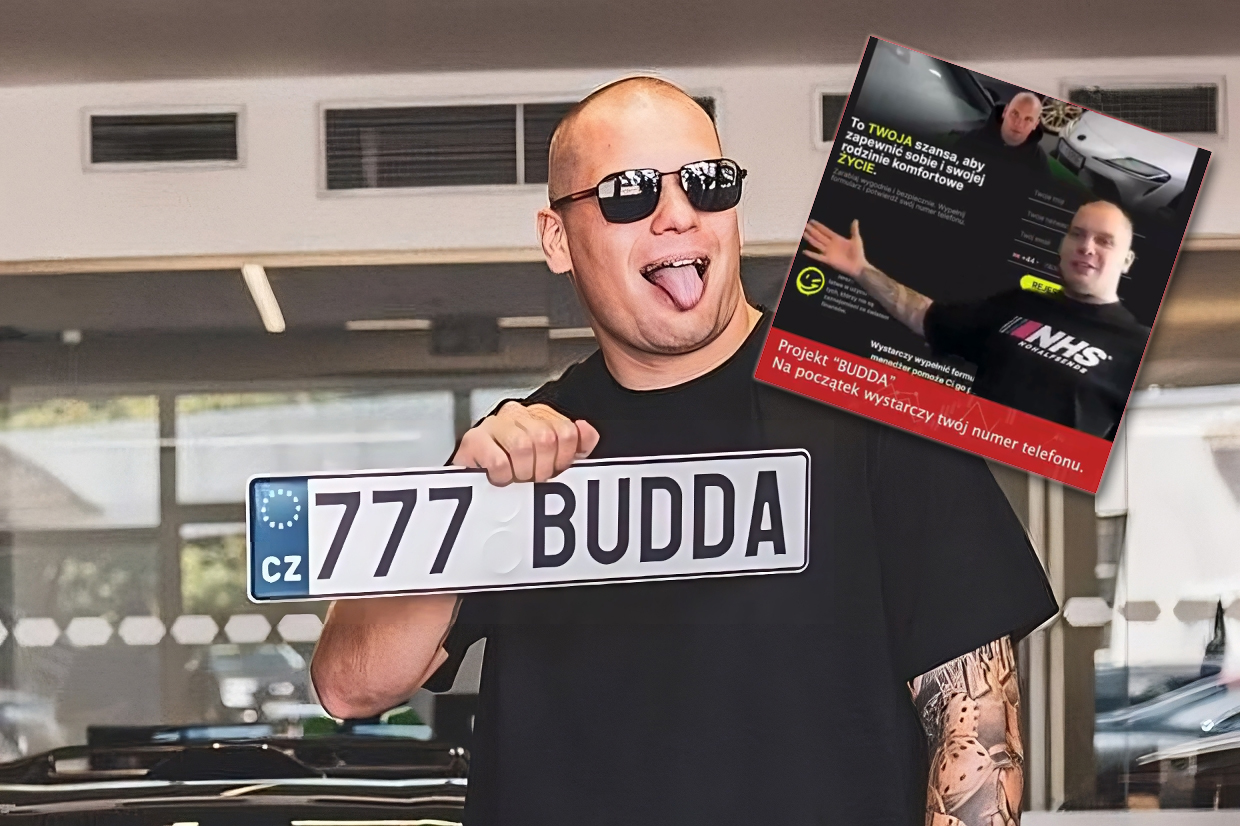

Na koniec lutego 2024 w sieci pojawił się także deepfake z Buddą. Oszustwo związane z postacią znanego polskiego youtubera motoryzacyjnego polegało na wykorzystaniu jego wizerunku w kampanii zachęcającej do inwestycji gwarantującej zysk miliona złotych. Film z Buddą promował tajemniczy program do automatycznego handlu, co jest klasycznym przykładem fałszywej inwestycji mającej na celu wyłudzenie pieniędzy.

Źródło: The Washington Post, oprac. własne. Zdjęcie otwierające: terovesalainen / Depositphotos

Część odnośników to linki afiliacyjne lub linki do ofert naszych partnerów. Po kliknięciu możesz zapoznać się z ceną i dostępnością wybranego przez nas produktu – nie ponosisz żadnych kosztów, a jednocześnie wspierasz niezależność zespołu redakcyjnego.