Chociaż sztuczna inteligencja serwowana przeciętnemu Kowalskiemu w formie przykładowo ChatGPT potrafi zaskoczyć, tworząc imponujący tekst, rewolucja AI nie osiągnęła jeszcze prawdziwego zrozumienia i świadomości.

Naukowcy z University of Cincinnati podjęli się próby odpowiedzi na pytanie, czy sztuczna inteligencja jest tak inteligentna, jak człowiek. Czy fala wiadomości o postępie technologicznym to już rewolucja, czy tylko ewolucja?

Spis treści

Być inteligentnym, czyli jakim?

Definicja terminu „inteligencja” zwykle różni się w zależności od kontekstu, perspektywy i dziedziny nauki. Najogólniej rzecz ujmując, jest to zdolność do skutecznego rozwiązywania problemów, logicznego myślenia, niektórzy podają również, że w ramach inteligencji mieści się również umiejętność przystosowywania się do zmieniającego się otoczenia, uczenia się (niekoniecznie chodzi o wykształcenie) i korzystania ze zdobytej wiedzy tak, by podejmować świadome decyzje.

W 1983 roku Howard Gardner z Uniwersytetu Harvarda opracował swoją teorię inteligencji wielorakiej, która zakłada istnienie różnych rodzajów inteligencji, której nie można zmierzyć jednym, standardowym testem. Co istotne, wszystkie inteligencje współpracują ze sobą, w różnych konfiguracjach. Wymienia się:

- Inteligencję matematyczno-logiczną, czyli zdolność do logicznego myślenia, rozwiązywania problemów matematycznych i analizy abstrakcyjnych koncepcji;

- Inteligencję językową, czyli zdolność do skutecznego używania języka, zarówno w mowie, jak i piśmie;

- Inteligencję egzystencjonalną (dodana później), czyli taką, która oznacza zdolność do refleksji nad pytaniami związanymi z sensem istnienia, życiem oraz umieraniem. Związana najczęściej ze sferą duchową i obawami dotyczącymi spraw ostatecznych;

- Inteligencję ruchową, czyli zdolność do skutecznego kontrolowania ruchów ciała i manipulowania przedmiotami;

- Inteligencję wizualno-przestrzenną, czyli zdolność do rozumienia przestrzeni, kształtów i relacji przestrzennych;

- Inteligencję muzyczną, czyli zdolność do rozumienia i tworzenia muzyki;

- Inteligencję przyrodniczą, czyli zdolność do rozpoznawania i klasyfikowania elementów natury, takich jak rośliny, zwierzęta czy zjawiska przyrodnicze;

- Inteligencję intrapersonalną, czyli zdolność do samoświadomości, zrozumienia własnych uczuć, motywacji i celów;

- Inteligencję interpersonalną, czyli zdolność do zrozumienia innych ludzi, empatii i efektywnej komunikacji interpersonalnej.

W kontekście sztucznej inteligencji inteligencję często definiuje się jako zdolność maszyny do wykonywania zadań wymagających ludzkiego myślenia, takie jak rozpoznawanie mowy, analiza obrazów czy podejmowanie decyzji na podstawie różnych informacji. Czy powyższe aspekty, składające się na ludzką inteligencję, będą się aplikować również w kontekście AI?

W teorii da się zmierzyć poziom inteligencji u człowieka za pomocą testów. Jednym z najbardziej znanych narzędzi tego typu jest Test Inteligencji Wechslera, inaczej znany jako Test IQ (np. WAIS – Wechsler Adult Intelligence Scale), który mierzy różne aspekty inteligencji, takie jak werbalne umiejętności, umiejętności spostrzegawcze, myślenie abstrakcyjne i szybkość przetwarzania informacji.

Wyniki z takich testów pozwalają na porównanie wyników jednostek w stosunku do pewnej populacji referencyjnej. Jak jednak zaznacza prof. Gardner, warto pamiętać, że inteligencja jest wieloaspektowym zjawiskiem, a testy nie zawsze w pełni je odzwierciedlają.

Istnieje również krytyka związana z kulturowym uwarunkowaniem testów inteligencji. Niektóre z tych testów mogą być bardziej dostosowane do określonych grup społeczno-kulturowych, co może wpływać na ich trafność w różnych populacjach. Testy te najczęściej badają nasze umiejętności, skojarzenia, wiedzę – czy te terminy jednogłośnie składają się na inteligencję?

Ewolucja AI. Skąd wzięła się sztuczna inteligencja?

Sztuczna inteligencja to nie wytwór OpenAI. W tym roku mija 67 lat, odkąd ta zaistniała jako odrębna gałąź nauki. „Ojcem sztucznej inteligencji” określa się Johna McCarthy’ego, matematyka i informatyka, który w 1956 roku po raz pierwszy użył tego określenia. Naukowiec w dużym stopniu zaangażował się w rozwijanie tej dziedziny.

W 1956 roku McCarthy zorganizował wydarzenie naukowe na Uniwersytecie Dartmouth, znane potem jako Konferencja Dartmouth. Celem tego spotkania było zgromadzenie grupy badaczy, którzy mieli skoncentrować się na tworzeniu maszyn zdolnych do myślenia na sposób, który przypomina ludzkie myślenie.

Jak czytamy w magazynie Brandsit, grupa naukowców obecnych na owym spotkaniu postawiła tezę, że sztuczna inteligencja będzie kiedyś tak inteligentna jak człowiek. Pytaniem, jakie nasuwało się na myśl naukowcom, było „kiedy”?

W latach 80. XX wieku nastąpił kryzys w AI, kiedy oczekiwania względem osiągnięć były wyższe niż możliwości technologiczne. W kolejnych dziesięcioleciach, dzięki postępowi w mocy obliczeniowej i algorytmom, AI zyskała na znaczeniu. Lata 90. i początek XXI wieku to okres, w którym wzrosło zainteresowanie uczeniem maszynowym, a zwłaszcza sieciami neuronowymi.

Obecnie, głębokie uczenie maszynowe, które opiera się na wielowarstwowych sieciach neuronowych, stanowi dominujący nurt w dziedzinie. Modele takie jak GPT zaproponowany przez OpenAI czy różne architektury sieci neuronowych zdolne do rozpoznawania obrazów, generowania tekstu czy podejmowania decyzji, są stosowane coraz częściej. Wraz z postępem technologicznym, AI staje się integralną częścią wielu dziedzin, od medycyny po przemysł, a jej ewolucja kontynuuje się w dynamicznym tempie.

Gdzie jest granica między człowiekiem a maszyną?

ChatGPT nie jest jedynym dostępnym narzędziem AI, ale z pewnością jest najbardziej popularny. Naukowcy wykorzystali zaawansowane algorytmy sztucznej inteligencji, takie jak sieci neuronowe, aby przetwarzać język naturalny i generować odpowiedzi na zadawane pytania. Niestety, zdolność AI do konfabulowania oraz tworzenia „zmyślonych faktów” nie jest równoznaczna z ludzką inteligencją. A czym ona właściwie jest? Czy da się zmierzyć poziom inteligencji sztucznej inteligencji?

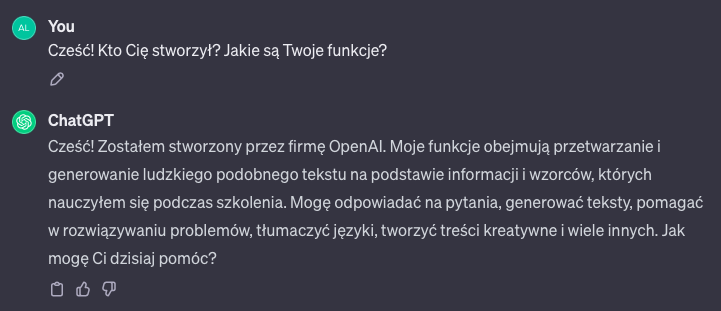

Powyższy zrzut ekranu to początek mojej rozmowy z czatbotem. Reprezentant sztucznej inteligencji jawi się jako mocno pomocny „kumpel”, który odpowie na wszystkie pytania. Ma też pomóc w rozwiązywaniu problemów, czy tworzeniu kreatywnych treści do wsparcia pracy np. coprywriterów. Zadałam również ChatGPT pytanie dotyczącego tego, czy posiada świadomość. Zgodnie z oczekiwaniami, odpowiedział, że nie:

Nie, nie posiadam świadomości ani samoświadomości. Jestem programem komputerowym opartym na architekturze GPT-3.5, stworzonym do przetwarzania i generowania tekstu w odpowiedzi na wprowadzone dane. Chociaż mogę wydawać się inteligentny w kontekście mojej zdolności do generowania tekstów, nie mam świadomości, uczuć ani zdolności do samopoczucia. Jestem narzędziem do przetwarzania języka naturalnego, a moje odpowiedzi opierają się wyłącznie na wzorcach i informacjach, które pozyskałem podczas szkolenia.

Odpowiedź wygenerowana przez ChatGPT.

Na ten moment sztuczna inteligencja nie posiada samoświadomości definiowanej jako m.in. zdolność do doświadczania i rozumienia własnego istnienia oraz otaczającego świata. Pojęcie „inteligencji” jest więc odrobinę zagmatwane z językowego punktu widzenia, jak zresztą twierdzi Anthony Chemero z University of Cincinnati, profesor filozofii i psychologii w UC Collage of Arts and Sciences. Naukowiec przeciwnie do uczestników Konferencji w Dartmouth uważa, że sztuczna inteligencja nie może być inteligentna w takim stopniu, w jakim inteligentni są ludzie.

Rewolucja AI była również tematem interesującej rozmowy pomiędzy Tomaszem Rożkiem (z Nauka. To lubię) a Mateuszem Chrobokiem (twórcą internetowym). Obaj popularyzatorzy nauki w sposób lekki i przejrzysty tłumaczą często zagmatwane terminy związane z technologią.

Rewolucja AI według naukowców z Cincinnati

Artykuł, którego tematem jest szeroko pojęta rewolucja AI został opublikowany w czasopiśmie Nature Human Behaviour.

Duże modele językowe (…) uczą się tworzyć zdania gramatyczne, ale wymagają znacznie więcej uczenia się niż ludzie. Tak naprawdę nie wiedzą, co oznaczają rzeczy, które mówią. LLM (ang. Large Language Models) różnią się od ludzkiego poznania, ponieważ nie są ucieleśnione.

Anthony Chemero z University of Cincinnati, profesor filozofii i psychologii w UC Collage of Arts and Sciences, cytowany przez NeuroScienceNews.

LLM tworzą zdania poprzez dodawanie kolejnych wyrazów, które zdają się najbardziej statystycznie prawdopodobne. Modele nie dbają o to, czy mówią prawdę, czy nie. Twórcy ChatGPT nazywają to „halucynacjami”, prof. Chemero nazywa to zaś „bzdurami” (choć jest to niezwykle uprzyjemniona wersja angielskiego „bullshitting”).

Celem artykułu Chemero jest wyraźne podkreślenie, że Large Language Models nie manewrują inteligencją w identyczny sposób, w jaki myślą ludzie, ze względu na fundamentalną różnicę w ucieleśnieniu. Autor argumentuje, że ludzie, będąc istotami ucieleśnionymi, zawsze są zanurzeni w środowisku społecznym, kulturowym oraz materialnym, co stanowi podstawę ich inteligencji. Wszystko to w opozycji do LLM, które nie dbają o przetrwanie, nie wykazują zainteresowania otaczającym je kontekstem. Brak im troski i zaangażowania.

Według naukowca, przy odrobinie nacisku można by uzyskać narzędzie sztucznej inteligencji, które będzie mówić „paskudne rzeczy, które są rasistowskie, seksistowskie lub w inny sposób stronnicze”. Zupełnie tak jak z… człowiekiem. „Odpowiednie” środowisko, odwiedzanie konkretnych stron internetowych i oglądanie wybranych programów telewizyjnych czy serwisów newsowych może nam również „pomóc” w staniu się np. stronniczym.

Źródło: NeuroScienceNews. Zdjęcie otwierające: Vitaly_Sokol / Depositphotos