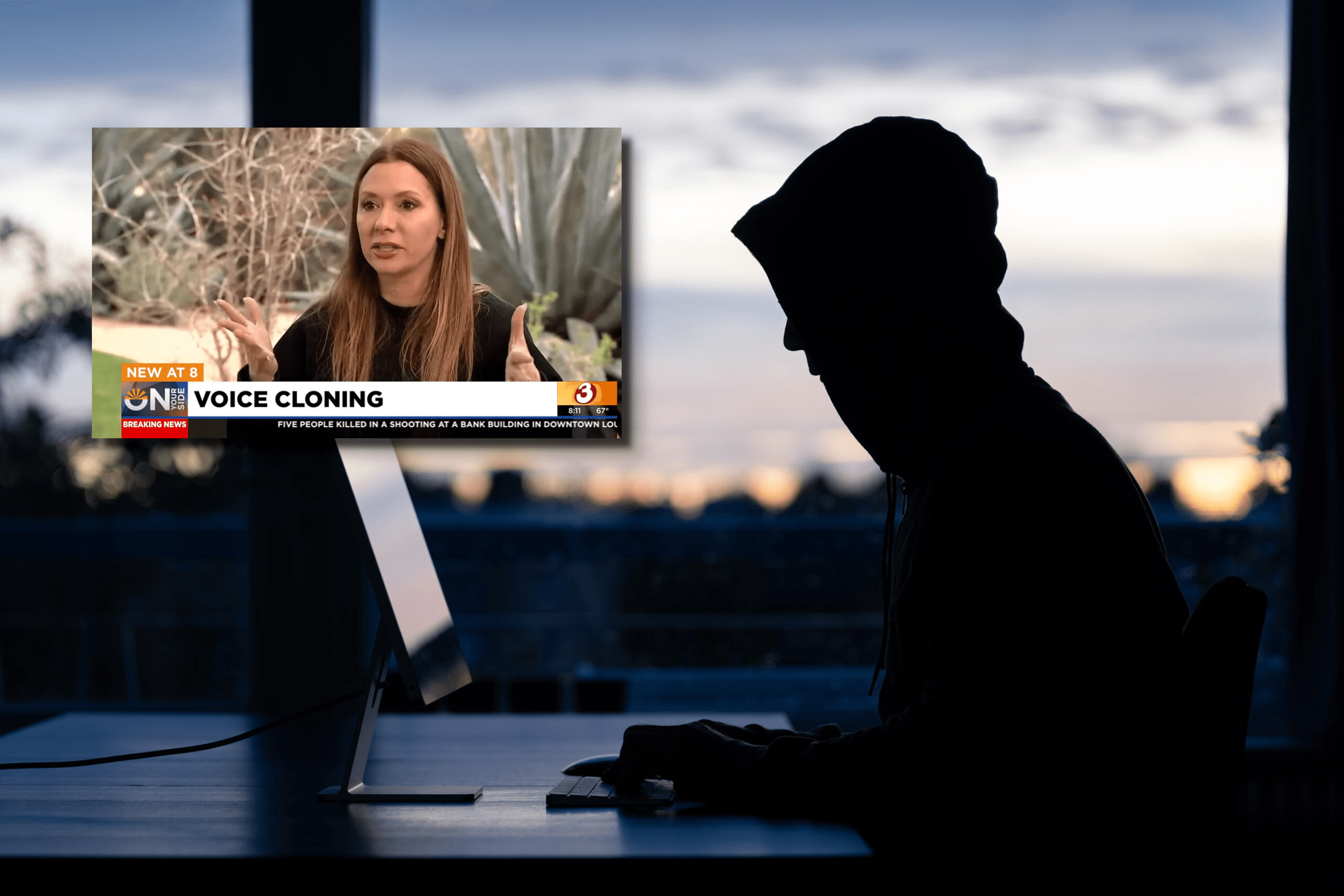

Technologia sztucznej inteligencji może pomóc oszustom w podszywaniu się pod czyjś głos za pomocą zaledwie kilkusekundowej próbki dźwiękowej. W przypadku pewnej mieszkanki stanu Arizona w Stanach Zjednoczonych przestępcy próbowali wykorzystać tę technologię, wykorzystując głos dziecka wygenerowany przez AI, aby wymusić na niej okup za rzekomo porwaną córkę.

Głos dziecka wygenerowany przez AI zamiast porwania

W stanie Arizona, pewna kobieta otrzymała telefon z żądaniem okupu za rzekomo porwaną córkę. Głos jej córki, zapłakany i błagający o pomoc, był tak realistyczny, że matka początkowo nie miała wątpliwości co do jego autentyczności. Okazało się jednak, że to była tylko mistyfikacja mająca na celu wyłudzenie okupu, a technologia AI została wykorzystana do skopiowania głosu córki.

I chociaż dziś brzmi to jak absurd, to pamiętajmy, że zaczynamy żyć w erze, w której coraz rzadziej można ufać swoim oczom i uszom. Takie działania mogą prowadzić do potencjalnych zagrożeń dla prywatności i bezpieczeństwa, a także wzrost liczby oszustów wykorzystujących AI. I oczywiście: ktoś może uznać, że lepsze jest podszywanie się Sztucznej Inteligencji, niż prawdziwe porwanie dziecka i związana z tym trauma.

Pamiętajmy jednak, że jeśli tego typu akcje staną się popularne, to prawdziwi porywacze będą starali się udowodnić inaczej to, że udało im się kogoś porwać. A skoro nagrania i zdjęcia będą mało wiarygodne, to są rzeczy, których Sztuczna Inteligencja już nie wygeneruje – na przykład odcięty palec.

Głos dziecka wygenerowany przez AI – nie tylko porwania to problem

Pamiętajmy przy tym, że pole do oszustwa jest znacznie większe. Znajomy głos, któremu ufamy, ale ze strony kogoś o złych zamiarach może zrobić wiele złego. Jak więc żyć w tych nowych czasach? Otóż są pewne metody, aby być w miarę bezpiecznym. Po pierwsze, należy weryfikować tożsamość rozmówcy poprzez zadawanie prostych pytań, na które odpowiedź znają tylko osoby najbliższe – zwłaszcza jeśli dzwonią z obcego numeru. Nie podejmować pochopnych decyzji na podstawie samej rozmowy.

Owszem, dziś jeszcze to brzmi jak retoryka godna kogoś z manią prześladowczą. Jednak technologie, takie jak Microsoft AI, który może kopiować głos na podstawie 3-sekundowej próbki, stają się coraz bardziej powszechne i dostępne. W związku z tym wzrasta liczba osób mających dostęp do technologii deepfake AI, co może prowadzić do negatywnych konsekwencji związanych z powszechnym wykorzystywaniem AI.

Źródło: YouTube