No i oto jest. OpenAI udostępniło właśnie model GPT-4, który ma wywrócić do góry nogami to, co postrzegamy jako osiągalne dla sztucznej inteligencji. Jeżeli dotychczasowe poczynania ChatGPT i innych narzędzi opartych na GPT-3 i GPT-3.5 robiły na was wrażenie… prawdopodobnie teraz będziecie musieli kilkukrotnie się uszczypnąć, aby upewnić się, że to nie sen.

GPT-4 oficjalnie udostępniony – spis treści

[AKTUALIZACJA #1 – 14 marca 2023, godz. 19:26]

W tekście pojawiły się drobne zmiany związane z rodzajem wprowadzanych treści, dodaliśmy także przykład obrazujący nową funkcjonalność pozwalającą na opisywanie grafik.

Poniżej reszta materiału

GPT-4 już dostępny dla części użytkowników

Wieści na temat udostępnienia modelu GPT-4 szerszemu gronu przekazał w pierwszej kolejności Greg Brockman, szef OpenAI. Chwilę później wiadomość dotarła także do wszystkich osób tworzących społeczność na dedykowanym Discordzie.

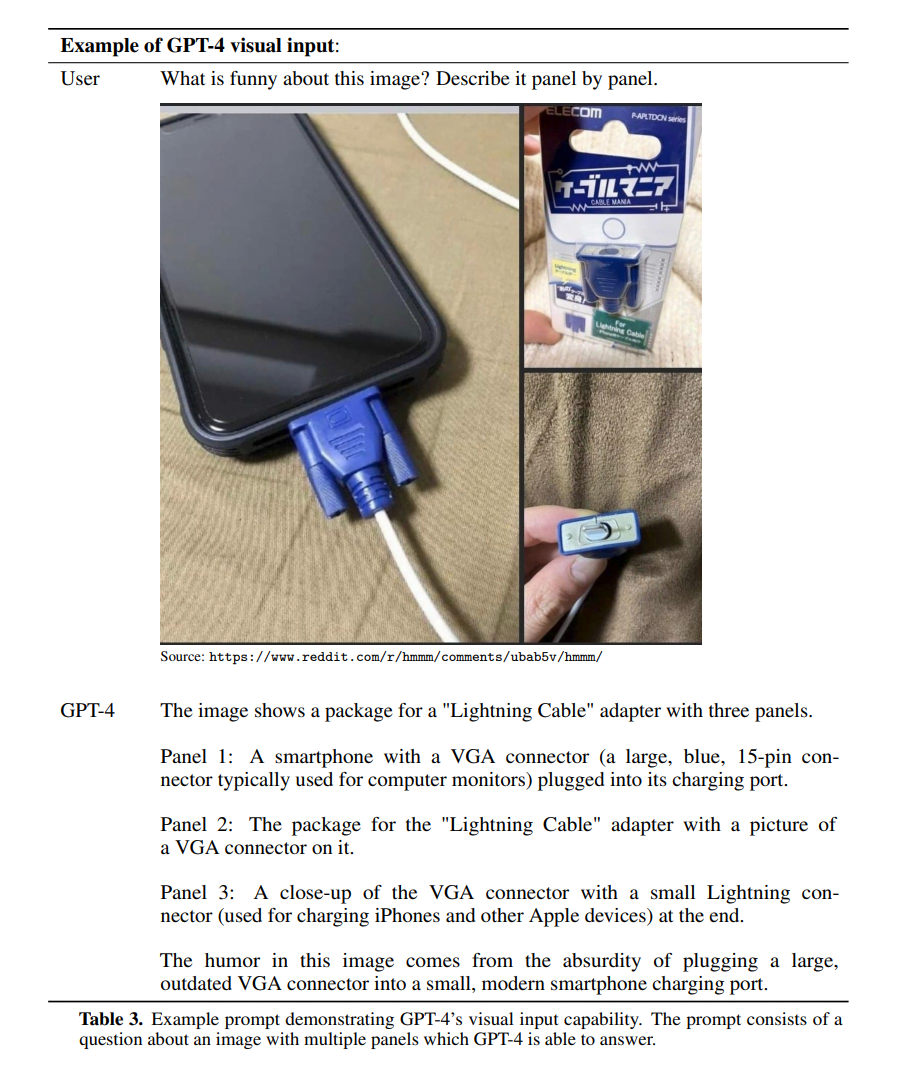

Zgodnie z zapewnieniami, GPT-4 ma być jeszcze sprawniejsze w generowaniu odpowiedzi i co istotne – w cały ten proces włączony zostanie zarówno tekst, jak i obraz. W praktyce oznacza to, że w formie inputu, przyjmowane będzie nie tylko słowo pisane… ale również i wgrywane pliki graficzne. Co nie powinno być przesadnie wielkim zaskoczeniem zważywszy na doświadczenie OpenAI w tej materii, jaką zdobyto podczas prac nad DALL-E. To, jak to działa w praktyce widać na poniższym obrazku.

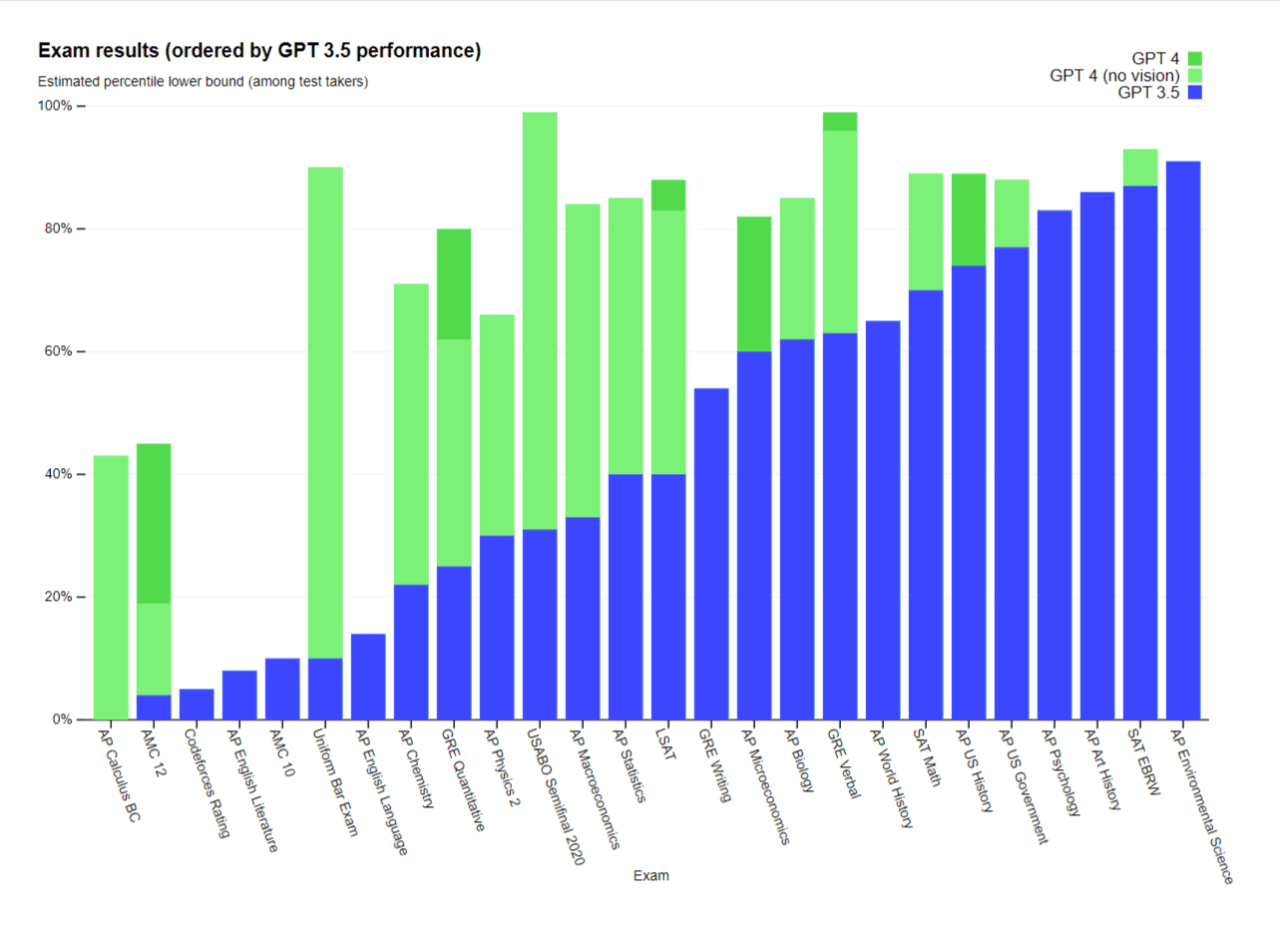

GPT-4 ma znacznie lepiej radzić sobie także z faktami oraz udzielaniem logicznych odpowiedzi… z czym poprzednie modele miały momentami ewidentnie spore problemy. Progres w tym zakresie najlepiej prezentuje chyba poniższy wykres, pokazujący jak poszczególne wersje GPT radzą sobie z różnymi testami oraz egzaminami. Różnica jest kolosalna, choć oczywiście należy brać poprawkę na to, że to wyniki opublikowane przez OpenAI i nie zostały one jeszcze potwierdzone przez niezależne ośrodki.

OpenAI opublikowało także krótki materiał promocyjny, pokazujący możliwości modelu GPT-4.

Brockman niedługo po ogłoszeniu udostępnił jeszcze jeden, bardzo interesujący post, wskazujący na możliwości, jakie dawać będzie osobom z wadą wzroku nowa funkcjonalność GPT-4 związana z obrazami. Rozwiązanie może okazać się autentycznym game-changerem, co widać także na poniższym nagraniu od Be My Eyes – aplikacji znanej pośród osób niewidomych i niedowidzących.

Jak uzyskać dostęp do GPT-4?

Ulepszone narzędzia trafią do szerszej dystrybucji dopiero za jakiś czas, ale subskrybenci ChatGPT Plus mogą przetestować GPT-4 w akcji już teraz. Greg Brockman zwrócił uwagę na to, że model może być jeszcze w pewnych kwestiach nieco ograniczony. Z biegiem czasu będzie jednak działał coraz sprawniej – to normalna kolej rzeczy.

Developerzy mogą także zapisać się do kolejki GPT-4 API, jeśli chcą otrzymać dostęp w pierwszej kolejności. W zgłoszeniu oprócz imienia, nazwiska oraz maila, trzeba podać ID przypisane do konta naszej organizacji. Jest on widoczny w panelu ustawień po zalogowaniu się na platformie OpenAI.

Jeżeli nie dysponujecie subskrypcją, możliwości GPT-4 będziecie mogli na żywo podejrzeć na specjalnej transmisji. Jej start zaplanowano na godzinę 21:00 polskiego czasu.