Naukowcy z Uniwersytetu Cornella opracowują wyjątkowe rozwiązanie problemów technologii silent speech, czyli tzw. cichej mowy. Chodzi tu o okulary wyposażone w sztuczną inteligencję, co umożliwia rozpoznawanie mowy poprzez analizę ruchów warg i ust.

EchoSpeech, bo tak nazwano to sprytne urządzenie, zostało stworzone przez Smart Computer Interfaces for Future Interactions na Uniwersytecie Cornell. Wynalazek otwiera drzwi do komunikacji dla osób niemogących wydobywać dźwięku.

Spis treści

Sztuczna inteligencja w obrębie zdrowia

W dzisiejszych czasach sztuczna inteligencja odgrywa kluczową rolę w rewolucjonizacji różnych dziedzin, w tym również, a może zwłaszcza, w sektorze zdrowia. Jednym z najbardziej fascynujących i obiecujących zastosowań sztucznej inteligencji w kontekście zdrowia jest silent speech technology, czyli technologia rozpoznawania cichej mowy. Co to takiego?

Interfejs cichej mowy (ang. Silent Speech Interface) to technologia umożliwiająca rozpoznawanie i interpretowanie mowy wypowiadanej w sposób bezgłośny, poprzez analizę ruchów ust, języka oraz innych obszarów twarzy.

Tradycyjne systemy rozpoznawania mowy wykorzystują zwykle wizualne sygnały, co sprawia, że konieczne jest stosowanie kamery. Nie jest to najbardziej praktyczne rozwiązanie. W przypadku zaś urządzenia EchoSpeech, naukowcy ze Smart Computer Interfaces for Future Interactions z Uniwersytetu Cornella, skupili się m.in. na ruchach warg.

Technologia interfejsu silent speech ma zastosowanie w przypadkach, gdy osoba nie może mówić lub nie chce mówić na głos, na przykład ze względu na utratę głosu, hałas otoczenia lub konieczność zachowania ciszy w różnych miejscach. Jest to szczególnie użyteczne dla osób z niepełnosprawnościami komunikacyjnymi oraz w środowiskach, gdzie tradycyjna mowa jest utrudniona lub niemożliwa.

Interfejs silent speech wykorzystuje zaawansowane technologie sztucznej inteligencji, w tym głównie algorytmy uczenia maszynowego, aby analizować i interpretować dane wizualne generowane przez ruchy twarzy. Dzięki temu umożliwia komunikację poprzez wybór odpowiednich gestów lub ruchów warg, które są przetwarzane na tekst lub inne formy komunikacji.

EchoSpeech rozpoznaje mowę niewerbalną

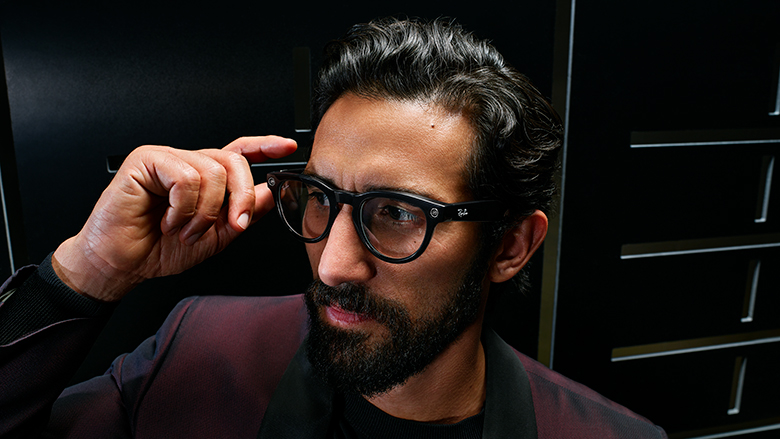

EchoSpeech wyglądem przypomina zwykłe okulary, do których ktoś przyczepił kilka kabelków. Może nie są najmodniejszym dodatkiem sezonu (jeszcze!), ale z całą pewnością wniosą wartość dodaną do życia osób, które z różnych powodów nie są w stanie w sposób werbalny wyrazić swoich emocji.

Wyjątkowe okulary z AI dają możliwość rozpoznawania cichej mowy poprzez analizę ruchów warg i ust. Dzięki wykorzystaniu zaawansowanych technologii akustycznych i sztucznej inteligencji, EchoSpeech pozwala użytkownikom komunikować się w sposób niemal bezgłośny, co ma ogromne znaczenie dla osób niemogących wydobywać dźwięków.

To rozwiązanie może rewolucjonizować życie osób, które z różnych przyczyn nie mogą używać tradycyjnej mowy. Dla osób z utratą głosu, problemy ze zdolnością do mówienia lub w środowiskach, gdzie mowa jest utrudniona lub niemożliwa, EchoSpeech staje się nieocenionym narzędziem komunikacji, o czym opowiada Ruidong Zhang podczas wydarzenia naukowego CHI 2023: The ACM CHI Conference on Human Factors in Computing Systems.

Badanie użytkowników przeprowadzone na 12 uczestnikach wykazało, że EchoSpeech jest w stanie rozpoznawać 31 izolowanych poleceń. Okulary z AI wykorzystują moc 73,3 mW, a informacje przekazywane są na wybrane urządzenie elektroniczne w czasie rzeczywistym.

Aplikacja demonstracyjna operowała na krótkich danych szkoleniowych (od 1 minuty do 6 minut). Dokładność zaś szacuje się na poziomie 95%. Eliminuje przy tym potrzebę noszenia kamery wideo, co przyczynia się do zwiększenia prywatności użytkowników.

Z drugiej strony, EchoSpeech może mieć ograniczenia w przypadku rozpoznawania bardziej skomplikowanych gestów lub w sytuacjach, gdzie użytkownik wykonuje ruchy ust niezwiązane z komunikacją. Okulary z AI projektu naukowców z Uniwersytetu Cornella zauważają, że ich urządzenie przebija inne rozwiązania ze względu na m.in. brak wymagań dotyczących noszenia kamery (kwestia bezpieczeństwa zarówno dla użytkownika, jak i dla osób, z którymi tenże wchodzi w interakcję) oraz niewymagane jest, aby użytkownik był zwrócony w stronę kamery.

Wszystko to dzięki wyjątkowej technologii wykrywania akustyki. Do prawidłowego funkcjonowania urządzenia wymagane jest zresztą jedynie coś, z czym większość społeczeństwa już się nie rozstaje – smartfon z Bluetooth. Dane nie są również transferowane w chmurę, lecz przetwarzane i procesowane lokalnie, na smartfonie użytkownika.

Jak działa EchoSpeech?

Okulary z AI są wyposażone w mikrofony i głośniki umieszczone wewnątrz oprawek, które rejestrują dźwięki otoczenia oraz subtelne fale dźwiękowe generowane przez ruchy warg i ust użytkownika. Następnie dane zarejestrowane przez mikrofony są przetwarzane przez wbudowany moduł sztucznej inteligencji, który wykorzystując zaawansowane algorytmy uczenia maszynowego, analizują otrzymywane sygnały akustyczne. Poprzez identyfikację wzorców związanych z ruchami warg i ust, system jest w stanie rozpoznać gesty i ruchy warg użytkownika.

Po rozpoznaniu gestów, EchoSpeech przekształca je na konkretne komendy lub polecenia. Na przykład, jeśli użytkownik wykonuje gest otwierania ust, system może zinterpretować to jako próbę otwarcia aplikacji lub wydanie komendy głosowej. W ten sposób użytkownik może komunikować się za pomocą gestów i ruchów warg, nawet w sytuacjach, gdzie tradycyjna mowa jest niemożliwa lub utrudniona.

Dla osób, które z różnych powodów nie potrafią wokalizować dźwięków, technologia cichej mowy może być doskonałym materiałem wejściowym dla syntezatora głosu.

Ruidong Zhang, doktorant w dziedzinie informatyki, Uniwersytet Cornell’a, cytowany przez news.cornell.edu.

Dzięki EchoSpeech osoby niemogące mówić mogą łatwo komunikować się z otoczeniem, odblokowywać swoje urządzenia elektroniczne, jak smartfony czy komputery oraz wykonywać różnorodne czynności, takie jak odtwarzanie muzyki czy sterowanie aplikacjami, za pomocą prostych gestów lub ruchów warg.

Zgodnie zaś z informacjami opublikowanymi na stronie Uniwersytetu Cornella, ich okulary z AI mogą funkcjonować aż 10 godzin! W porównaniu do standardowych rozwiązań, wymagających dostępu do kamery i opierających się na rejestrowaniu obrazu, wynik ten robi ogromne wrażenie. Ile działają takie urządzenia? Zaledwie 30 minut.

Okulary z AI powstały dla poczucia inkluzywności

Zespół naukowców oraz inżynierów pracujących nad projektem EchoSpeech skupiał się na różnych aspektach technicznych, w tym na doskonaleniu algorytmów analizy ruchów warg i ust, optymalizacji działania akustycznych czujników oraz integracji systemu z różnymi platformami elektronicznymi, takimi jak smartfony czy komputery.

Badania te przyniosły znaczące postępy w rozwoju tej technologii, pozwalając na skuteczne rozpoznawanie gestów i nawet subtelnych ruchów warg oraz na szybką i precyzyjną interpretację komend użytkownika. Dzięki badaniom technika ta stała się bardziej efektywna i przydatna dla osób z różnymi rodzajami niepełnosprawności komunikacyjnych oraz dla szerokiego spektrum użytkowników poszukujących wygodniejszych sposobów interakcji ze sprzętem elektronicznym.

Wyniki badań nad technologią EchoSpeech zostały zaprezentowane na prestiżowej konferencji naukowej, gdzie zespół naukowców miał okazję podzielić się swoimi osiągnięciami oraz zaprezentować działanie i potencjał tego innowacyjnego rozwiązania. Prezentacja wyników na tym wydarzeniu pozwoliła na uzyskanie opinii ekspertów z różnych dziedzin pokrewnych, w tym z dziedziny informatyki, sztucznej inteligencji oraz inżynierii, co stanowiło ważny krok w dalszym doskonaleniu technologii EchoSpeech oraz w promowaniu jej potencjalnych zastosowań i korzyści dla społeczeństwa.

Gdzie można zastosować okulary z AI?

Dzięki możliwości komunikacji za pomocą gestów i ruchów warg, użytkownicy mogą łatwo przekazywać informacje i wydawać polecenia w środowiskach, takich jak restauracje, lotniska czy miejsca pracy, gdzie hałas może być problemem. Dodatkowo EchoSpeech eliminuje potrzebę korzystania z klawiatury i myszy, co jest szczególnie korzystne dla osób z ograniczeniami ruchowymi lub dla tych, którzy szukają bardziej intuicyjnych sposobów interakcji ze sprzętem elektronicznym.

Jesteśmy bardzo podekscytowani tym systemem, ponieważ naprawdę popycha nas krok dalej w zakresie wydajności i prywatności. Nasze urządzenie jest małe, zużywa mało energii i zapewnia prywatność, a to cechy ważne przy wdrażaniu nowych, przenośnych technologii w świecie rzeczywistym.

Cheng Zhang, adiunkt informatyki w Cornell Ann S. Bowers College of Computing and Information Science oraz dyrektor SciFi Lab, cytowany przez news.cornell.edu.

W rezultacie EchoSpeech może poprawić jakość życia osób z różnymi rodzajami niepełnosprawności komunikacyjnych oraz zapewnić wygodniejsze i bardziej efektywne sposoby komunikacji dla szerokiego spektrum użytkowników. Dzięki temu innowacyjnemu rozwiązaniu, osoby niemogące mówić mogą cieszyć się większą niezależnością i samodzielnością w codziennym życiu, a także łatwiej nawiązywać relacje z innymi ludźmi oraz uczestniczyć w społeczeństwie.

Źródło: news.cornell.edu. Zdjęcie otwierające: obraz wygenerowany za pomocą DALLE-3