Choć czytanie w myślach brzmi raczej jak umiejętność wyrwana z mniej lub bardziej poważnych dzieł kultury, naukowcy z Duke University opracowali coś podobnego. Proteza mowy, bo o niej mowa, ma tłumaczyć sygnały mózgowe danej osoby na to, co próbuje powiedzieć. Szykuje się rewolucja i nowa nadzieja dla osób z zaburzeniami neurologicznymi upośledzającymi mowę.

Czytanie w myślach — Spis treści

Interfejs mózg-komputer i jego zastosowania

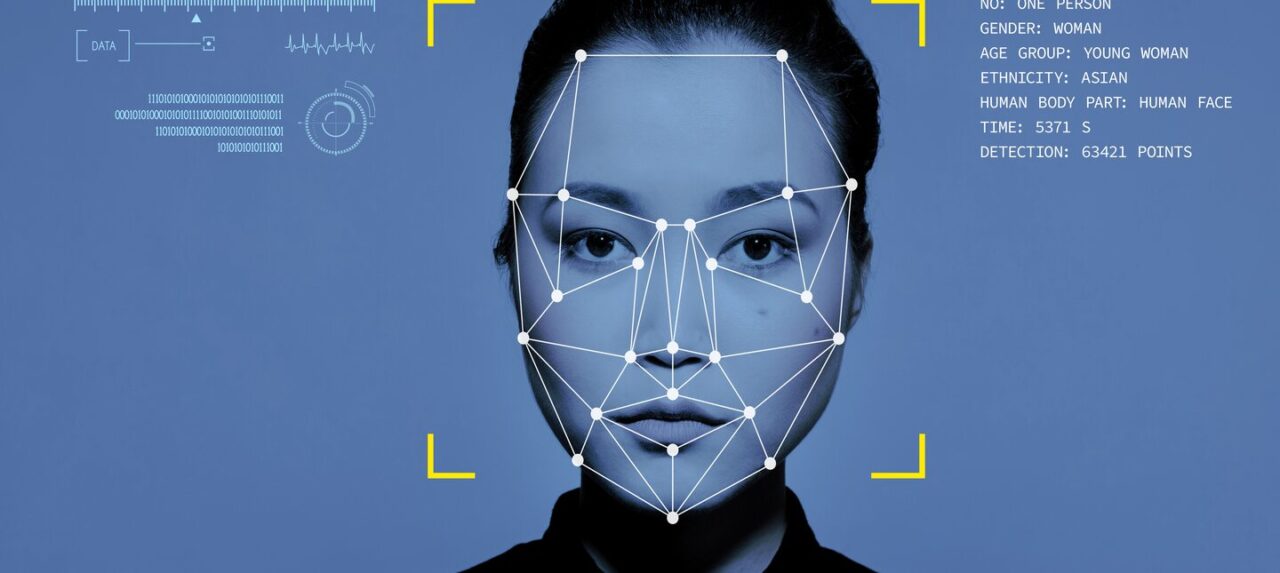

Brain-Machine Interface, czyli interfejs mózg-komputer jest technologią umożliwiającą bezpośrednią interakcję między mózgiem a komputerem lub innym urządzeniem elektronicznym. Jest to obszar badawczy, w którym sygnały elektryczne lub inne formy aktywności mózgowej (w naszym przypadku będą to fale mózgowe) są przetwarzane, aby umożliwić kontrolę pewnych urządzeń lub komunikację bez użycia tradycyjnych interfejsów fizycznych, takich jak klawiatura czy myszka. W rzeczywistości przypomina to czytanie w myślach.

Jeżeli chodzi o zastosowania interfejsów mózg-komputer są one różnorodne i obejmują przykładowo rehabilitację medyczną, są wykorzystywane w badaniach naukowych nad mózgiem, ale również umożliwiają komunikację osobom, które z powodu różnych chorób neurologicznych czy uszkodzeń nie są w stanie porozumiewać się w sposób tradycyjny. Szersze zastosowania będą wymagać dalszych badań, ale również rozwiązania wielu wyzwań, w tym etycznych.

Czytanie w myślach nie tylko dla superbohaterów

Jean Grey z „X-Men”, Edward Cullen z serii „Zmierzch”, Edward Nygma aka The Riddler z „Batmana” — to tylko garstka postaci fikcyjnych, których wyposażono w umiejętność czytania w myślach. Choć w przypadku protezy mowy opracowanej przez amerykańskich naukowców określenie czytanie w myślach to duże uproszczenie, z całą pewnością dostarcza podobnych wrażeń.

Zespół neurologów, neurochirurgów i inżynierów z Duke University postanowił opracować protezę mowy, która będzie w stanie przełożyć sygnały mózgowe danej osoby na to, co próbuje powiedzieć. Jak podaje czasopismo Nature Communications, ta technologia może pewnego dnia pomóc osobom z zaburzeniami neurologicznymi w odzyskaniu zdolności komunikowania się za pośrednictwem interfejsu mózg-komputer.

Wielu pacjentów cierpi na wyniszczające zaburzenia motoryczne, takie jak ALS (stwardnienie zanikowe boczne) lub zespół zamknięcia. Mogą one upośledzać zdolność mówienia. Obecnie dostępne narzędzia umożliwiające komunikację są na ogół bardzo powolne.

powiedział dr Gregory Cogan, profesor neurologii na Duke University’s School of Medicine, będący również jednym z głównych badaczy zaangażowanych w projekt. Cyt. NeuroScienceNews.

Opóźnienie w mowie z całą pewnością jest uciążliwe, a spowodowane jest częściowo stosunkowo niewielką liczbą czujników aktywności mózgu. Mniej czujników, to mniej czytelnych informacji do zdekodowania, jak podają eksperci z serwisu neurosciencenews.com. Eksperci porównują narzędzia do tego typu konwersji do audiobooka, gdzie czytelnik ustawia prędkość lektora na 0.5. To mniej więcej prędkość dekodowania mowy serwowana przez najlepsze obecnie urządzenia tego typu. Podpierając się liczbami — jeśli człowiek wypowiada około 150 słów na minutę, dekoder mowy „wypowiada” jedynie 78 słów.

256 czujników na plastiku wielkości… znaczka pocztowego

Pokonując wspólnymi siłami dotychczasowe ograniczenia, podjęto współpracę z dr. Jonathanem Viventi’m. Zintegrowano 256 mikroskopijnych czujników mózgowych na elastycznym fragmencie plastiku o wymiarach znaczka pocztowego.

Dr Viventi jest członkiem kadry Duke Institute for Brain Sciences z Karoliny Północnej i specjalizuje się w inżynierii biomedycznej. W jego laboratorium opracowywane są ultracienkie i elastyczne czujniki mózgowe. W opisywanym przypadku czujniki były oddalone od siebie na odległość ziarenka piasku, wykazując zróżnicowane wzorce aktywności podczas koordynowania mowy.

Po wyprodukowaniu nowego implantu, który później będzie odpowiadał za „czytanie w myślach”, przyszła kolej na nawiązanie współpracy z kilkoma neurochirurgami ze szpitala Duke University Hospital. Wśród nich wymienia się dr n. med. Dereka Southwella, dr n. med. Nandana Ladema oraz dr n. med Allana Friedmana. Ich zadaniem była pomoc naukowcom w rekrutacji czterech pacjentów do testowania implantów. Jeden z chirurgów porównał cały zabieg do… załogi pit-stopu.

Lubię porównywać ten proces do załogi pit-stopu NASCAR (przyp. red. NASCAR — Narodowa Organizacja Wyścigów Samochodów Seryjnych). Nie chcemy wydłużać procedury, dlatego musieliśmy wejść i wyjść w ciągu 15 minut. Gdy tylko chirurg i zespół medyczny powiedzieli „start”, natychmiast przystąpiliśmy do działania, a pacjent wykonał zadanie.

Powiedział dr Gregory Cogan.

Ograniczony czas z pewnością dostarczył chirurgom masę emocji!

Pacjentów poproszono o wykonanie dziwnego zadania

„Dziwne zadanie” polegało na tym, że pacjenci usłyszeli całą serię bezsensownych słów takich jak „ava”, „kug”, „vip”. Zostali następnie poproszeni o wypowiedzenie każdego z nich na głos. Naukowcy zarejestrowali aktywność kory motorycznej mowy każdego z ochotników. Jak się okazało, pacjenci skoordynowali prawie 100 mięśni, poruszając wargami, językiem, szczęką i krtanią.

Algorytm uczenia maszynowego miał dostarczyć informacji na temat tego, jak precyzyjnie może przewidzieć dźwięki, wyłącznie na podstawie zapisów aktywności mózgu. Co wynikło z przeprowadzonego eksperymentu?

Według szacunków procentowych poprawność zidentyfikowanych dźwięków wynosiła 84%. Procentowa dokładność spadła jednak o kilkadziesiąt punktów procentowych w momencie, gdy dekoder analizował dźwięki znajdujące się w środku lub na końcu bezsensownego słowa. Wyróżniono także problematyczne litery, które są do siebie podobne w wymowie, przykładowo „p” i „b„.

Naukowcy przeprowadzający eksperyment określili dokładność dekodera na poziomie 40%. Określono go jednak jako imponujący ze względu na fakt, że poprzednie osiągnięcia techniczne, polegające na przetwarzaniu mowy na mowę, zwykle wymagają zebrania danych obejmujących godziny, a nawet dni. Tutaj wystarczył 15-minutowy test i uzyskane w postaci 90 sekund mowy.

„Czytanie w myślach” już wkrótce?

Niekoniecznie. Projekt jest jeszcze w powijakach. Na ten moment wiadomo, że będzie on rozwijany dzięki dotacji Narodowego Instytutu Zdrowia w wysokości 2,4 miliona dolarów. W planach jest stworzenie bezprzewodowej wersji urządzenia. Dr Viventi dodał, że wciąż są na etapie, w którym ich urządzenie jest znacznie wolniejsze niż naturalna mowa. Naukowcy widzą jednak światełko w tunelu i drogę, dzięki której osiągną zamierzony cel.

Teraz opracowujemy tego samego rodzaju urządzenia rejestrujące, ale bez przewodów. Użytkownik będzie mógł się poruszać, nie będąc wciąż podpiętym do gniazdka elektrycznego. Jesteśmy naprawdę podekscytowani!

Powiedział dr Cogan, cytowany przez serwis NeuroScienceNews.

Źródło: neurosceincenews.com, Nature Communications