Fałszywe nagrania wykorzystujące deepfake to prawdziwa plaga, która nie tylko wprowadza internautów w błąd – może powodować poważne straty finansowe. Dopóki nie nauczymy się, jak je rozpoznawać, mamy problem. Naukowcy z IDEAS NCBR chcą pomóc go rozwiązać. Stworzyli prototypowy program ProvenView.

Spis treści

Deepfake – co to za technologia?

Deepfake to technologia, o której nie mogliście nie słyszeć. Jest to zaawansowana technika manipulacji materiałami wideo lub audio przy użyciu sztucznej inteligencji (AI). Dzięki niej tworzone są realistyczne i trudne do odróżnienia od oryginału fałszywe materiały multimedialne. I to właśnie stanowi największy problem – przestajemy odróżniać, kiedy na ekranie jest rzeczywista osoba, a kiedy postać wygenerowana przez AI.

Deepfejki stają się coraz bardziej zaawansowane, a ich wykrycie coraz trudniejsze, co stawia przed nami nowe wyzwania w zakresie bezpieczeństwa cyfrowego.

Badacze IDEAS NCBR cytowani przez PAP

Oczywiście sama technologia nie została stworzona jako narzędzie dla oszustów. Z powodzeniem wykorzystywana jest w branży rozrywkowej albo edukacji. Jednak przestępcy równie chętnie korzystają z niej do dezinformacji i manipulacji.

Przykłady wykorzystania deepfake z ostatnich miesięcy

W marcu 2024 roku krążyło fałszywe wideo z udziałem CEO InPost Rafała Brzoski, który namawiał na fałszywe inwestycje. Mieliśmy też deepfake z Zełenskim, na którym prezydent Ukrainy ma potwierdzać elementy rosyjskiej propagandy. Krążył też deepfake z merem Kijowa – fałszywy Witalij Kliczko miał dzwonić do burmistrzów Berlina, Madrytu i Wiednia. Albo spreparowane filmy dla dorosłych wykorzystujące deepfake i wizerunek amerykańskiej streamerki.

Olbrzymie straty poniosła też brytyjska firma ARPU, której pracownik został zmanipulowany podczas wideokonferencji i wypłacił 25 milionów dolarów oszustom. Oszuści podszyli się pod dyrektora finansowego firmy i innych pracowników, których ofiara znała.

Przykładów jest naprawdę wiele i wyraźnie widać, że deepfake jest olbrzymim problemem.

Program, który sprawdzi, czy rozmawiamy z prawdziwą osobą

Naukowcy z ośrodka badawczo-rozwojowego IDEAS NCBR mogą mieć dla nas rozwiązanie. Stworzyli prototypowy program do sprawdzania, czy przez kamerę online rozmawialiśmy z prawdziwą osobą, a nie deepfejkiem. Jego celem jest walka z oszustwami i ochrona wizerunku w sieci. W maju 2024 r.

Twórcami eksperymentalnego projektu o nazwie ProvenView są badacz podoktorski Shahriar Ebrahimi i doktorantka Parisa Hassanizadeh. To badacze z Iranu pracujący w grupie „Bezpieczeństwo systemów i prywatność danych” kierowanej przez prof. dr hab. Stefana Dziembowskiego.

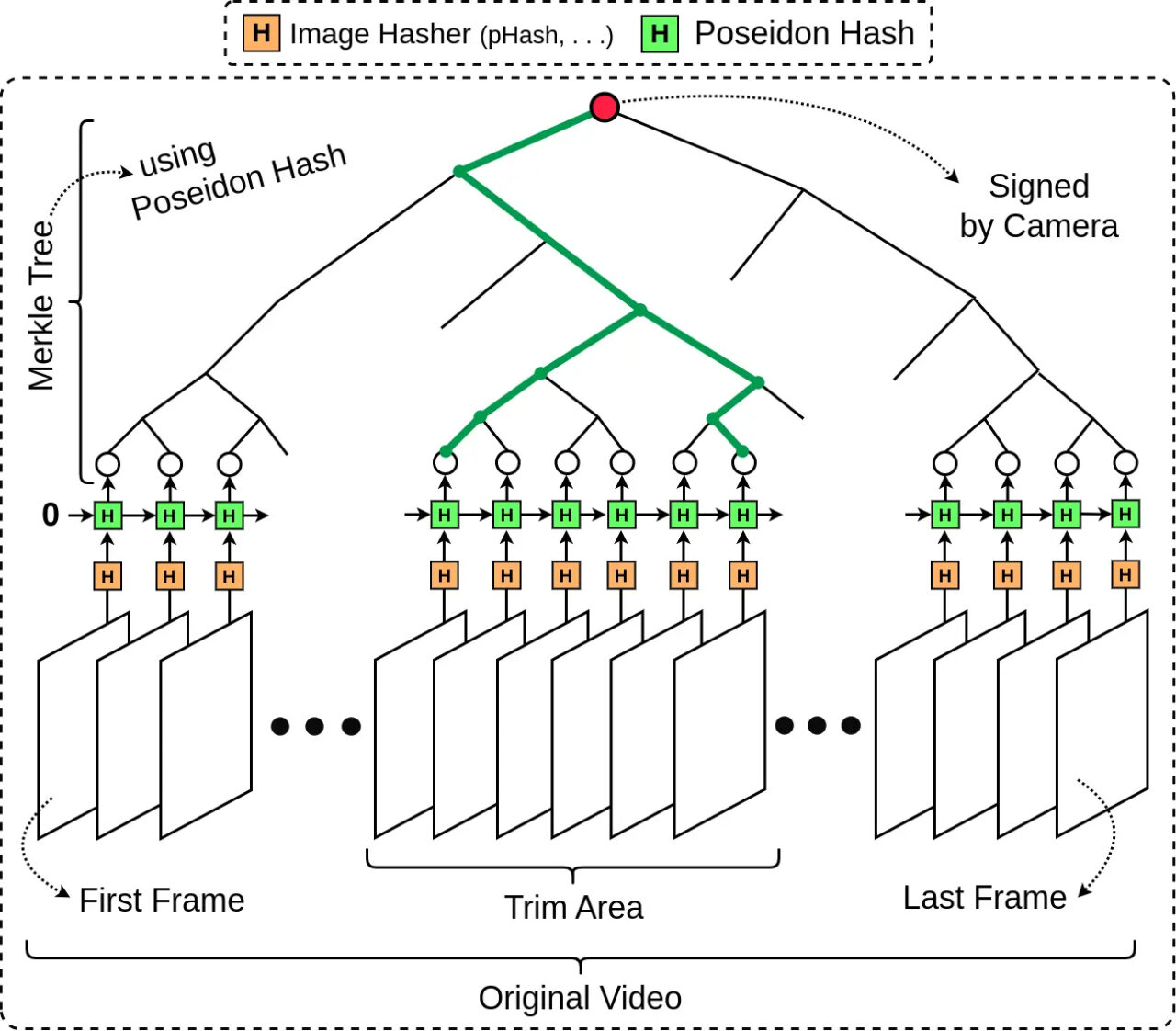

Opracowanie wykorzystuje Zero-Knowledge Proof (ZKP) – technikę kryptograficzną, która pozwala na udowodnienie prawdziwości pewnej informacji bez ujawniania szczegółów o niej.

Rozwiązanie ProvenView stanowi jeszcze jeden spektakularny przykład tego, jak ZKP może być wykorzystane w walce z zagrożeniami współczesnego świata cyfrowego.

prof. dr hab. Stefan Dziembowski z grupy „Bezpieczeństwo systemów i prywatność danych”

Jak zapewniają twórcy tego programu, ProvenView może znaleźć zastosowanie w interakcjach online i w ochronie treści. Na przykład po zakończeniu spotkania online użytkownik będzie mógł sprawdzić, czy wideo jego rozmówcy rzeczywiście pochodziło z jego kamery internetowej.

Jak działa ProvenView ?

Naukowcy podali uproszczony przykład działania ProvenView. W pierwszym kroku autor oryginalnego wideo tworzy dowód jego autentyczności – cyfrowy zapis potwierdzający, że materiał multimedialny jest jego autorstwa. Oprogramowanie umożliwiające taki zapis może być wbudowane w aplikację do nagrywania wideo lub być osobnym programem. Następnie, kiedy ktoś chce sprawdzić autentyczność wideo, może zobaczyć ten cyfrowy dowód.

To rozwiązanie może się przydać zarówno użytkownikom indywidualnym, którzy mogliby go użyć do autoryzacji spotkań online, jak i twórcom treści, którzy dzięki temu mogliby wzmocnić ochronę swojego wizerunku opublikowanego w filmie na YouTube przed kradzieżą i wykorzystaniem np. w pornografii.

Shahriar Ebrahimi z grupy „Bezpieczeństwo systemów i prywatność danych”

Na razie ProvenView to rozwiązanie w fazie eksperymentalnej, które nie jest jeszcze gotowe do wdrożenia. Co więcej, dowody autentyczności można generować dopiero po zakończeniu tworzenia wideo, a uzyskać je – by sprawdzić pochodzenie materiału multimedialnego – dopiero około godziny po odbyciu rozmowy.

Naukowcy z IDEAS NCBR mają nadzieję, że w przyszłości możliwe będzie udowadnianie autentyczności wideo w czasie rzeczywistym.

Źródło: Nauka w Polsce, IDEAS NCBR, Devfolio. Zdjęcie otwierające: CL STOCK / Shutterstock

Część odnośników to linki afiliacyjne lub linki do ofert naszych partnerów. Po kliknięciu możesz zapoznać się z ceną i dostępnością wybranego przez nas produktu – nie ponosisz żadnych kosztów, a jednocześnie wspierasz niezależność zespołu redakcyjnego.