Mogłoby wydawać się, że narzędzia, działające w oparciu o modele językowe, uczone na ogromnych zbiorach danych, nie powinny powielać żadnych stereotypów. Okazuje się jednak, że generatory wspomagane sztuczną inteligencją tworzą obrazy, które uwydatniają nierówności obecne w naszym społeczeństwie.

Takie wnioski płyną z badania przeprowadzonego przez naukowców z Akademii Leona Koźmińskiego. Z dr Anną Górską porozmawiałam o tym, dlaczego AI tworząc treści graficzne, stawia na bardzo wyraźną dominację mężczyzn i przez to ujawnia znaczne uprzedzenia związane z płcią.

AI faworyzuje mężczyzn – Spis treści

Niewidzialne kobiety: dlaczego sztuczna inteligencja zatrzymała się w czasach patriarchatu?

Jak sztuczna inteligencja „wyobraża sobie” osobę wykonującą zawód lekarza, prawnika czy naukowca? Z perspektywy osoby żyjącej w europejskim państwie XXI wieku, przypisywanie dziedzin takich jak medycyna, inżynieria czy prawo mężczyznom jest już w jakimś stopniu piętnowane – w końcu od lat propaguje się równość kobiet oraz mężczyzn i to nie tylko w sferze zawodowej. Od inicjalnych manifestacji w czasie pierwszej fali feminizmu w latach 40. XIX aż do teraz ruchy działające na rzecz kobiet nieustannie starają się zmienić krzywdzące stereotypy dotyczące płci.

Naturalne więc, że oczekiwalibyśmy, że w czasach współczesnych AI będzie odzwierciedlała te postępy społeczne. Niemniej jednak badania pokazują, że sztuczna inteligencja, ucząc się z historycznych i aktualnych zbiorów danych, może nieodpowiednio reprezentować rzeczywistość, nadal przedstawiając niektóre sfery życia przez pryzmat patriarchatu.

Tu nasuwa pytanie: czy postęp technologiczny w dziedzinie AI stanowi krok wstecz dla równości płci?

Jak AI wyobraża sobie prawnika i lekarza?

Na łamach „Feminist Media Studies” ukazał się artykuł pt. AI gender bias: Gendered perceptions of prestigious professions in artificial intelligence image generators (Stronniczość AI ze względu na płeć: postrzeganie prestiżowych zawodów w generatorach obrazów sztucznej inteligencji) dr Anny Górskiej we współpracy z prof. Dariuszem Jemielniakiem, dotyczący wyników badań analizujących uprzedzenia generatorów obrazów AI względem płci.

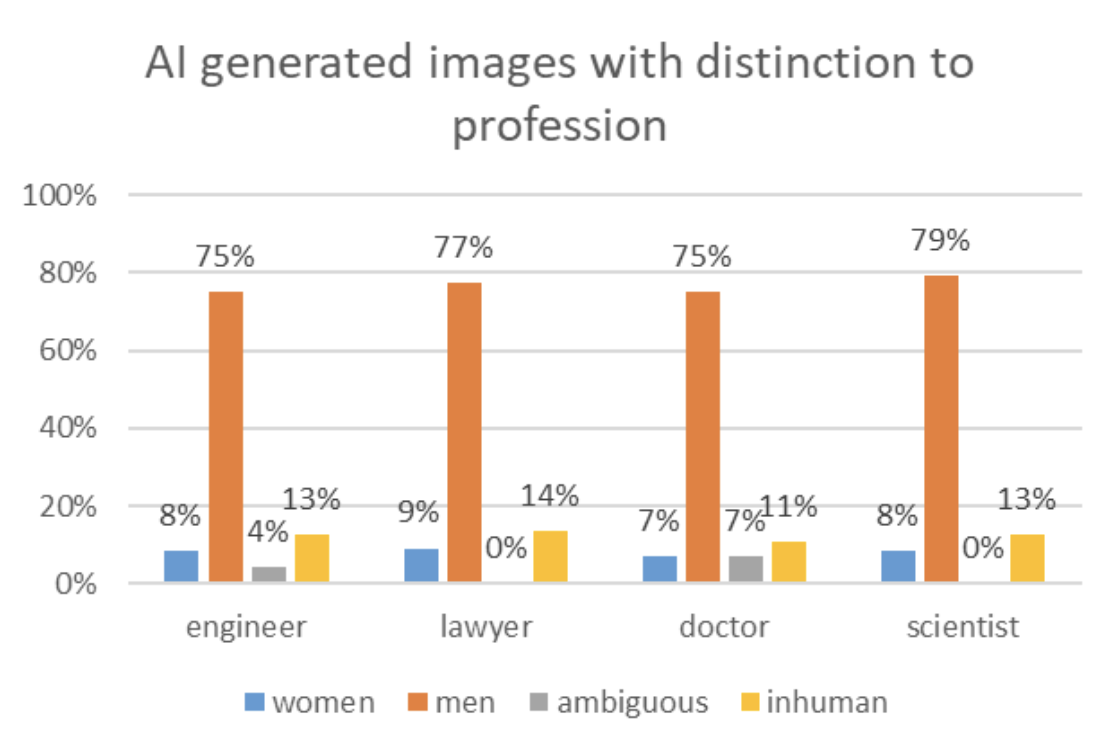

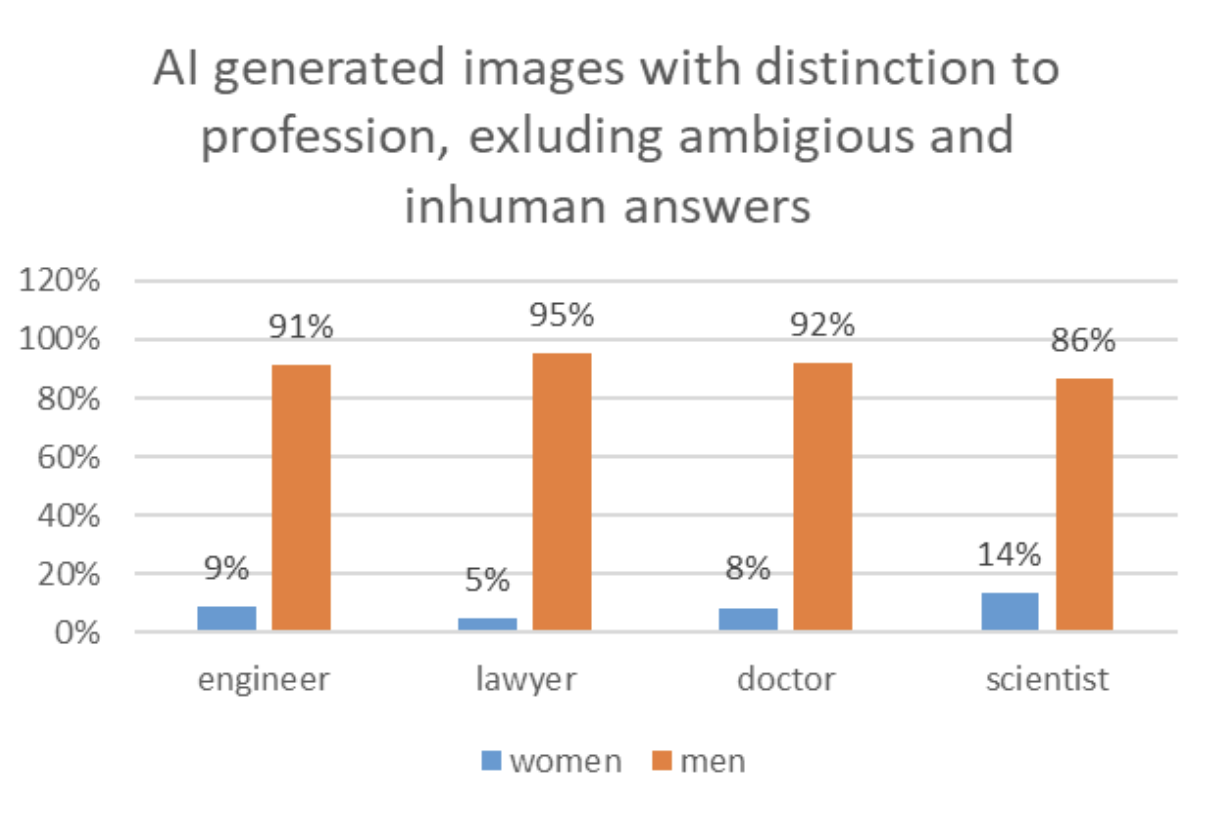

Naukowcy porównali dziewięć popularnych generatorów obrazów AI i sprawdzili, jak przedstawiają one wizerunki osób w czterech prestiżowych zawodach według Global Teacher Status Index (2018), takich jak: prawnik, lekarz, inżynier i naukowiec. Nazwy zawodów zostały podane w języku angielskim, aby uniknąć rozróżnienia na płcie. W sumie AI wygenerowała 99 grafik.

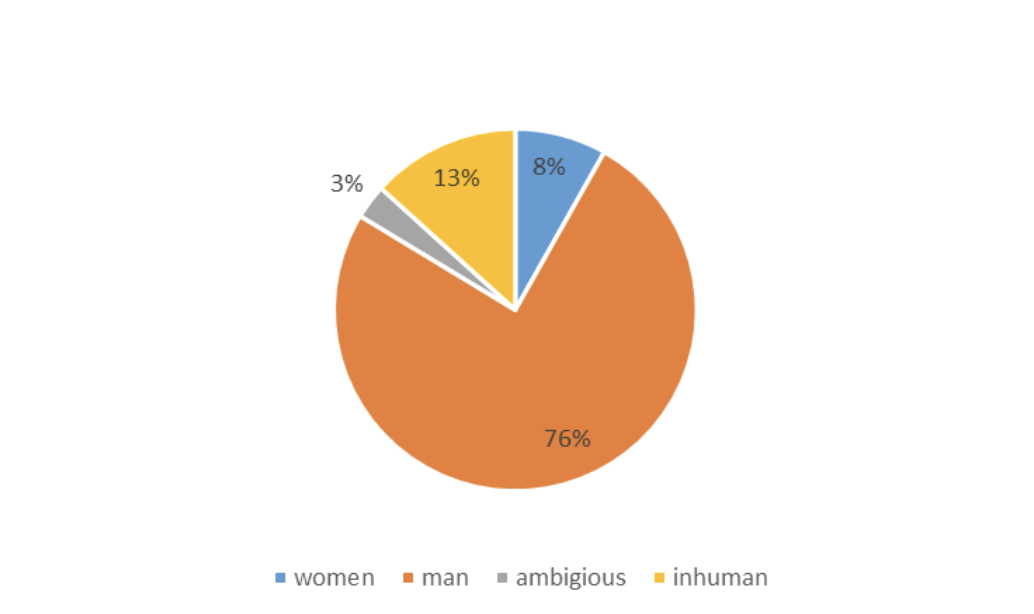

Następnie 120 respondentów miało ocenić grafiki, mając do wyboru jedną z czterech opcji: mężczyzna, kobieta, niejednoznaczne i nieludzkie. Analiza wykazała istotne uprzedzenia płciowe w kreowanych przez sztuczną inteligencję zdjęciach. Mężczyźni byli reprezentowani na 76% obrazów, a kobiety jedynie na 8%.

Problem leży w zbiorach danych

Systemy AI, takie jak modele generatywne, uczą się na podstawie dostępnych danych, które niestety często odzwierciedlają istniejące uprzedzenia i stereotypy. Jeśli większość danych historycznych i obecnych wskazuje, że te zawody są zdominowane przez mężczyzn, AI może nieświadomie reprodukować te wzorce, sugerując, że osoby wykonujące wskazane profesje są płci męskiej. To prowadzi natomiast do utrwalania stereotypów i mylnego przedstawienia rzeczywistości.

Zadałam dr Annie Górskiej kilka pytań dotyczących wpływu takiego stanu na przyszłość technologii, edukacji i wielu innych dziedzin życia społecznego.

Dominika Kobiałka: O tym, że AI ma upodobania względem płci czy rasy słyszymy od dawna. Pojawiają się różne opinie użytkowników narzędzi AI do generowania treści i obrazów, którzy testowali je i dzielili się czasem szokującymi wynikami w internecie. Tak jak wspomniała Pani Doktor w artykule, konstrukty społeczne widziane przez sztuczną inteligencję są bardzo częstym tematem analiz naukowców, a mimo tego takie badanie jak Pani i Pani zespołu jeszcze nie powstało. Co skłoniło Państwa do jego przeprowadzenia? Czy wydarzyło się coś, co stało się punktem wyjścia dla takiej analizy? Innymi słowy – skąd pomysł na taki temat pracy?

Dr Anna Górska: Z naukowego punktu widzenia, to oczywiste, że do tej pory tego nie badano. Do tej pory widziane to było to z punktu widzenia narzędzi generatywnej sztucznej inteligencji dotyczącej tekstu– sprawdzano, jak to wygląda w wyszukiwarkach internetowych, w tłumaczach, ale nikt nie analizował tego w narzędziach do generowania obrazów. Druga rzecz to czysta ciekawość naukowa. Z prof. Jeleniakiem byliśmy szczerze zainteresowani, jak generatory poradzą sobie z takim problemem.

Nie było zaskoczenia, kiedy wygenerowanych zostało tak dużo mężczyzn. To, co było dla nas zadziwiające, to fakt, że otrzymaliśmy więcej obrazów abstrakcyjnych (w których płci nie dało się określić) niż kobiet.

Dominika Kobiałka: Ciekawi mnie, czy przygotowując się do przeprowadzenia badania, już wstępnie wiedziała Pani Doktor, że ta nierówność pojawi się w aż takim stopniu?

Dr Anna Górska: Ja wiedziałam, że sztuczna inteligencja będzie „skrzywiona” w stosunku do płci żeńskiej, więc miałam świadomość, że kobiet będzie znacząco mniej. Sztuczna inteligencja jest karmiona danymi, które pozyska. A te same w sobie są już dosyć mocno nierówne. Natomiast absolutnie nie spodziewałam się, że będzie to aż w takim stopniu – prawie 80% to obrazy przedstawiające mężczyzn, a tylko 8% kobiet.

„Sztuczna inteligencja to papierek lakmusowy naszego społeczeństwa”

Dominika Kobiałka: W artykule zaznacza Pani Doktor, że powszechne przekonanie, że algorytmy i sztuczna inteligencja są z natury obiektywne, jest błędne. Jaka jest metoda, aby lepiej wyszkolić narzędzia AI w zakresie większej równości? I przede wszystkim: jak to zrobić dobrze, tak aby obrazy czy treści odzwierciedlały rzeczywistość, a nie stawały się „za bardzo inkluzywne”?

Odnoszę się tutaj do problemu, w którym m.in. Google Gemini unika pokazywania białych mężczyzn. Narzędziu zarzuca się wręcz „różnorodność na siłę”. Chodzi o tworzenie obrazów, które nie są nawet zgodne z prawdą, np. na prośbę wygenerowania pary z okresu Cesarstwa Rzymskiego, dostajemy obraz białego mężczyzny i czarnoskórej kobiety (lub odwrotnie) co jest błędem merytorycznym. Czy ma Pani jakieś zalecenia dla organizacji i instytucji – jak mogą one przeciwdziałać uprzedzeniom w technologii AI?

Dr Anna Górska: Przede wszystkim wymagane jest lepsze oprogramowanie, stworzone na bardziej jakościowych danych. To, co zaprezentowało Google Gemini, to nie jest najlepsze rozwiązanie.

Tak naprawdę sztuczna inteligencja to jest papierek lakmusowy naszego społeczeństwa. AI odzwierciedla to, że mamy niesprawiedliwe i nierówne społeczeństwa.

Oprócz analiz dotyczących płci, mamy przecież także badania dotyczące kolorów skóry reprezentowanych przez AI. Większość narzędzi do generowania obrazów na hasło „mężczyzna” pokazywała białego przedstawiciela płci męskiej. Osób, które nie miały białego koloru skóry, był tylko mały odsetek, a doskonale wiemy, że rzeczywista proporcja jest zupełnie inna. Sztuczna inteligencja tego też nie odzwierciedla.

AI jest skrzywiona wedle naszego anglosaskiego, zachodniocentrycznego modelu. Prosty przykład: proszę pozwolić AI wygenerować „tradycyjną suknię ślubną”. Co zaprezentuje? Białą, długą suknię. A kiedy pokaże się jej inną tradycyjną suknię ślubną, bogato zdobioną lub czerwoną, np. z Pakistanu czy Indii, to AI uzna to za… kostium.

Dzieci uwierzą w to, co pokaże im AI

Dominika Kobiałka: Widzę jeszcze jeden aspekt tego problemu. Obecnie AI funkcjonuje dla nas jako narzędzie komplementarne w trakcie pracy czy nauki. Bardzo szybko może się to jednak zmienić i chatboty staną się głównym źródłem informacji. Biorąc pod uwagę aspekt edukacyjny takich systemów, wystarczy wyobrazić sobie sytuację, w której zamiast spojrzeć na obraz w podręczniku (jeśli jeszcze takowe będą), dziecko będzie chciało dowiedzieć się, jak wyglądał naukowiec w XXI wieku (lub ang. scientist – dla zachowania neutralności płci).

Na grafice z dużą dozą prawdopodobieństwa zobaczy mężczyznę i na tej podstawie będzie budowało sobie obraz świata, także tego historycznego. Jakie jeszcze inne zagrożenia widzi Pani w takich uprzedzeniach kreowanych przez sztuczną inteligencję?

Dr Anna Górska: To jest fakt, że dla dzisiejszej młodzieży świat internetowy i świat sztucznej inteligencji jest zupełnie naturalny. Tak jak my szukamy czegoś w Google, oni szukają w ChatGPT. Wiele z nich będzie traktowało to jako wiedzę absolutną. Nie chodzi tylko o to, że AI pokazuje nierówności płciowe, bo – jak pokazały badania – dzieje się coś dużo gorszego: ona też je pogłębia.

Tak jak swego czasu media, książki czy telewizja utrwalały stereotypy ról płciowych i pokazywały, jakie były oczekiwania wobec ludzi, tak samo teraz robi to sztuczna inteligencja.

Dziewczynka, kiedy zobaczy za pośrednictwem AI, że naukowiec to taki przysłowiowy „pan z brodą”, pomyśli: może to nie dla mnie, może powinnam wybrać inny zawód. Ten problem opisują badania, nie są to tylko nasze przypuszczenia.

Dzieciom pokazywano książeczki, które były stereotypowe pod względem płci i profesji, utrwalały dominację mężczyzn. Im dłużej dzieci miały styczność z takimi treściami, tym częściej wyobrażały sobie i malowały tego naukowca jako mężczyznę. Kiedy w treści zaczyna wkradać się różnorodność, wtedy perspektywa dzieci się zmienia. Z tego rodzi się także głębokie uczucie dotyczącego tego, kim ja mogę być w przyszłości, gdzie jest moje miejsce i krąg ludzi, w którym mogę się odnaleźć.

Jeżeli sztuczna inteligencja będzie pokazywała te stereotypy, będzie je pogłębiała, no to niestety – chyba się cofniemy.

Dominika Kobiałka: W zupełności się z Panią zgadzam. Trzeba pracować nad tym, żeby narzędzia AI były bardziej inkluzywne. Serdecznie dziękuję za rozmowę.

Dr Anna Górska: Również bardzo Pani dziękuję.

Odpowiedzielność spoczywa na ludziach, a nie na AI

Jaka jest recepta na ten problem? Aby zmierzyć się z wyzwaniem, konieczne jest świadome kształtowanie zbiorów danych i algorytmów AI, tak by odzwierciedlały one zróżnicowaną reprezentację płci w różnych zawodach. Ale, jak już zdążyliśmy zauważyć, nie chodzi tylko o płeć, ale także o rasę czy mniejszości społeczne.

Na koniec moja rozmówczyni przytacza anegdotę. Sheryl Sandberg, była prezeska Facebooka, kiedy była w zaawansowanej ciąży, miała problemy, żeby dostać się z parkingu do biura. Poszła więc do swojej rady nadzorczej i powiedziała: „Słuchajcie, musimy zrobić parkingi dla kobiet w ciąży”. Na co oni odpowiedzieli: „Jasne, nie ma problemu. My o tym wcześniej nie pomyśleliśmy”. Dlatego właśnie tak ważne jest, żeby mieć kobiety na różnych szczeblach w instytucjach, bo dopóki kogoś nie dotyczy dany problem, to po prostu się o tym nie pomyśli. Gdyby w IT było więcej programistek, to reprezentacja byłaby bardziej równościowa.

Rozwijanie metod minimalizacji uprzedzeń i promowanie różnorodności w danych są kluczowe, by AI wspierała postęp społeczny, a nie cofała go. Wprowadzając te zmiany, sztuczna inteligencja może stać się narzędziem propagującym równość płci, a nie przeszkodą na tej drodze.

Źródło: oprac. własne. Zdjęcie otwierające: Obraz wygenerowany za pomocą DALL-E

Część odnośników to linki afiliacyjne lub linki do ofert naszych partnerów. Po kliknięciu możesz zapoznać się z ceną i dostępnością wybranego przez nas produktu – nie ponosisz żadnych kosztów, a jednocześnie wspierasz niezależność zespołu redakcyjnego.