NVIDIA ACE, czyli autorski silnik do generowania mówiących NPC w grach, rozwija się w zatrważającym tempie. Oprócz nowych kart graficznych GeForce RTX 40 Super, na trwającym CES 2024 zobaczyliśmy również demo dwóch mikrousług dla twórców gier, mających ułatwić proces kreacji postaci NPC. Nie wiem jak wy, ale szczerze mówiąc, chciałbym, aby sztuczna inteligencja trzymała się z dala od branży gier.

Postępy NVIDIA w zakresie AI — Spis treści

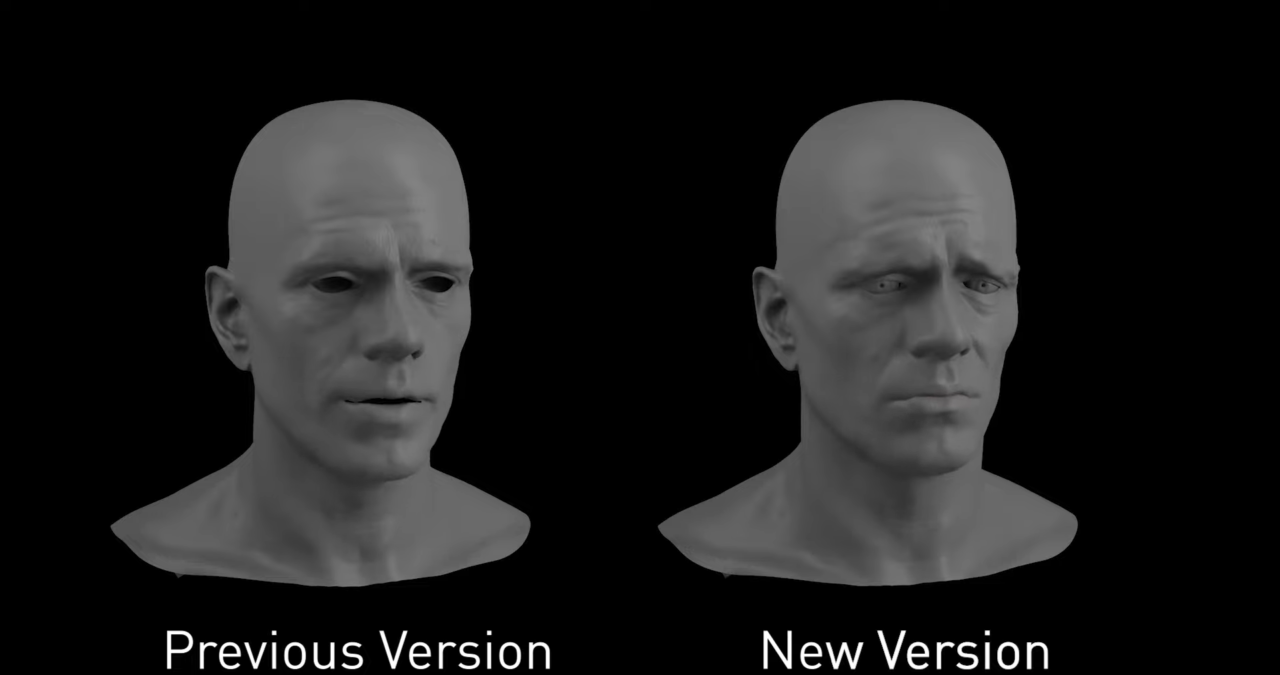

NVIDIA pokazuje tłumaczenie mowa-twarz, także na inne języki

NVIDIA Audio2Face to model AI, którego zadaniem jest przełożenie otrzymanej próbki dźwiękowej na rzeczywiste ruchy twarzy wymodelowanej przez nas postaci NPC. Na poniższym filmie możecie zobaczyć, jak AI dostosowuje poszczególne suwaki do otrzymanej treści, by właściwie wpłynąć na wyrażane przez postać emocje. Oczywiście, twórca może potem usiąść do pracy i edytować reakcje w poszczególnych sekundach tak, by odzwierciedlały one zamierzony efekt.

Jeżeli myślimy o tym narzędziu w kontekście zwykłych NPC, przechodniów na mieście, z którymi do tej pory nie mogliśmy wchodzić w interakcje, ma to oczywiście sens. Twórcy mają również do dyspozycji NVIDIA Riva Automatic Speech Recognition. To narzędzie do tworzenia aplikacji rozpoznających mowę i wykonywania generatywnych tłumaczeń na inne języki. Pomysł na udostępnienie takich narzędzi brzmi świetnie, aczkolwiek jako gracz mam mnóstwo obaw.

AI stanowi niebezpieczeństwo dla gier jako sztuki

Niestety, branża gier wielokrotnie nam już pokazywała, że gdy pojawia się możliwość oszczędności, wydawcy korzystają z niej aż za bardzo. Prosty przykład? Gdy konsole nie miały dostępu do internetu, gra musiała być działająca i gotowa w dniu premiery. Dziś nie jest to oczywistość, bo producenci często każą czekać miesiącami na łatki, umożliwiającą w pełni komfortową zabawę. Dlatego sytuacji nie pomaga fakt, że AI powoli zakrada się nawet do największych gier.

W takim The Finals, komentatorzy meczów są w pełni obsługiwani przez mowę generowaną w sztucznej inteligencji, przez co brzmią… sztucznie. Ograniczona, lecz bardziej ekspresyjna ścieżka nagrana przez rzeczywistego aktora głosowego nie zaburzałaby klimatu telewizyjnych rozgrywek. Posłuchajcie zresztą poniżej sztucznej mowy komentatorów w The Finals.

Obawiam się, że wraz z udostępnieniem takiego narzędzia szerszej publice, znajdzie się wydawca, który zrezygnuje z zatrudnienia aktorów dla głównych postaci w grze i zamiast tego, wygeneruje je z pomocą sztucznej inteligencji. Tu warto zaznaczyć, że z opisywanego narzędzia korzysta już m.in. Ubisoft, wydawca odpowiedzialny za takie serie jak Assassin’s Creed oraz Far Cry. To nie powinno być dla wielu graczy zaskoczeniem, gdy mówimy o wielkich, otwartych światach przez studia tego wydawcy.

Zdjęcie otwierające: NVIDIA / materiały prasowe

Część odnośników to linki afiliacyjne lub linki do ofert naszych partnerów. Po kliknięciu możesz zapoznać się z ceną i dostępnością wybranego przez nas produktu – nie ponosisz żadnych kosztów, a jednocześnie wspierasz niezależność zespołu redakcyjnego.