AI w ostatnim czasie zyskało na popularności m.in. za sprawą dopracowanych LLM (dużych modeli językowych). Wielkie modele językowe jak ChatGPT wykorzystywane są w coraz szerzej i w coraz większej liczbie miejsc, także w świecie polityki. W spocie posła PiS Piotra Saka zobaczyć można karykaturą Donalda Tuska, która mówi wygenerowanym głosem. PO również „przyłapano” na korzystaniu z AI. W kampanii #MailePrawdy sztuczna inteligencja czyta wiadomości głosem polityków PiS. Między innymi o zagrożenia z tym związane zapytałem Michała Chodakowskiego, prezesa Silver Bullet Solutions, firmy, która od lat specjalizuje się w rozwoju sztucznej inteligencji.

Spis treści

AI w służbie polityków. Wywiad z Michałem Chodakowskim

AI w kampaniach wyborczych — skuteczna metoda na pozyskanie głosów

Krzysztof Wilamowski: Jak AI może być wykorzystane w kampaniach wyborczych, aby przekonać jak największy elektorat?

Michał Chodakowski: Zanim przejdziemy do szczegółowego przepisu na mandat parlamentarny „made by AI”, warto zwrócić uwagę, że nie każde użycie AI w celach politycznych musi być klasyfikowane jako manipulacja […] Jeśli przyjąć, że celem uprawiania polityki jest możliwie najlepsze zadbanie o dobro ogółu, to tu jest wielkie pole do popisu dla technologii sztucznej inteligencji. Jednym z klasycznych zadań stawianych przed taką technologią jest odnajdowanie zależności […] Analizowane takimi metodami zjawiska mogą dotyczyć niemal każdej dziedziny życia, w tym takich, które są przedmiotem zainteresowania polityków. Mam tu na myśli ekonomię, procesy społeczne, demografię, etc. Jest to polityczne użycie sztucznej inteligencji całkowicie etyczne i wręcz niosące potencjalną wartość dla społeczeństwa.

Sztuczna inteligencja może być wykorzystywana do analizy zjawisk, ich prognozowania, a także wpływania na rzeczywistość. Jej cechą charakterystyczną jest […] szybkość działania. A szybkość jest w zasadzie jedynym sposobem, aby uzyskać kontrolę nad światem generującym gigantyczne ilości danych. Przepisem na popularność od zawsze jest populizm. Problem polega na tym, że ludzie są bardzo różni. I to jest pierwszy moment, w którym z pomocą przyjść może sztuczna inteligencja. Dzięki niej możliwe jest bardzo szczegółowe analizowanie zachowań, nawet niewielkich grup społecznych, a nawet poszczególnych ludzi, w celu zrozumienia nie tylko – co jest dla nich ważne, ale także sposobu argumentacji, jaki może być skuteczny. Analizować można także temperament, język, zainteresowania, sympatie sportowe, gusta muzyczne, itd. A po co to wszystko? Tu przechodzimy do drugiego, być może kluczowego, elementu. Chodzi mianowicie o kształtowanie rzeczywistości lub … iluzji rzeczywistości.

Wszystkie partie polityczne obiecują, że jeśli wygrają, to będzie nam się żyło lepiej, wszyscy będą bogatsi, szczęśliwsi, a wolność i demokracja będą kwitły. Niemal wszyscy też ostrzegają, że jak wybiorę innych, to klęska będzie straszna, kraj runie, a władza będzie naród poniewierać bezkarnie. Jak tu więc zdecydować, kogo wybrać, komu zaufać? O naszych wyborach politycznych w przeważającej części decydują emocje, a nie racjonalna analiza. Sympatie to rzecz indywidualna. A polityk potrzebuje poparcia powszechnego, wszystkich, im więcej, tym lepiej […] polityczny bohater musi mieć wiele twarzy, wiele osobowości.

Już w latach 90-tych XX wieku mówiło się o tym, że jeśli czegoś nie ma w Internecie, to nie istnieje. W sieci jest elektorat, jeśli nie cały, to jego część wystarczająco duża, aby narzucić poglądy całej reszcie. Jak to wykorzystać? Przede wszystkim trzeba ów elektorat zbadać i zrozumieć. Najważniejsze są emocje. Trzeba sprawdzić, co ludzie lubią […] Negatywne emocje też są ważne. Sprawny polityk — manipulator będzie używał negatywnych skojarzeń, aby podkopać wizerunek politycznej konkurencji. W domenie AI pomiar emocji nazywa się badaniem sentymentu. Ważne, aby sentyment prawidłowo zmierzyć, przypisać do konkretnych zjawisk i ich cech, wyróżnić osoby odczuwające taki sentyment i zaadresować ich potrzeby. Takie działanie nazywa się profilowaniem. Gdy już zbudujemy profile poszczególnych grup społecznych, a nawet poszczególnych osób, należy stworzyć postaci, osobowości im bliskie.

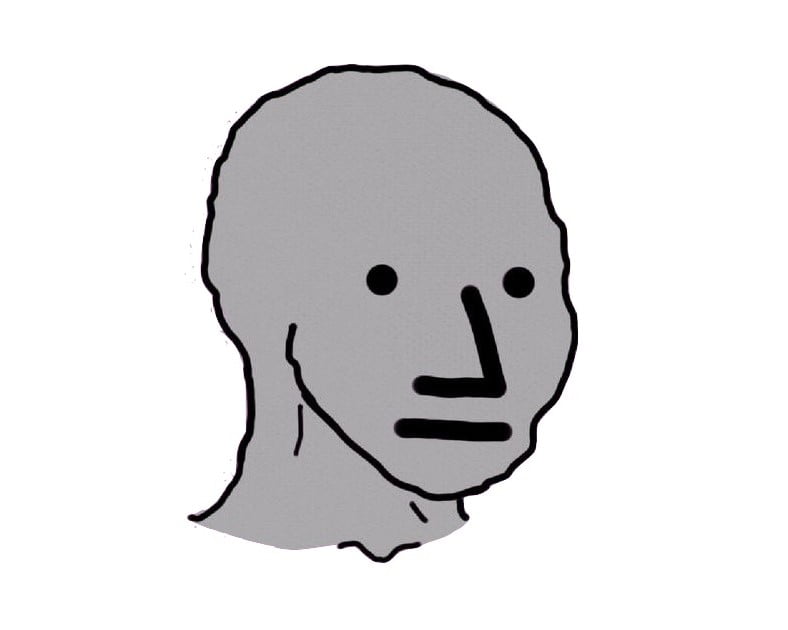

Powstają zatem tysiące postaci, osobowości, charakterów, historii. Tylko żadna z nich naprawdę nie istnieje. Wszystkie są wytworem sztucznej inteligencji, idealnie dopasowanym do potrzeb swoich odbiorców. W świecie gier komputerowych dla opisania takich postaci używa się pojęcia NPC (non-player character). Dzięki najnowszym osiągnięciom AI (LLM) łatwo już można sobie wyobrazić, że nasze NPC działają całkowicie autonomicznie, stając się aktywnymi uczestnikami różnego rodzaju forów dyskusyjnych, publikując własne treści we wszelkich mediach społecznościowych czy nawet nawiązując bezpośredni kontakt z konkretnymi użytkownikami.

To o wiele więcej niż tzw. Farmy internetowych trolli. Nasze NPC, dzięki zastosowaniu LLM są inteligentne, potrafią prowadzić dyskusje niemal na każdy temat, potrafią sensownie argumentować, znajdywać przykład (prawdziwe lub zmyślone) na poparcie swoich tez. No i oczywiście mają wyraźne preferencje polityczne […] I, pomimo że nie mają prawa wziąć udziału w głosowaniu, mogą w znaczący sposób wpłynąć na jego wynik.

LLM na obecnej scenie politycznej

KW: Jak te działania są wykorzystywane już teraz na scenie politycznej w naszym kraju?

Odrębne zagadnienie stanowi wykorzystanie technologii do manipulacji wyborczych. Właśnie kilka dni temu Prezydent RP ogłosił termin wyborów parlamentarnych. Wiemy już, że przyjdzie nam głosować za niespełna 2 miesiące. To pewnie zbyt późno, aby budować programy polityczne w oparciu o zaawansowane technologicznie i wielowariantowe analizy.

Powszechną, choć niechlubną, praktyką polityków jest oczernianie swoich konkurentów. Często w kampanii przywoływane są kompromitujące lub po prostu sprzeczne z oficjalnym programem wypowiedzi liderów. Media lubują się w ich powielaniu […] A jeśli akurat nie mamy pod ręką niewygodnej wypowiedzi naszego politycznego adwersarza? Wobec fascynacji osiągnięciami OpenAI i nieustannego badania granic możliwości ChatGPT niewielu zwróciło uwagę na ogłoszenie w styczniu 2023 roku przez Microsoft powstanie modelu językowego zwanego VALL-E. Jego zadaniem jest konwersja tekstu na mowę, czyli odczytywanie na głos tekstów. Przełomową w działaniu VALL-E jest jednak jego umiejętność symulowania głosu dowolnej osoby.

Co więcej, VALL-E potrafi głosem wyrażać emocje w sposób podobny, jak robi to oryginalny mówca. Potrafi nawet oddać otoczenie akustyczne wypowiedzi. Cóż to oznacza dla polityków pozbawionych hamulców etycznych? Wystarczy wziąć dowolną 3-sekundową wypowiedź politycznego przeciwnika wygłoszoną […] zastanowić się, jakie treści byłyby dla tego polityka kompromitujące i voilà – kompromitujące odkrycie jest gotowe po kilku sekundach.

A potem wspierające nas NPC dzielą się w tajemnicy w mediach społecznościowych swoim zdobytym z zaufanych źródeł odkryciem. W tych wyborach możliwa jest manipulacja na niespotykaną wcześniej skalę. Czy któraś z partii politycznych wykorzysta techniki manipulacji, aby wygrać wybory tej jesieni? Czy jakieś obce państwa będą chciały i potrafiły skorzystać z technologii, aby osiągnąć własne cele polityczne? Tego, oczywiście, nie wiem. Myślę jednak, że warto mówić o możliwościach właśnie po to, aby uświadomić sobie skalę potencjalnej manipulacji i jej nie ulec.

Przyszłość LLM w wyborach

KM: Teraz dopiero rozpoczynamy życie w rzeczywistości politycznej wspieranej przez AI, ale za kilka lat to będzie zapewne absolutna norma. Jak Pańskim zdaniem będą wyglądały kolejne polskie wybory, gdy AI już rozgości się na dobre w planach kampanii wyborczych?

Przełomowy w tym zakresie ChatGPT firmy Open AI ujrzał światło dzienne zaledwie 9 miesięcy temu. Wciąż raczej uczymy się nowej rzeczywistości. Paradoksalnie, może się okazać, że największe zagrożenia dla demokracji dotyczą najbliższych politycznych wydarzeń. Dziś bowiem powszechne wykorzystanie AI jest nowością, więc łatwo nas zmylić. Niewielu ma świadomość, jak głęboko mogą sięgać manipulacje oparte o całe spektrum technologii sztucznej inteligencji. Za kilka lat dzisiejsza nowość stanie się codziennością. Nauczymy się nieufności tam, gdzie dziś mamy pełne zaufanie.

Ponadto spodziewam się, że w najbliższym czasie wprowadzone zostaną regulacje prawne porządkujące obszar wykorzystania AI. Tego typu regulacje są już w tej chwili opracowywane na poziomie Unii Europejskiej. Prawo oczywiście nie może i nie powinno powstrzymać rozwoju technologii. Konieczne jest jednak zapewnienie pełnej transparentności jej wykorzystania.

Odrębnym zagadnieniem jest ograniczenie możliwości profilowania ludzi. Profilowanie ma bardzo dużo wspólnego z inwigilowaniem. Oczywiście, zjawisko inwigilowania znane jest od wieków, jednak dopiero dzisiaj dostępne technologie umożliwiają prowadzenie takich działań na masową skalę w zakresie, który może mieć wpływ na wynik wyborów. Spodziewam się, że te wszystkie kwestie zostaną uregulowane prawnie w najbliższej przyszłości. Problemem stanie się natomiast wymuszanie przestrzegania prawa obejmującego stosowanie AI. Już dzisiaj widać, że odróżnienie działań legalnych od zabronionych, może być często bardzo trudne.

Podsumowując, można powiedzieć, że przyszłe wybory to będzie wyścig zbrojeń. Wyścig, w którym po jednej stronie staną prawodawcy usiłujący nadążyć z tworzeniem prawa za tworzącą coraz to nowe możliwości technologią oraz służby państwowe próbujące wymusić przestrzeganie tego prawa, a z drugiej wszyscy ci, którzy będą chcieli wykorzystać możliwości, jakie daje technologia dla własnej korzyści niekoniecznie w granicach naznaczonych przez prawo. Niestety, spodziewam się, że wyścig ten będzie bardzo trudny i niezrozumiały dla przeciętnego obywatela. Jeśli bowiem rozwój technologiczny ma nie zostać zatrzymany (a to jest niemożliwe), to odróżnienie działań legalnych od zabronionych, będzie wymagało wiedzy eksperckiej obejmującej zupełnie nowe obszary.

Jest się czego obawiać?

KW: Które z potencjalnych zagrożeń związanych z wykorzystaniem AI w polityce postrzegacie jako największe i najbardziej realne?

Tak jak w przypadku każdego nowego narzędzia, w pierwszej kolejności uwydatniane są zagrożenia. My, ludzie, lubimy dowiadywać się o niebezpieczeństwach. W 1865 roku wprowadzono w Wielkiej Brytanii prawo zakazujące ówczesnym samochodom przekraczania prędkości 6 km/h i wymagające, aby przed każdym z nich biegł człowiek z czerwoną flagą ostrzegający o niebezpieczeństwie. Czy samochody są niebezpieczne? Oczywiście, że są. Dziś w wypadkach drogowych w Wielkiej Brytanii z pewnością ginie więcej osób niż w 1865 roku. Jednak nadmierna koncentracja na zagrożeniach jest cechą charakterystyczną wieku niemowlęcego każdego przełomowego wynalazku.

No i sztuczna inteligencja też niesie zagrożenia, w tym […] ogromne możliwości manipulacji. My, jako ludzie, niejako z natury lubimy łączyć się w stada. Lubimy czuć, że wokół nas jest wielu, którzy myślą i czują podobnie. Potrzebujemy też wspólnego wroga. To nas napędza do działania. Stado daje poczucie bezpieczeństwa i siły. Sztuczna inteligencja zwielokrotnia możliwości wykorzystywania tej naturalnej potrzeby do manipulacji. Nieuczciwi politycy mogą budować całe społeczności fałszywych, sztucznych zwolenników po to, aby przyłączali się do nich żywi ludzie – wyborcy. Skutkiem ubocznym tego zjawiska będzie, niestety, jeszcze większe pogłębienie się podziałów w społeczeństwie, tworzenie się zamkniętych we własnym widzeniu świata i nienawidzących się wzajemnie plemion.

Drugim ważnym zagrożeniem jest powszechna inwigilacja. Już dzisiaj technologia zbierania danych […] jest tania i powszechnie dostępna. Dotychczas jednak na przeszkodzie masowej inwigilacji stały technologie przetwarzania danych. […] Pojawienie się AI radykalnie zmienia tę sytuację. Dzięki technologiom sztucznej inteligencji można precyzyjnie rozpoznać każdą osobę sfilmowaną przez którąkolwiek z tysięcy ustawionych kamer. Podobnie łatwo można rozpoznawać głos, a nawet analizować emocje. Trudno przewidzieć dzisiaj wszystkie konsekwencje tego zjawiska. Patrząc na technologie wprowadzone już obecnie w Chinach, można odczuwać obawę.

Rozważając ryzyka związane z technologią sztucznej inteligencji, nie sposób nie zwrócić uwagi na fakt, że jest to dziedzina wiedzy, w której ogromną przewagę mają wielkie korporacje. Dzieje się tak z dwóch powodów. Po pierwsze, trenowanie najefektywniejszych modeli wymaga ogromnych i drogich zasobów sprzętowych, które to zasoby wymagają z kolei dużych ilości energii elektrycznej. […] Otóż tego rodzaju zasoby są w posiadaniu tych korporacji, które są właścicielami ogólnoświatowych mediów społecznościowych, powszechnie używanych komunikatorów, serwisów medialnych i innych podobnych zasobów. To daje korporacjom ogromną przewagę. Przewagę, która może zostać wykorzystana dla większej kontroli nad społeczeństwem. Co więcej, jest to strefa niezwykle trudna do uregulowania. Nie jest bowiem łatwo stwierdzić, jakie dane były wykorzystywane do wytrenowania używanego modelu.

Podsumowując jednak, chciałbym powrócić do brytyjskiego prawa z 1865 roku. Samochód miał wówczas zakaz poruszania się z prędkością przekraczającą 6 km/h. Dla porównania dyliżans konny bez trudu mógł w tych czasach rozwinąć prędkość 15 km/h. To pokazuje jak bardzo nasi przodkowie obawiali się nowego środka transportu. Czy ich obawy nie były słuszne? Oczywiście, że były słuszne. W 1926 roku w wielkiej Brytanii wskutek wypadków samochodowych zmarło 4886 osób […] w roku 2022 było to już zaledwie 1695 osób i to pomimo upowszechnienia się samochodów na przestrzeni 100 lat oraz drastycznego zwiększenia się ich prędkości. Trudno dzisiaj wyrokować, jak poradzimy sobie z zagrożeniami pojawiającymi się w związku z rozwojem się sztucznej inteligencji. Jestem jednak przekonany, że ludzkość i tym razem sobie poradzi. A korzyści wynikające z możliwości użycia AI są trudne do wyobrażenia.

Wykorzystanie LLM w kampaniach kontra etyka

KW: Jak wyglądają kwestie etyczne dotyczące używania AI w kampaniach wyborczych?

Poza jakąkolwiek etyczną dyskusją pozostaje intencjonalne użycie sztucznej inteligencji w celu wprowadzenia ludzi w błąd. Takie działanie musi być etycznie zakwalifikowane podobnie jak każde inne oszustwo. Ciekawszym zagadnieniem jest tzw. halucynowanie rozwiązań opartych o LLM. Na obecnym etapie jest ono mankamentem, którego nie udaje się w pełni wyeliminować. Wynika ono ze statystycznego charakteru modeli przeznaczonych do generowania tekstów. Modele te, co do zasady, nie są wyposażone w żaden mechanizm logicznego wnioskowania, a jedynie, w oparciu o zgromadzoną (wyuczoną) wiedzę, starają się podać taką odpowiedź, która jest statystycznie najbardziej prawdopodobna.

Równocześnie, są one zdolne do pewnego uogólniania wiedzy tak, aby pewne wzorce rozumowania z jednej dziedziny przenieść do innej. Jeśli zatem zadamy pytanie o zagadnienia, które były tylko w niewielkim stopniu poruszane w zbiorach uczących, model zacznie poszukiwać odpowiedzi wykorzystując wzorce, które mogą być nieadekwatne do sytuacji. Aby lepiej zrozumieć to zjawisko, poproście ChatGPT o proste przemnożenie dwóch liczb 4-cyfrowych przez siebie. W większości wypadków dostaniecie błędną odpowiedź. Dlaczego tak się dzieje? Dlatego że istnieje ogromna liczba możliwych kombinacji mnożenia dwóch liczb 4-cyfrowych przez siebie. Tak dokładnie, to istnieje 50 mln takich kombinacji.

W chwili obecnej właśnie zjawisko halucynowania jest największym hamulcem ograniczającym możliwości wykorzystania dużych modeli językowych (LLM). Istnieją, oczywiście, sposoby ograniczenia tego zjawiska, jednak na jego całkowitą eliminację musimy jeszcze poczekać. Niestety, tym, którzy chcą wykorzystać LLMy w złej intencji, halucynowanie mniej przeszkadza, a w pewnych sytuacjach może być zjawiskiem przez nich pożądanym – stanowiącym wsparcie dla polityków, którzy też niejednokrotnie mijają się z prawdą.

Oddzielnym zagadnieniem etyczno-prawnym, związanym z wykorzystaniem sztucznej inteligencji, jest kwestia praw do zbiorów danych uczących. Współczesne modele generatywne trenowane są na ogromnych zbiorach danych. W większości są to dane pochodzące z Internetu. Jednak, w zależności od intencji twórców, mogą być wykorzystywane różne zbiory. Można sobie wyobrazić stworzenie modelu, który dość skutecznie imituje styl wypowiedzi konkretnego polityka, generując jednocześnie treści całkowicie sprzeczne z tym, co ów polityk głosi. Tak się stanie, jeśli model został specjalnie dotrenowany na zbiorze wypowiedzi politycznego adwersarza twórców modelu. Niestety, nie mając informacji o tym, w jaki sposób dany model został wytworzony, niezwykle trudno jest udowodnić, jakich konkretnie danych uczących użyto.

AI w polityce pod kątem prawnym

KW: Jak prawo w Polsce lub na świecie interpretuje tego typu działania? Istnieją jakieś regulacje w odniesieniu do wykorzystania AI w polityce?

Modele generatywne wciąż jeszcze są absolutną nowością. Mamy do czynienia ze zjawiskiem, które pojawiło się w powszechnej świadomości dopiero pod koniec ubiegłego roku. Zrozumienie zjawiska i konsekwencji jego pojawienia się w sposób dostateczny, aby stworzyć sensowne prawo, wymaga czasu. Jest niezwykle ważne, aby zabezpieczyć interes społeczeństw i jednostek, ale jednocześnie nie zablokować postępu ani nie odesłać badań nad sztuczną inteligencją.

Obecnie prowadzone są prace na poziomie Unii Europejskiej mające na celu prawne uregulowanie tych zagadnień. Prawodawcy próbują sklasyfikować systemy sztucznej pod względem ryzyka, jakie generują. Propozycje idą w kierunku zakazania systemów, które manipulują ludźmi ze szczególnym uwzględnieniem manipulacji prowadzonej w stosunku do osób należących do grup szczególnie nieodpornych — w tym dzieci. Zabronione będzie też prowadzenie tzw. scoringu, czyli klasyfikacji ludzi na podstawie ich zachowań, statusu społeczno-ekonomicznego lub cech osobistych. Niedopuszczalna (poza wyjątkami) będzie identyfikacja biometryczna działająca w czasie rzeczywistym i zdalnie.

Kontrola podstawą zaufania

KW: Jakie są metody wykrywania i kontrolowania wpływu AI na procesy wyborcze?

Odrębne regulacje będą wprowadzone w obszarze systemów generatywnych. Po pierwsze, obowiązkowe będzie ujawnienie, że treść została wygenerowana przez sztuczną inteligencję. Po drugie, na twórcach będzie spoczywał obowiązek zaprojektowanie modelu tak, aby nie generował on nielegalnych treści. Po trzecie, wymagane będzie publikowanie streszczeń chronionych prawem autorskim danych wykorzystywanych do treningu.

Jest niemal pewne, że regulacje dotyczące sztucznej inteligencji, będą wielokrotnie zmieniane tak, jak na przestrzeni ostatnich 100 lat wielokrotnie zmieniały się regulacje dotyczące motoryzacji. Kluczowe jest, aby równolegle z rozwojem AI wypracować mechanizmy, które pozwolą zachować kontrolę nad tymi narzędziami tak, aby nie stanowiły one zagrożenia dla świata wartości, w którym żyjemy. I głęboko wierzę, że takie mechanizmy będą wypracowane a wszelkie nadużycia, w tym nadużycia polityczne i wyborcze, zostaną poddane kontroli. To nic, że dzisiaj nie wiadomo jeszcze, jak mechanizmy kontrolne budować. Wszak 100 lat temu nikt nie umiał wyobrazić sobie funkcjonowania poduszek powietrznych, stref kontrolowanego zgniotu, ABS i wielu, wielu innych rozwiązań zapewniających nam dzisiaj na co dzień bezpieczeństwo.

Zdjęcie główne: Piotr Cierkosz/ Unsplash + Steve Johnson/Unsplash