Słyszysz o niej każdego dnia od dobrych kilku, jeśli nie kilkunastu lat. I słyszeć będziesz nadal, bo chmura jest kluczem do rozwoju wszystkich najistotniejszych technologii. W tym także sztucznej inteligencji.

Chmura w AI i nie tylko – spis treści

Autorzy tekstu: Jan Czarnocki, dr Jan Kwapisz (Dijkstra Enterprise)

Czym jest i dlaczego powstała chmura?

Czy zastanawiałeś/aś się kiedyś, ilu komputerów potrzeba do utrzymania tego portalu? Lub ile komputerów było potrzebnych do wytrenowania GPT-3 oraz GPT-4 i ile to kosztowało?

Jak tłumaczyliśmy w artykule o modelu GPT i roli nauczania maszynowego, moc obliczeniowa to jeden z podstawowych elementów rozwoju sztucznej inteligencji. Kolejnymi elementami są architektura i dane. To właśnie dzięki chmurze możliwe jest „szkolenie” modeli takich jak GPT-3 i GPT-4 czy narzędzi pokroju Bard oraz Midjourney.

Chmura (po angielsku cloud) lub technologie chmurowe, to słowo, które opisuje ogromną moc obliczeniową, która jest generowana poprzez połączenie ze sobą trudno wyobrażalnej wręcz liczby komputerów. Chmura to dosłownie setki i tysiące połączonych ze sobą komputerów znajdujących się np. na Alasce, czy w innym chłodnym miejscu i z tanią energią, które wspólnie dostarczają moc obliczeniową do wynajęcia. Z punktu widzenia użytkownika końcowego, korzystanie z chmury oznacza, że dane mogą być przechowywane i udostępniane z dowolnego miejsca na świecie, o każdej porze dnia i nocy.

Przykładowo, OpenAI do wytrenowania modeli GPT użyło tzw. Klastra Kubernetes łączącego ze sobą 7500 komputerów (node’ów), każdy wart około 2 milionów złotych (przy założeniu, że każdy z takich komputerów to maszyna z 8 kartami graficznymi V100 razem z Nvlink, co jest standardowym rozwiązaniem stosowanym w Deep Learningu). Dzięki tej technologii te 7500 komputerów mogło się ze sobą komunikować. Koszt kupienia takiego sprzętu to w przybliżeniu aż 15 miliardów złotych. Natomiast dzięki możliwości wynajęcia takiej mocy obliczeniowej trening GPT-3 kosztował „tylko” 25 milionów złotych, czyli prawie tysiąc razy mniej. Z drugiej strony trening na pojedynczej takiej karcie zająłby 335 lat, przy założeniu, że miałaby ona dostęp do prądu. Ewidentnie widać, co jest bardziej opłacalne i bardziej wydajne.

Inną zaletą technologii chmurowej jest możliwość skalowania zasobów w zależności od potrzeb. W przypadku wzrostu liczby użytkowników lub ilości danych, w chmurze można łatwo i szybko dostosować pojemność dysków, moc obliczeniową czy liczbę użytkowników. Ponadto rozwiązania chmurowe są „ustandaryzowane”, co pozwala na prostsze i szybsze tworzenie rozwiązań. Ponadto chmura to miejsce, gdzie przechowuje się większość danych w internecie, które odpowiednio zanonimizowane mogą być użyte do trenowania modeli sztucznej inteligencji.

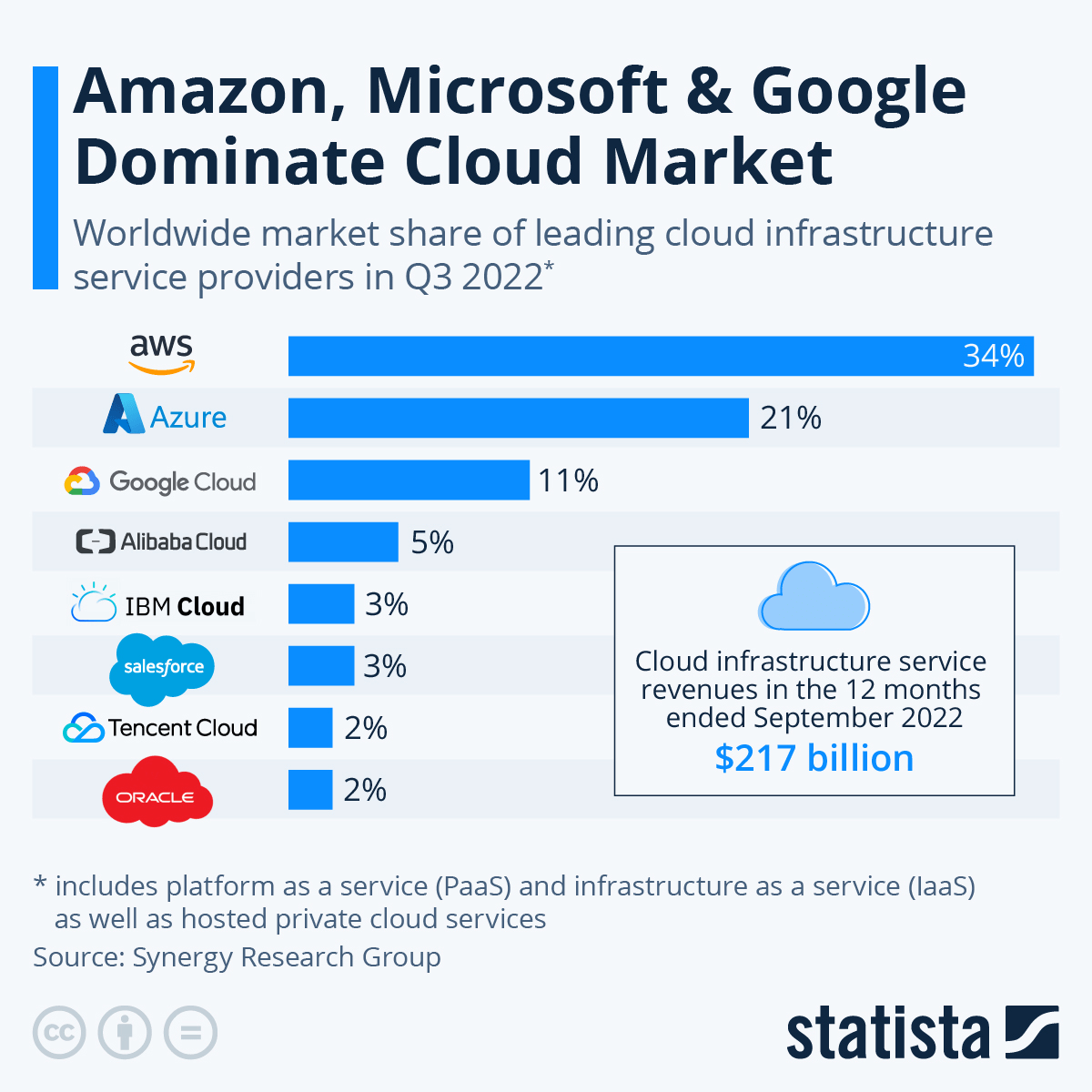

Sukces chmury polega na tym, że dla większości ludzi i firm znacznie tańszym jest wynajęcie na parę godzin określonej mocy obliczeniowej, niż samodzielne stawianie serwera. Dlatego też zbudowanie dobrej chmury jest tak drogie i w ten biznes wchodzą zazwyczaj tylko najwięksi gracze. Struktura rynku chmurowego odzwierciedla tę prawidłowość. 90% usług chmurowych kontrolują Amazon z technologią AWS, Microsoft ze swoim Azure i Google Cloud.

Notabene Amazon na rozwiązaniach chmurowych zarabia około dwukrotnie więcej niż na popularnym serwisie streamingowym Amazon Prime. Być może gdyby bardziej się przyłożyli do Pierścieni Władzy, ten wynik byłby inny.

Chmura jako zasób strategiczny

Tak wielka moc obliczeniowa oraz zgromadzenie danych pozwala na tworzenie algorytmów i narzędzi, takich jak ChatGPT czy Midjourney. Jednak to nie jedyne potencjalne zastosowania tak skumulowanej wiedzy.

W ramach zasobów chmurowych przechowywane są rozwiązania różnych problemów programistycznych, w tym tych z zakresu bezpieczeństwa. Dlatego też możliwa jest ich analiza i stworzenie algorytmów łamiących obecnie używane zabezpieczenia. To właśnie jeden z powodów, dla których ci, którzy kontrolują chmurę, mogą potencjalnie mieć takie wpływy.

Po drugie, nietrudno wyobrazić sobie użycie modeli typu GPT-3 bądź GPT-4 jako największej na świecie farmy trolli, która lobbowałaby za określoną sprawą. Między innymi dlatego ten model jest tak uważnie chroniony i autorzy starają się go zabezpieczyć przed cyberatakami. Inaczej, ten kto miałby nieograniczoną niczym swobodę korzystania z ChatGPT, mógłby zalać internet swoją propagandą. Te „zamknięcie OpenAI” ma jednak i drugą stronę medalu.

Podczas bardziej konwencjonalnych wojen, takie algorytmy również odgrywają i będą odgrywać kluczową rolę. Przykładem może być algorytm YOLO (You Only Look Once), obecnie wykorzystywany do wykrywania obiektów na drodze i zaznaczanie ich w ramki. Nietrudno sobie wyobrazić użycie tego algorytmu na polu walki. Przykładowo żołnierze wyposażeni w Head-Up Display (wyświetlacz rozszerzonej rzeczywistości wyświetlający im kluczowe informacje przed oczami) mogliby mieć oznaczane jednostki wroga na takim wyświetlaczu i strzelać do wroga “jak do kaczek”. Także w terenie, w którym widzialność jest mocno ograniczona.

Już dzisiaj sztuczna inteligencja potrafi grać w Dyplomację, grę symulującą politykę na przełomie XIX i XX wieku (Model Cicero), a stąd już niedaleko do “asystenta generała”, który bardzo szybko przeanalizuje sytuacje i dostarczy potrzebne rozwiązania. Takie systemy rozwiją na przykład firmy Palantir czy Anduril. To wszystko w oparciu o rozwiązania chmurowe, które zapewniają możliwość składowania danych i zapewniają wielką moc obliczeniową.

Co ciekawe, wiele mówiło się jeszcze do niedawna o tym jak prężnie Chiny rozwijają swoje technologie informacyjne, w tym chmurę i AI, jednak okazuje się, że AliBaba, jedna z największych chińskich spółek technologicznych i właściciel popularnego w Azji marketplace’u, jest właścicielem zaledwie 5% chmurowego “tortu”.

Chiny do chmur dolecą później

Fakt słabo rozwiniętej chmury, a dodatkowo sankcji na półprzewodniki i karty graficzne (niezbędne do rozwoju sztucznej inteligencji) nałożonych przez USA na Chiny oznacza, że raczej Chiny nie dadzą rady w rywalizacji technologicznej z USA – przynajmniej nie w tym obszarze i nie w najbliższych latach. Obecnie zakazany jest eksport najmocniejszych kart NVIDII A100 do Chin. Na polu technologicznym w architekturze do uczenia głębokiego Nvidia, notabene założona przez pochodzącego z Tajwanu Jensena Huanga, jest w zasadzie monopolistą, ich największy konkurent AMD nadal boryka się z rozwojem oprogramowania do Deep Learningu. Chiny nie mają u siebie w zasadzie żadnego producenta zaawansowanych kart graficznych, koniecznych do rozwoju AI. Z drugiej strony NVIDIA już wykorzystuje sztuczną inteligencję do rozwoju własnych chipów. Zatem te dwie dziedziny sztuczna inteligencja oraz rozwój kart graficznych wzajemnie się napędzają. Do tego wszystkiego niezbędnym elementem jest oczywiście wielka chmura obliczeniowa.

Mimo że działanie chmury można dość prosto wytłumaczyć, jako funkcjonowanie połączonych komputerów, które wynajmujemy, żeby nam coś policzyły, to jednak sama obsługa chmury i zrozumienie technicznych aspektów jej funkcjonowania to już wyższa szkoła jazdy. Obsługa techniczna chmury wymaga specjalistycznej wiedzy z wielu zakresów takich jak usługi sieciowe, konfiguracja oprogramowania czy dostępnych rozwiązań i głębokiego zrozumienia ich wad i zalet. Na rynku jest stosunkowo mało specjalistów potrafiących dobrze operować chmurą, dlatego ich zarobki są często powyżej 20 tysięcy złotych netto, a nierzadko sięgają nawet 50 tysięcy netto na umowie B2B, o czym można się przekonać, przeglądając aktualne ogłoszenia.

opracowanie: Dijkstra Enterprise, fot. Depositphotos/Gorodenkoff