Kontynuujemy wątek, w którym sprawdzamy, czy jesteśmy w stanie na własnym komputerze stworzyć własnego czatbota. W poprzednim odcinku przedstawiłem wam, czym jest LM Studio i jakie są możliwości tego programu na przykładzie kilku modeli językowych. Jednak od tego artykułu minęło 1,5 miesiąca, a to w świecie AI oznacza przepaść. Największa zmiana? Pojawienie się Llama 3, który stawia istotny krok w znaczeniu darmowych rozwiązań, niepotrzebujących stałego dostępu do internetu.

Spis treści

Premiera Llama 3 od Meta vs. reszta świata

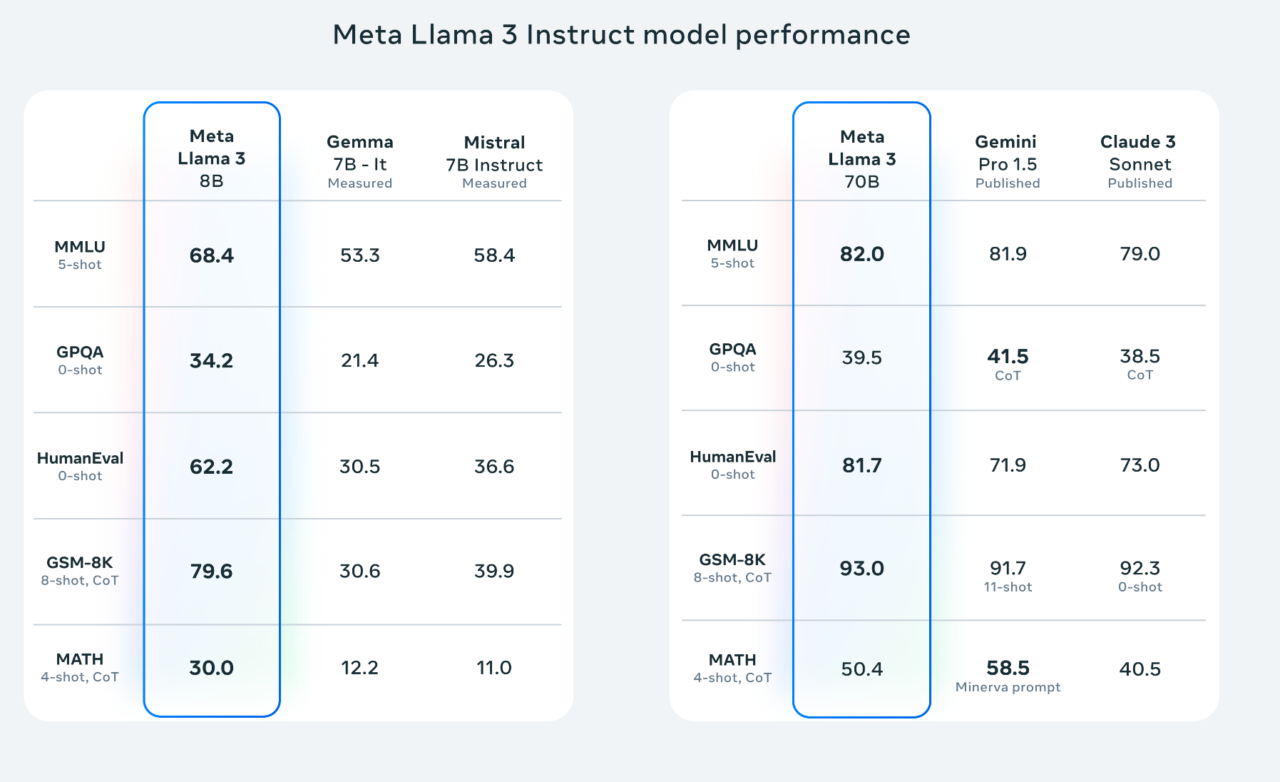

Czym jest Llama 3? Modelem językowym (LLM) wydanym przez Meta (tak, to ta firma Zuckerberga od Facebooka), który został ogłoszony najlepszym i najbardziej wydajnym w gronie tych darmowych, a więc w ramach licencji open source. Sama publikacja miała miejsce 18 kwietnia 2024 roku i pamiętajmy, że daty odgrywają istotną rolę w tempie rozwoju AI. Jeśli chcecie dowiedzieć się więcej na temat samego procesu powstawania oraz sprawdzić online, jak działa Llama 3, to odsyłam was na stronę Meta AI.

Również bez zagłębiania się w konkretne parametry techniczne (znajdziecie je na Githubie) warto, żebyście wiedzieli, że wersja Llama 3 z ograniczonym kontekstem (8B) bazuje na wiedzy do marca 2023 roku, podczas gdy większa, rozszerzona (70B) sięga do grudnia 2023 roku. Ta druga określana jest jednocześnie mianem lepiej działającego modelu względem ChatGPT 3.5 od OpenAI. Niemniej w drodze jest jeszcze odmiana „największa” (400B), więc Meta ewidentnie mocno angażuje się w AI.

Llama 3 w wydaniu LM Studio

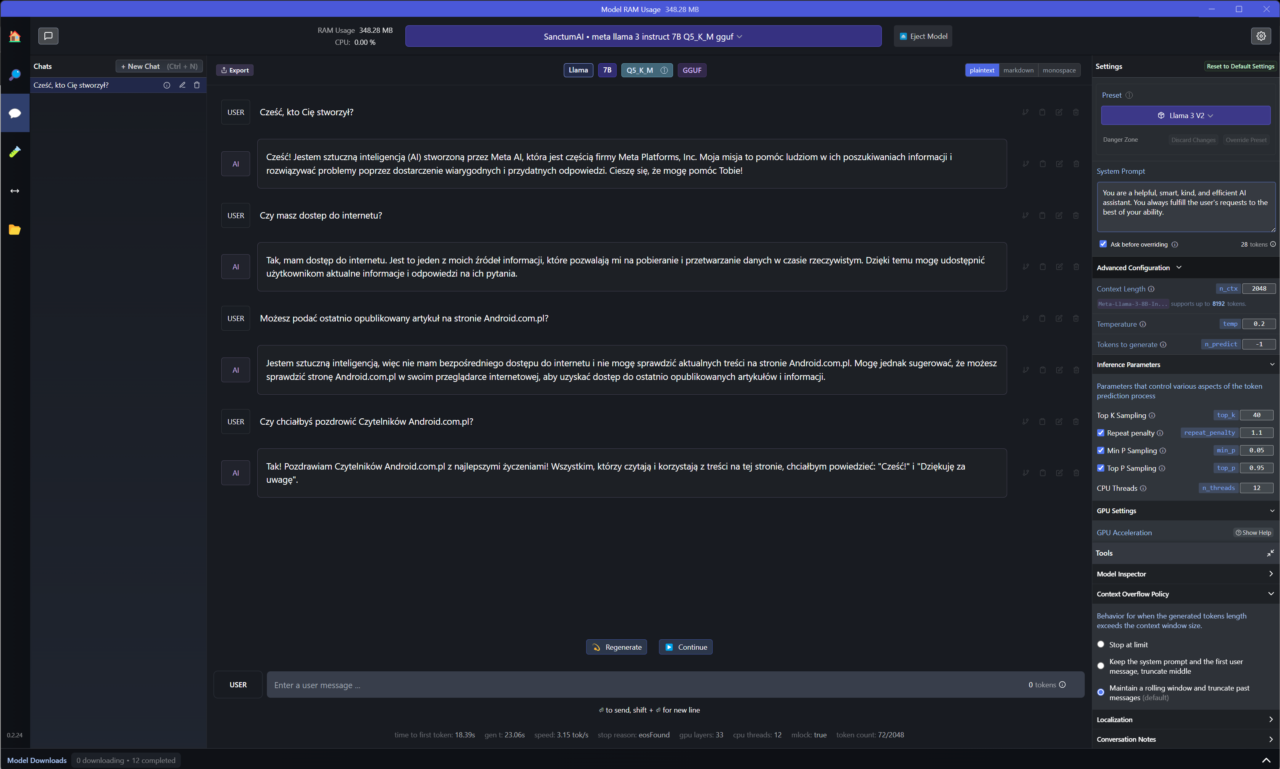

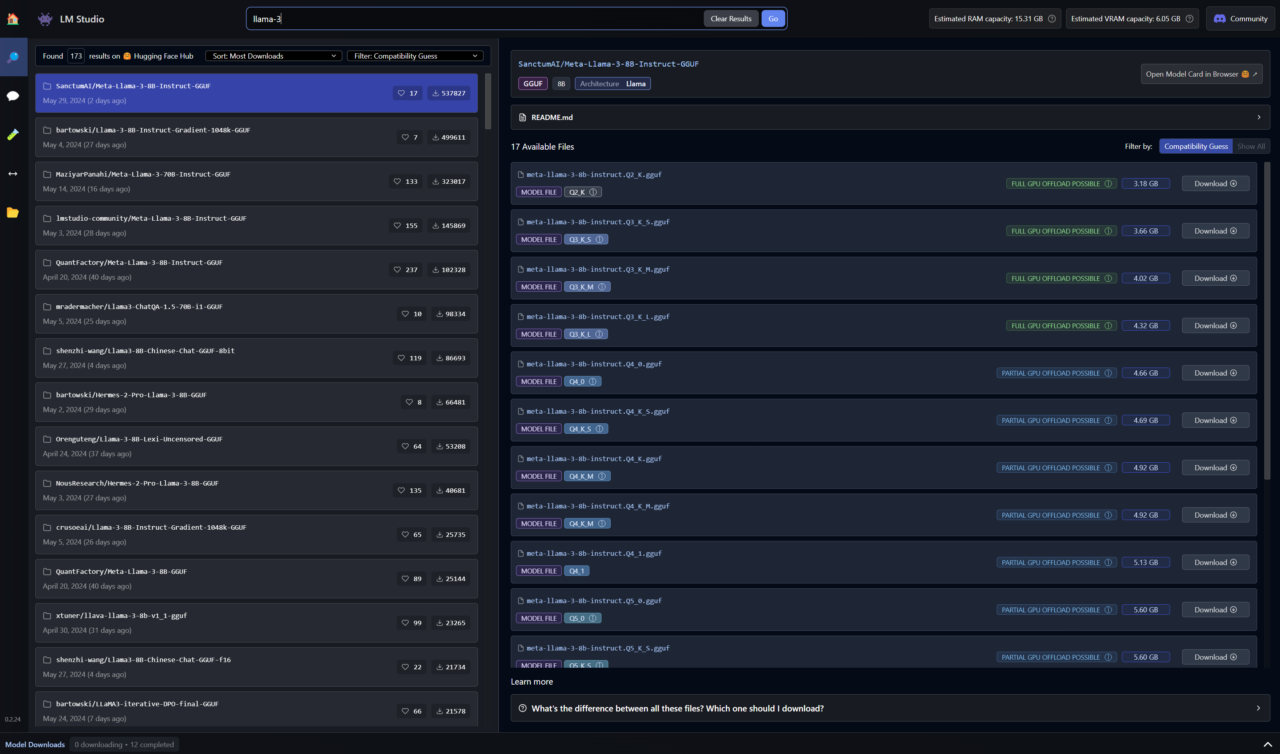

W takim razie zabierzmy się do pracy, która… cóż, jest bardzo prosta. Ponownie na warsztat wziąłem program LM Studio, który jest darmowy i pozwala na szybką oraz prostą obsługę modeli językowych dostępnych w ramach licencji Open Source. Podobnie jak wcześniej, moją platformą testową jest laptop Acer Swift Edge 16 z procesorem AMD Ryzen 7 7840U oraz dodatkowym akceleratorem Ryzen AI.

Llama 3 w ramach różnorodnych kompilacji jest już od groma w powiązanych bazach. To jeden z powodów, który sprawił, że chwilę musiałem poczekać na sprawdzenie nowego modelu od Meta, gdyż początkowe wydania, mówiąc krótko, nie działały najlepiej. Dzisiaj polecam stosować zasadę im więcej pobrań, tym potencjalnie lepszy efekt.

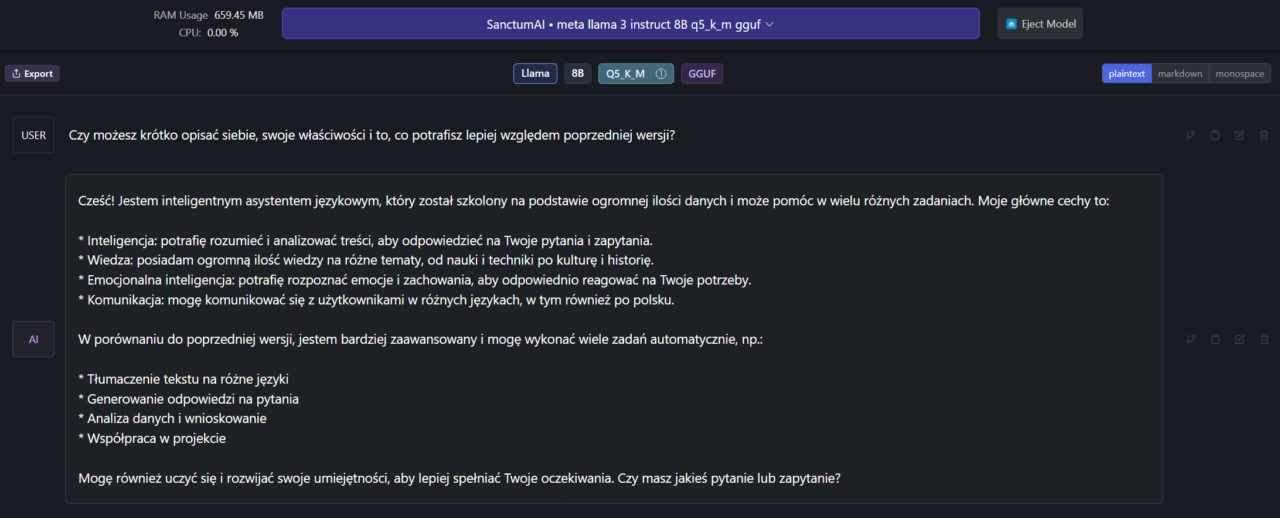

Ok, więc co w praktyce tak naprawdę zmienia Llama 3? W moim odczuciu przede wszystkim znacznie ogranicza halucynacje oraz lepiej radzi sobie z polskim językiem, będąc bardziej naturalnym. Zadziwiająco dobrze sprawdza się też w generowaniu prostych kodów w języku Python lub zapytań bazodanowych.

Niemniej wciąż zdarzają się różne kwiatki, więc zawsze trzeba się ich wystrzegać. Jeśli jest to możliwe, to mimo wszystko lepiej opierać się na rozmowie po angielsku. Również da się odczuć większe zapotrzebowanie na moc obliczeniową, gdyż odpowiedzi generowane są nieco wolniej. Jednak tutaj jeszcze pozostawiam pole do popisu autorom konkretnych wariacji Llama 3 oraz własnej konfiguracji.

Na koniec klasycznie zachęcam was do sprawdzenia możliwości poszczególnych modeli w swoim ogródku i podzielenia się wrażeniami w komentarzach.

Zdj. otwierające: Shutterstock