Nie od dziś wiemy, że możliwości narzędzi do tworzenia obrazów potrafią nas zaskoczyć. Ale to, jakie materiały filmowe opublikowało OpenAI i Sora, przechodzi nasze wyobrażenia. Generator wideo na podstawie tekstu oparty na sztucznej inteligencji rodzi pytania dotyczące przyszłości przemysłu filmowego, grafiki komputerowej i wielu innych branż. O to redakcja Android.com.pl zapytała eksperta z dziedziny AI.

OpenAI Sora nowe materiały – Spis treści

Rewolucyjne narzędzie od OpenAI – poznajcie Sora

Sora to nowy model generowania wideo od OpenAI, który umożliwia tworzenie filmów o długości do 60 sekund na podstawie tekstowych poleceń użytkownika. Jest to model bazujący na sztucznej inteligencji, który potrafi generować skomplikowane sceny z wieloma postaciami, szczegółowymi ruchami i precyzyjnymi detalami przedmiotów oraz tła, rozumiejąc nie tylko zadane polecenie, ale również sposób, w jaki przedstawione obiekty istnieją w rzeczywistym świecie.

Sora na ten moment ma jednak pewne ograniczenia, na co zwrócił uwagę Wojciech Niekrasz, IT Manager Future Collars w rozmowie z Android.com.pl.

Największe wyzwania techniczne obejmują skalowanie modeli, kompresję danych wizualnych i utrzymanie spójności w długich sekwencjach wideo. Na ten moment Sora jest w stanie wygenerować wideo o maksymalnej długości 1 minuty oraz maksymalnej rozdzielczości 1080p. Tak jak inne modele transformer (np. GPT), dużą limitacją jest tzw. context window, czyli jak dużo danych model jest w stanie przetworzyć i wygenerować, bez utraty jakości generowanych treści.

Wojciech Niekrasz, IT Manager Future Collars, dla redakcji Android.com.pl

Jak to działa? Narzędzie wykorzystuje model dyfuzji (podobny do innych narzędzi AI generujących obrazy) z systemem kodowania transformatora przypominającym ChatGPT. Model ten został wytrenowany do usuwania szumów wizualnych z klipów wideo, co pozwala na tworzenie klatek z tekstowych poleceń. Główna różnica między Sorą a generatorami obrazów polega na tym, że zamiast kodować tekst w statyczne piksele, przekłada słowa na bloki czasowo-przestrzenne, które razem tworzą kompletny klip.

Najnowsze materiały wideo – słoń z liści i kot na odkurzaczu

Chociaż Sora nie jest jeszcze dostępna publicznie, firma z przyjemnością udostępnia filmy generowane przez narzędzie i publikuje je na swoich kanałach w mediach społecznościowych. Ostatnia pula materiałów jest zachwycająca pod względem jakości obrazu. Zaskakuje przede wszystkim zdolność do uchwycenia szczegółów w makro skali.

W tym tygodniu pokazano m.in. film przedstawiający zielonego, pokrytego liśćmi słonia z okazji irlandzkiego Dnia Świętego Patryka (ang. St. Patrick’s Day), tęczowy wodospad i walc trzmiela. W przypadku tego pierwszego materiału podpowiedź tekstowa brzmiała: „Słoń z liści biegający po dżungli” (ang. An elephant made of leaves running in the jungle). Efekt możecie zobaczyć poniżej.

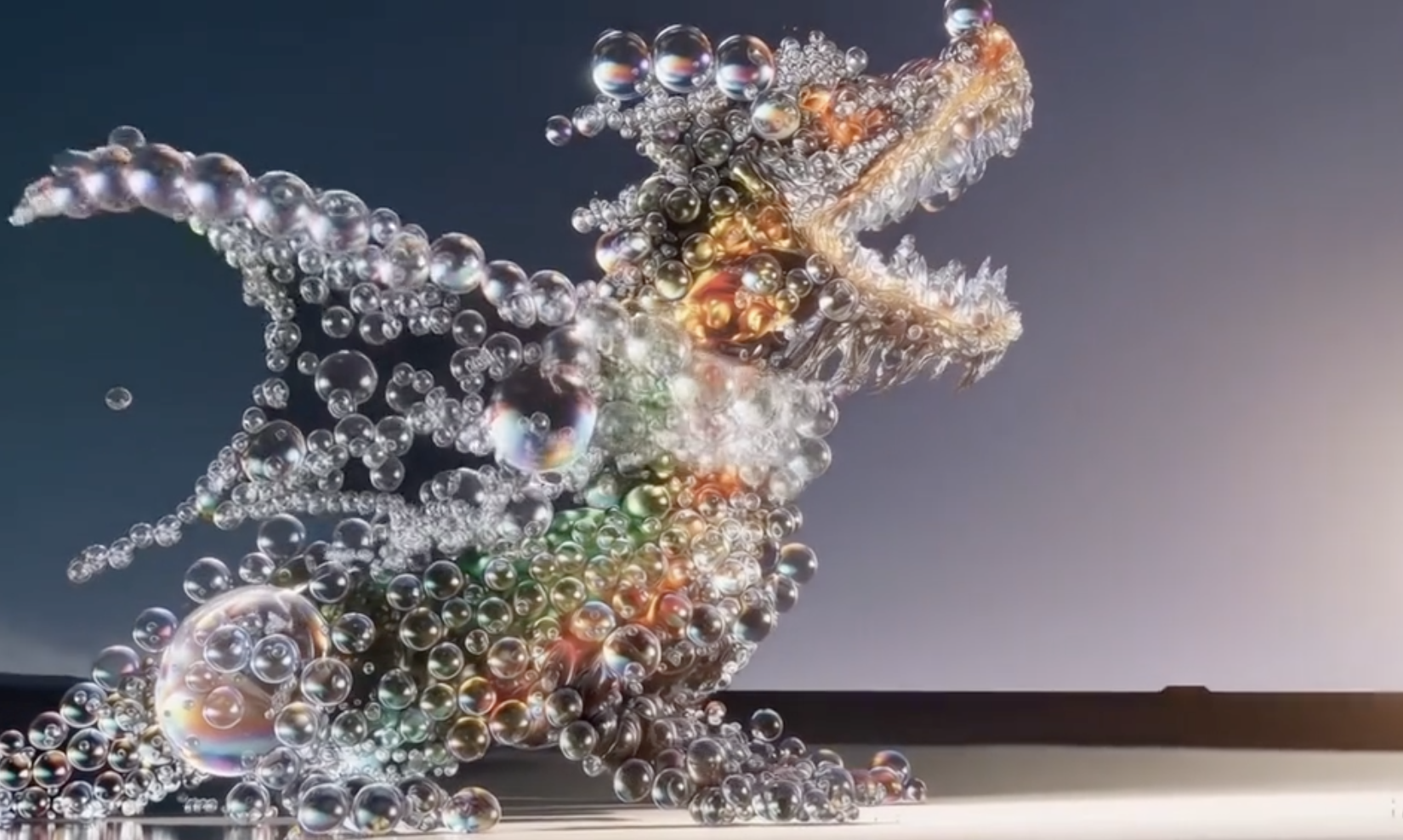

Poniżej przykład efektu wpisania treści polecenia: „Smok z baniek/bąbelków, doskonale renderowany w rozdzielczości 8K” (ang. A dragon made of bubbles, perfectly rendered 8K).

Na Instagramie OpenAI pojawił się także materiał z kotem siedzącym na robocie odkurzającym. Pewnie wielu z was przyznałoby, że film jest zabawnym nagraniem małego kociaka z internetu. Nic bardziej mylnego – to wygenerowane sztucznie wideo z podpowiedzi tekstowej „Uroczy kociak-pirat jeżdżący po domu robotem odkurzającym” (ang. An adorable kitten pirate riding a robot vacuum around the house).

Podczas analizowania wideo w mediach społecznościowych OpenAI warto zwrócić uwagę na bardzo dobrze zaprojektowany ruch poszczególnych elementów. Czasem potrzeba popatrzeć kilka razy, zanim zorientujemy się, że film nie został zarejestrowany kamerą. A czasem, cóż – w ogóle tego nie zauważymy.

Co tak naprawdę oznacza dla nas rozwój narzędzi takich jak Sora?

Sora nie jest jeszcze dostępna publicznie, choć mówi się, że jeszcze w tym roku możemy doczekać się jej premiery. Narzędzie to było już testowane przez małą grupę ekspertów, w tym twórców wideo i artystów, w celu uzyskania informacji zwrotnych na temat jego użyteczności w dziedzinach kreatywnych. Możemy więc niedługo spodziewać się zupełnej rewolucji w edycji wideo.

Sora ma potencjał na zrewolucjonizowanie tworzenia i edycji wideo. Aplikacje wykorzystujące GenAI już teraz zmieniają to, w jaki sposób pracujemy. Większość programistów już korzysta z AI w codziennej pracy – narzędzia takie jak Github Copilot kilkukrotnie zwiększają ilość pisanego kodu.

Wojciech Niekrasz, IT Manager Future Collars, dla redakcji Android.com.pl

Jednak rozwój takich narzędzi może przyspieszyć pojawienie się potencjalnych nadużyć, takich jak generowanie fałszywych treści wideo, co podnosi obawy związane z rozprzestrzenianiem się dezinformacji i nieprawdziwych informacji w internecie. W tym miejscu dobrze przypomnieć wiralową reklamę Telekom dotyczącą deepfake’u.

Już teraz mamy ogromny problem z deepfake’ami (narzędzia GenAI do generowania głosu są na naprawdę wysokim poziomie). Udostępnienie tak zaawansowanego modelu jak Sora może tylko pogorszyć i tak już skomplikowaną sytuację. Niedostosowanie się społeczeństwa do zmian na rynku pracy – wiele zawodów może zniknąć, ale też wiele nowych może się pojawić. Nagłe zmiany mogą doprowadzić do fali bezrobocia i destabilizacji ekonomicznej.

Wojciech Niekrasz, IT Manager Future Collars, dla redakcji Android.com.pl

Z wypiekami na twarzy obserwujemy rozwój narzędzi AI i wyścig start-upów, które pierwsze stworzą z tak potężnych funkcji dochodowe produkty. Choć być może kiedyś treści wideo będzie generował nam asystent głosowy, taki jak Siri po polsku? Warto jednak pamiętać, że pomimo swoich imponujących możliwości, istnieje wiele niewyjaśnionych kwestii dotyczących Sory. Portal Tom’s Guide zwraca uwagę na to, że nadal OpenAI nie udostępniło informacji na temat źródeł, na podstawie których szkolony jest model.

Źródło: Tom’s Guide, oprac. własne. Zdjęcie otwierające: OpenAI @openai / TikTok

Część odnośników to linki afiliacyjne lub linki do ofert naszych partnerów. Po kliknięciu możesz zapoznać się z ceną i dostępnością wybranego przez nas produktu – nie ponosisz żadnych kosztów, a jednocześnie wspierasz niezależność zespołu redakcyjnego.