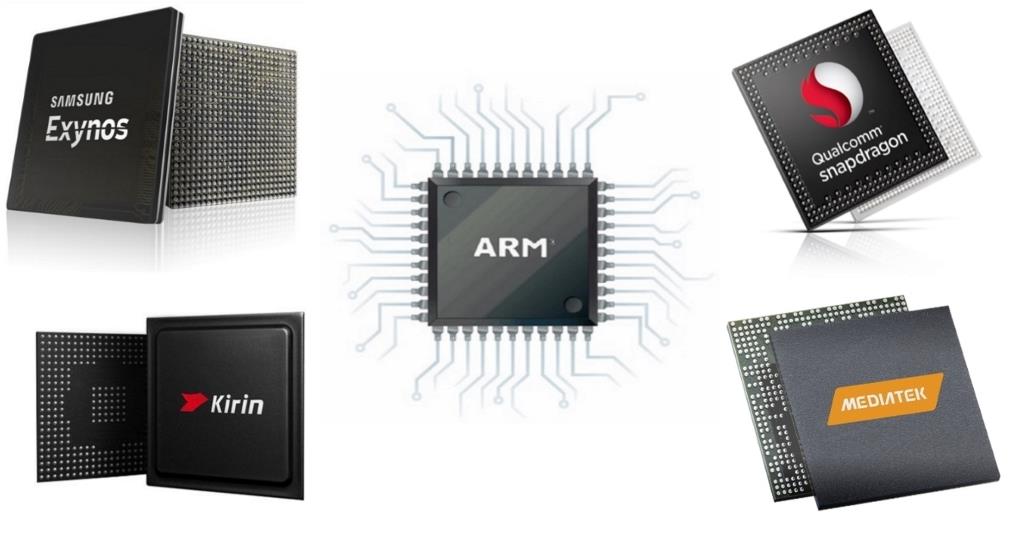

Jeśli myślimy o dobrych układach to decydujemy się na taki, który napędzany jest mocą obliczeniową układu od Qualcomma. Wyjątkami są Exynosy od Samsunga lub Kiriny od Huawei. Mimo wszystko to Snapdragony znajdziemy u niemalże każdego producent. MediaTek coraz bardziej traci na znaczeniu. Problemem Tajwańczyków nie jest brak udostępnianych źródeł. Dużo częściej to kiepska wydajność i wysokie temperatury zniechęcają do zakupu urządzenia z układami Helio.

Qualcommowi również zdarzyło się zaliczyć kilka wpadek. Niewątpliwie najpoważniejszą był Snapdragon 810, który okazał się nieudaną próbą Amerykanów na wejście w świat flagowych 8 rdzeni. Problemem były wysokie temperatury i każdy z producentów musiał na swój sposób radzić sobie z odprowadzaniem ciepła. Snapdragony 820, 821 i 835 były już w pełni poprawnymi układami – bez wad ukrytych. Miejmy nadzieję, że nadchodzący układ z najwyższej półki – oznaczony numerem 845 – też będzie bezproblemowy. W Sieci pojawiła się specyfikacja tej jednostki. Niestety, okazuje się, że Qualcomm może zostać w tyle. Snapdragon 845 ma prezentować się następująco:

- 4 rdzenie Cortex-A75 + 4 rdzenie Cortex-A53

- GPU: Adreno 630 – wsparcie dla wyższych rozdzielczości wyświetlaczy o proporcjach 18:9

- modem X20 – LTE i WiFi do 1,2 Gb/s

- wsparcie dla podwójnych aparatów do 25 MPx – z przodu i z tyłu

- proces technologiczny: 10 nm FinFET LPE

Wszystko wygląda naprawdę interesująco, prawda? O wsparciu dla sieci 5G zapomnijmy – na nie przyjdzie jeszcze czas. Problemem w walce o fotel lidera może okazać się zastosowany proces technologiczny. Samsung, Huawei, a nawet MediaTek zapowiadają układy wykonane w 7 nm. Do tego dochodzi nowa generacja LPP, która powinna pojawić się w Exynosie 9810 (Galaxy S9). W stosunku do LPE, możemy mówić o wyższej wydajności (o 10%) i niższym poborze energii (o 15%).

Zobacz też: Zamawiasz iPhone’a, dostajesz ziemniaka – oto polskie Black Friday!

O ile mocy obliczeniowej mamy w nadmiarze to w świecie niewydajnych akumulatorów każda amperogodzina jest na wagę złota. Potwierdzenie powyższych informacji może sprawić, że Qualcomm zostanie w tyle. Samsung może wyjść na prowadzenie – pamiętajmy, że w Europie flagowe modele pojawiają się z Exynosami.

źródło: Gizchina