Na rynku urządzeń mobilnych zmiany nazywane szumnie innowacjami częściej dziś budzą politowanie niż podziw. Nowości w smartfonach już od jakiegoś czasu nie imponują, lecz wprowadzają w konsternację. Niewykluczone, że lada moment ten negatywny trend choć trochę się odmieni dzięki Google. Wszystko za sprawą nowego interfejsu wejścia rozwijanego pod nazwą Project Soli, którego elementy mogą pojawić się już w smartfonie Pixel 4.

Project Soli – recepta na wtórność dzisiejszych smartfonów

Jeśli kogoś pasjonuje złudzenie rozwoju w postaci dokładania kolejnych kamer czy wyścigów na to, kto w bardziej kuriozalny sposób ukryje przednią kamerę, to oczywiście ma do tego pełne prawo. Z zawodowego obowiązku śledzę co roku Mobile World Congress i z roku na rok robię to coraz mniej chętnie. Pomysły producentów są w ostatnich latach jak tłumy ludzi – głupie, ale bywa, że groźne. Na pewno jednak nie można ich z czystym sumieniem nazwać „innowacyjnymi”.

Jeśli się nad tym zastanowić, to kierunek rozwoju elektroniki użytkowej jest od wielu dekad determinowany między innymi przez aktualny dla danego punktu w czasie stan interfejsu I/O. Nowe interfejsy wejścia i wyjścia oraz miniaturyzacja sprawiają, że rodzą się nowe klasy sprzętu. Sposób wprowadzania danych ma niebagatelny wpływ na to, co w Dolinie Krzemowej określane jest jako form factor, ale także na graficzne interfejsy oprogramowania.

Problem mogą stanowić ograniczenia interfejsu

W ciągu ostatnich lat ze zgodnością pomiędzy sposobem wprowadzania danych a interfejsem użytkownika aplikacji zrobił się niemały bałagan. Największym branżowym graczom, na czele z Microsoftem, zależało na zatarciu granic pomiędzy urządzeniami i oprogramowaniem mobilnym a ich desktopowymi, komputerowymi odpowiednikami. Publika reagowała na te zamiary entuzjastycznie, zapominając o podwórkowej mądrości, że jak coś jest do wszystkiego, to jest do niczego.

Dziś korporacja wycofuje się z tych decyzji rakiem, zaś rów wykopany pomiędzy interfejsami programistycznymi Win32 i Universal Windows Platform trzeba pośpiesznie zakopywać. Wokół powstały jednak liczne i niezwykle popularne wśród programistów narzędzia, dzięki którym można dostarczać aplikacje mobilne na pecety i (rzadziej) w drugą stronę. Prym wiedzie tu oczywiście Node.js i Electron, co w dodatku odciska piętno na zasobach.

Na szczęście nadchodzi nowe

W rezultacie z czasem oprogramowanie pecetowe zaczęło pod względem ergonomii, metod nawigacji po kolejnych ekranach czy w końcu języka wzornictwa coraz bardziej przypominać aplikacje mobilne. Ba, w niektórych przypadkach mamy do czynienia z portami 1:1! Wówczas niewielkim pecetowym kursorem trzeba sunąć po ogromnych polach dostosowanych do pacnięć kciukiem na wyświetlaczu o kilkucalowej przekątnej.

Niewykluczone zatem, że do odświeżenia tego zblazowanego rynku potrzebna jest popularyzacja nowego interfejsu właśnie. I tu do akacji wkracza Project Soli, pomysł rozwijany dotąd w ramach inkubatora Google ATAP. Jak wiadomo, innowacje mogą w takich inkubatorach być rozwijane (lub sabotowane) latami, ale na łamach XDA Developers poinformowano, że Project Soli może trafić na rynek konsumencki już w tym roku za sprawą Androida Q i smartfonu Pixel 4. Warto zatem przyjrzeć się mu bliżej.

Project Soli – nienowa technologia

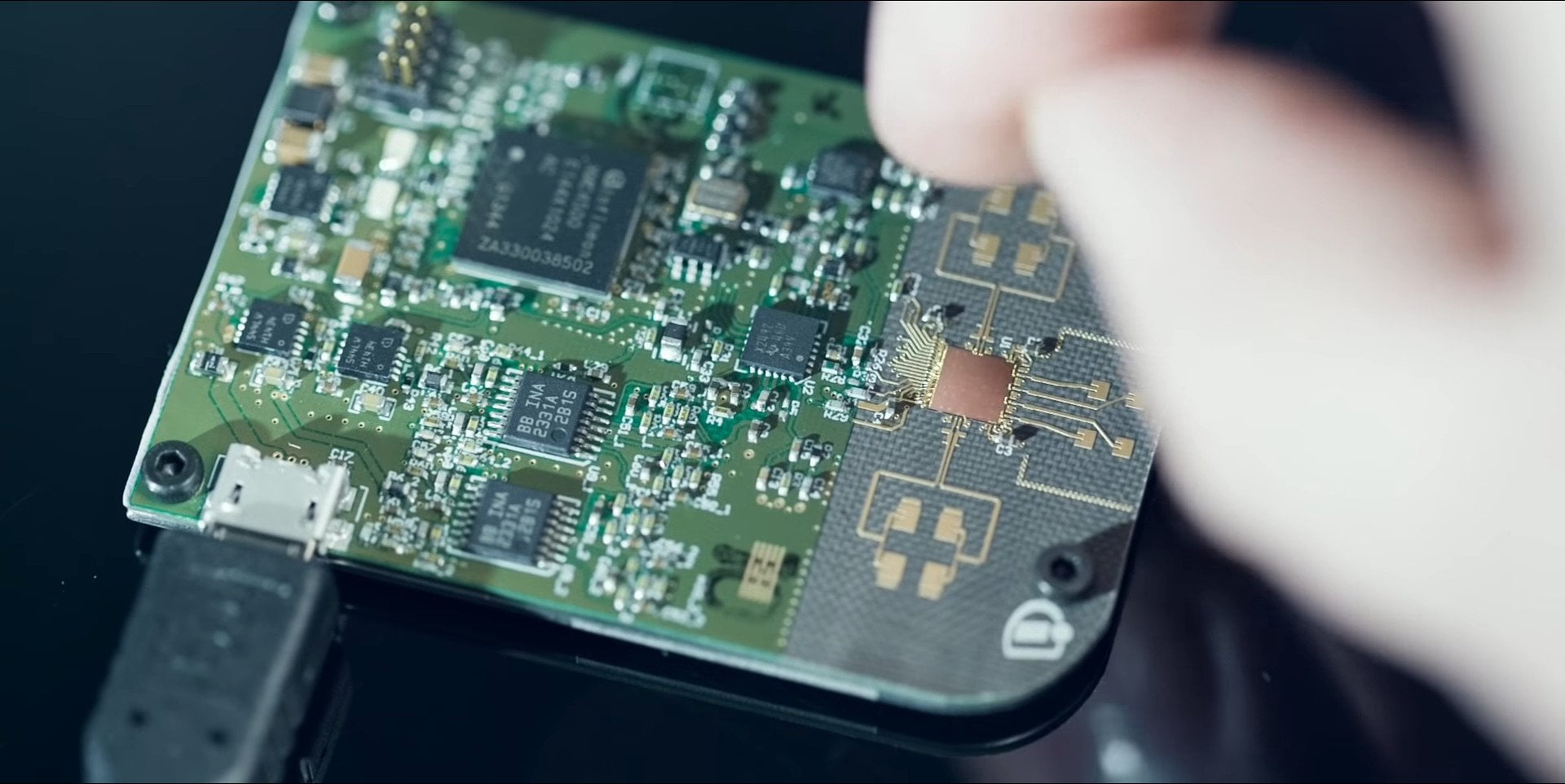

Pod kryptonimem Project Soli rozwijany jest… radar. Mimo najszczerszych chęci trudno zatem mówić o „nowej technologii”. Radar ten jest jednak bardzo niewielki i niezwykle czuły na niewielkich dystansach. Na tyle czuły, że emitując i odbierając odbite fale radiowe, może śledzić ruchy ludzkich palców, dłoni i wykonywane za ich pomocą gesty. Słowem – dzięki Project Soli można obsługiwać urządzenia gestami w trzech wymiarach bez konieczności korzystania z ekranu dotykowego.

Przykłady? Wystarczy przesunąć palcem przed radarem o wymiarach 8 mm × 10 mm, by urządzenie zachowało się tak, jakby przejechać palcem po ekranie dotykowym. Nie jest jednak konieczny żaden panel dotykowy czy powierzchnia – obsługa Project Soli odbywa się w powietrzu i – co ważne – w trzech wymiarach. Cały pomysł rozwija skrzydła jako element szerszej koncepcji określanej przez Google jako Virtual Tools.

Wirtualne narzędzia, czyli skeumorfizm wymyślony na nowo

Te wirtualne narzędzia to sposób, w jaki użytkownik może przekazywać polecenia za pomocą radaru. Chodzi o to, aby wyobrażał on sobie obsługę naturalnych fizycznych interfejsów, np. pokręteł, przycisków czy suwaków, i w ten sposób obsługiwał także oprogramowanie. Jeśli zatem użytkownik potrze kciukiem o palec wskazujący, zupełnie jakby obracał w palcach np. szpilkę, to może liczyć, że na urządzeniu zwiększy się głośność muzyki czy jasność ekranu.

Skeumorfizm wciąż ma się dobrze na gruncie oprogramowania dla muzyków. Fot. Klaus Göttling na licencji CC BY-SA 3.0.

Koncepcję wirtualnych narzędzi można poniekąd porównywać z założeniami, jakie kiedyś w projektowaniu interfejsów programów realizowało Apple – skeumorfizmem. Grafiki wykorzystywane w interfejsie OS X-a czy iOS-a miały naśladować tekstury, kolory i kształty materiałów niewirtualnych: plastiku, szkła czy polerowanego aluminium. Project Soli idzie dalej: chce naśladować sposób wchodzenia w interakcje z prawdziwymi fizycznymi przedmiotami.

Premiera już jesienią?

Nietrudno dośpiewać sobie, jak ogromne zmiany nastąpiłyby w sposobie wchodzenia w interakcje ze sprzętem i oprogramowaniem, jeśli Project Soli trafiłby pod strzechy. Na kod związany z jego implementacją trafiono już czwartej becie Androida Q, nieśmiało przebąkuje się zatem o premierze wraz z Pixelem 4, choćby początkowo w ograniczonym zakresie. Jeśli okaże się to prawdą, to jesień zapowiada się ciekawie.