Mogłoby się wydawać, że przy obecnym rozwoju technologi sztucznej inteligencji każdy z nas wie, jak wygląda deepfake. Nic bardziej mylnego! Oszuści, którzy wykorzystują tę technikę do niecnych celów, już teraz mogą wprowadzić w błąd nawet osoby, które na co dzień zajmują się AI.

Spis treści

NASK pokazuje, jak dziś może wyglądać deepfake

Niedawno sporym echem odbiły się problemy Rafała Brzoski oraz jego żony – Omenay Mensah. W internecie pojawiły się bowiem fałszywe wpisy sugerujące, że kobieta nie żyje lub została pobita przez męża. Obie te informacje są oczywiście kłamstwem skutecznie utrwalonym przez internetowych oszustów.

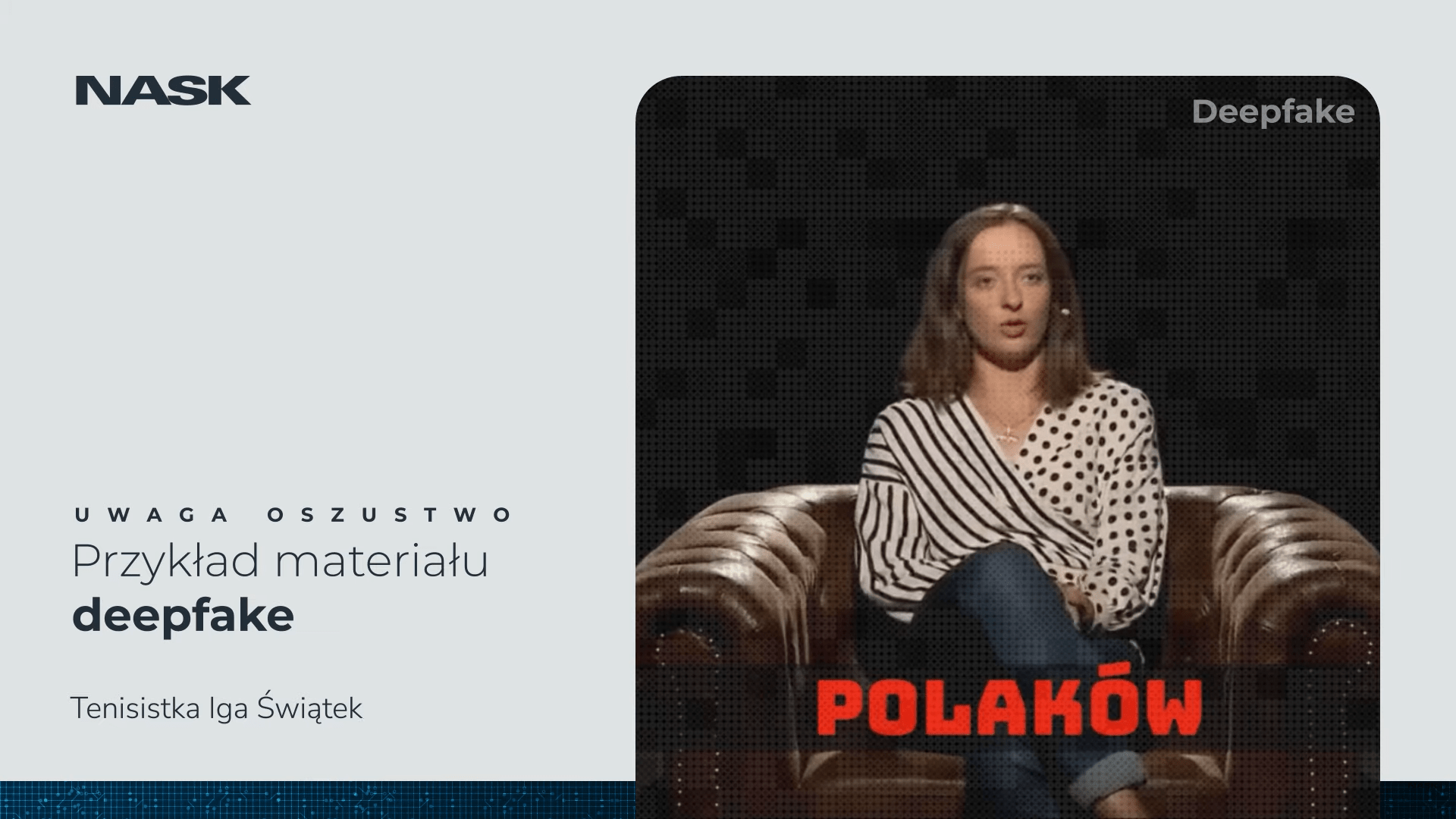

Niemniej fałszywe wpisy to i tak niewiele przy technice deepfake, która dzięki rozwojowi sztucznej inteligencji wchodzi w swoją nową erę. Udowadnia to najnowszy materiał NASK (Naukowa i Akademicka Sieć Komputerowa) dostępny na platformie YouTube. W trakcie trzyminutowego filmu polscy naukowcy przedstawili różne spreparowane wypowiedzi znanych postaci takich jak Iga Świątek, Wojciech Cejrowski czy Magda Gessler.

Wszystko to oczywiście w celu pokazania nam, jak niebezpiecznym narzędziem może być wspomniana wyżej technika.

NASK ostrzega przed nowymi oszustwami deepfake, dostępnymi publicznie na serwisach społecznościowych na przełomie czerwca i lipca 2024 roku. Oszuści podszywają się pod osoby znane, umiejętnie wykorzystując też aktualne, głośne wydarzenia, np. sportowe.

Nie dziwi zatem, że przed Wimbledonem pojawiły się m.in. materiały deepfake z Igą Świątek. Spreparowany film z wizerunkiem polskiej tenisistki służy do reklamowania na platformie Facebook strony z fałszywą inwestycją w projekt Baltic Pipe.

Opis filmu (NASK)

Jak chronić się przed podobnymi niebezpieczeństwami w sieci?

Weryfikacja nagrań deepfake wymaga zastosowania kilku technik analizy i narzędzi. Jednym z najważniejszych kroków jest użycie specjalistycznego oprogramowania do analizy wideo, które potrafi wykrywać anomalie w nagraniach. Narzędzia takie jak Deepware Scanner, Truepic, czy Sensity AI są w stanie identyfikować nieprawidłowości w ruchach twarzy, mimice oraz w nienaturalnych przejściach między klatkami. Warto również zwracać uwagę na detale, które mogą zostać przeoczone przez fałszerzy, takie jak niespójności w oświetleniu czy cienie.

Techniki rozpoznawania tej niecnej techniki obejmują również analizę audio, ponieważ synchronizacja ruchów ust z dźwiękiem może często być nieprecyzyjna w fałszywych nagraniach. W przypadku wątpliwości co do autentyczności nagrania warto także korzystać z narzędzi opartych na sztucznej inteligencji, które są w stanie porównać podejrzane wideo z bazami danych zawierającymi oryginalne nagrania. Analiza metadanych pliku wideo, takich jak data i miejsce nagrania, może również dostarczyć cennych informacji w procesie weryfikacji.

Aby chronić się przed podobnymi oszustwami, należy stosować dobre praktyki cyberbezpieczeństwa, takie jak używanie silnych, unikalnych haseł oraz uwierzytelnianie dwuskładnikowe w mediach społecznościowych i serwisach komunikacyjnych. Edukacja na temat zagrożeń związanych z deepfake i regularne śledzenie najnowszych metod wykrywania oszustw to kluczowe elementy ochrony. Ponadto organizacje i osoby prywatne mogą korzystać z usług firm specjalizujących się w monitorowaniu treści w sieci i wykrywaniu deepfake, co pozwala na szybkie reagowanie na potencjalne zagrożenia.

Źródło: Naukowa i Akademicka Sieć Komputerowa. Zdjęcie otwierające: NASK / YouTube, zrzut ekranu

Część odnośników to linki afiliacyjne lub linki do ofert naszych partnerów. Po kliknięciu możesz zapoznać się z ceną i dostępnością wybranego przez nas produktu – nie ponosisz żadnych kosztów, a jednocześnie wspierasz niezależność zespołu redakcyjnego.