Co chwilę docierają do nas nowe informacje na temat kart graficznych z serii Intel ARC. Z zalewu tych wiadomości wyłania się obraz małego koszmaru Intela i widmo kolejnej porażki na polu eksperymentowania z rynkiem GPU. Czy ta próba miała prawo się udać?

Intel i karty graficzne – dramat w trzech aktach. Czy to miało prawo się udać? Spis treści:

- Akt I – Intel Larrabee. Trochę historii o próbie wejścia giganta na rynek kart graficznych

- Akt II – Intel ARC, czyli do trzech razy sztuka. Jak Raja Koduri miał odmienić sytuację niebieskich w świecie wydajnych układów graficznych

- Akt III – Diabeł tkwi w szczegółach. Czy rywalizacja z NVIDIĄ i AMD jest w ogóle możliwa?

Akt I – Intel Larrabee. Trochę historii o próbie wejścia giganta na rynek kart graficznych

Choć zakusy Intela odnośnie rynku kart graficznych sięgają antycznych już dzisiaj układów i740, bardziej ambitne plany zmaterializowały się dopiero w pierwszej dekadzie tego wieku. Niebiescy byli wtedy u szczytu formy – w 2006 roku premierę miała niezwykle udana architektura Intel Core 2, o której ówczesny prezes firmy, Paul Otellini, powiedział: „(…) to po prostu najlepsze procesory na świecie”. Niesamowicie popularne modele Core 2 Duo E8400 i Core 2 Quad Q6600 były zwiastunem zbliżającej się hegemonii i zepchnięcia AMD w cień na rynku procesorów na długie lata, praktycznie do debiutu serii Ryzen.

Zarząd otwierał szampany, a akcje firmy nieustannie rosły w górę, wobec czego ekspansja i poszukiwanie nowych obszarów rozwoju były już tylko kwestią czasu. Jednym z takich eksperymentów i prób uszczknięcia czegoś z innego tortu okazały się raz jeszcze układy graficzne, które nadal wydawały się niezwykle łakomym kąskiem. To właśnie wtedy narodził się pomysł stworzenia prototypu czipu GPGPU – hybrydy łączącej w jednym kawałku krzemu elementy architektury procesora graficznego i wielordzeniowego procesora.

Na papierze projekt o nazwie kodowej Larrabee był niezwykle ekscytujący i w pewnych obszarach rewolucyjny. Układ jako pierwszy w historii miał posiadać specjalny zestaw instrukcji AVX z 512-bitowym rejestrem (nawiasem mówiąc dopiero niedawno instrukcje te zostały zablokowane dla platform z procesorami Alder Lake). Z jednej strony wykorzystano charakterystyczne dla procesora graficznego jednostki wektorowe SIMD oraz próbkowania tekstur, z drugiej zaś uwagę przykuwały rozwiązania dotyczące pamięci i wyraźne nawiązania do architektury x86, której kod układ z powodzeniem interpretował.

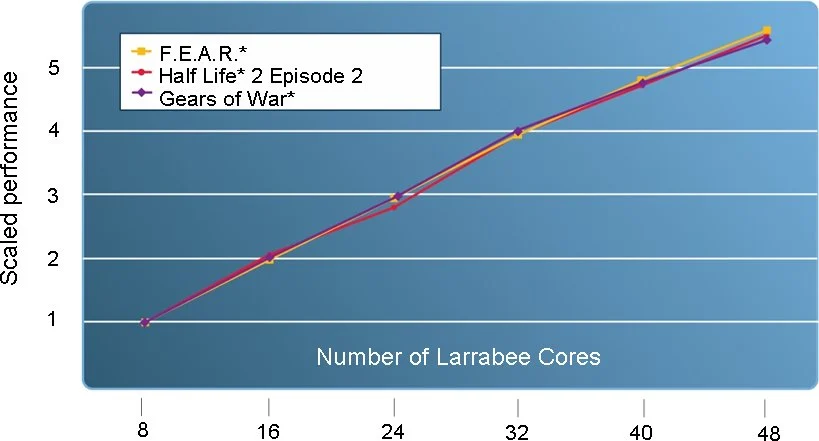

Próbowano stworzyć coś zupełnie nowego, stawiając na elastyczność w akceleracji – każdy z rdzeni mógł być obciążany zgodnie z intencją programisty, a wraz z ich rosnącą liczbą samą wydajność cechowała liniowa wręcz skalowalność:

Oczywiście, aby projekt mógł przyjąć formę opłacalnego produktu dla graczy, musiał posiadać odpowiednią na tle konkurencji wydajność w rzeczywistych zastosowaniach. Niestety z tym właśnie był problem – przyjęta strategia polegająca na wydzieleniu stosunkowo niewielkiej liczby koprocesorów odpowiadających za rasteryzację umożliwiała szersze zastosowanie w innych obszarach, ale nie gwarantowała odpowiedniej liczby klatek na sekundę.

Ostatecznie urządzenie nigdy nie trafiło na półki sklepowe. Decyzja była zrozumiała i podyktowana także sporymi opóźnieniami. Karta graficzna oparta na nowej architekturze miała być gotowa w 2010 roku, a jej wydajność szacowano na około 2 teraflopy. Realia były jednak bezlitosne – premiera układów HD 5870 i HD 5970 firmy ATI rozwiała wszelkie wątpliwości. Konstrukcje z 2009 roku cechowała moc obliczeniowa na poziomie odpowiednio 2,72 teraflopa i ponad 5 teraflopów.

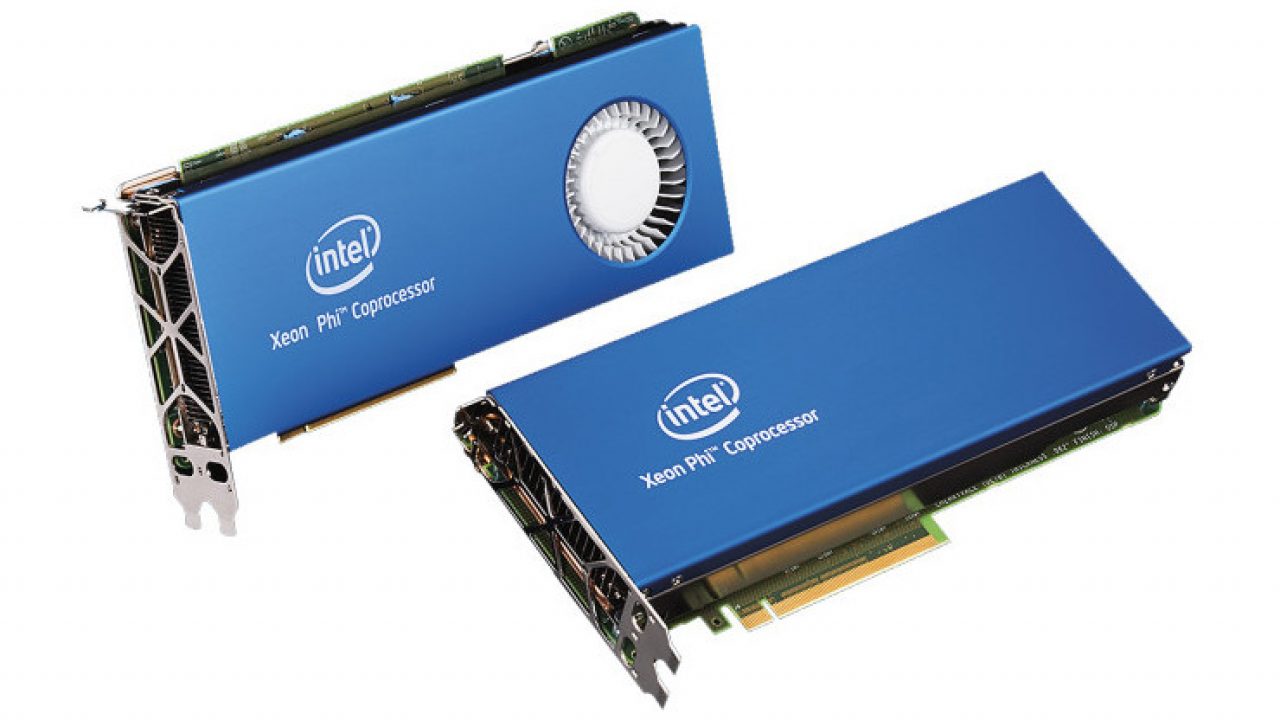

W związku z powyższym zastanawiano się czy produkt sprawdzi się w zastosowaniach profesjonalnych, do których poniekąd również został stworzony. Choć ostatecznie nie wydano go jako typowy procesor graficzny, opracowana technologia trafiła do działu superkomputerów Intela. Niedługo później powstał akcelerator dla wysokowydajnych obliczeń Knights Corner, a w 2012 roku część z tych rozwiązań przeniesiono do koprocesorów Intel Xeon Phi.

Akt II – Intel ARC, czyli do trzech razy sztuka. Jak Raja Koduri miał odmienić sytuację niebieskich

Bohaterem drugiego aktu jest nie kto inny, tylko sam Raja Koduri, który miał odmienić sytuację niebieskich w świecie wydajnych układów graficznych. Charyzmatyczny inżynier przeszedł do zespołu Intela z AMD wraz z kilkoma innymi znanymi personami z branży, by stworzyć od podstaw nową mikroarchitekturę, która miała zapewnić graczom i twórcom przełomową wydajność, sprawność i skalowalność.

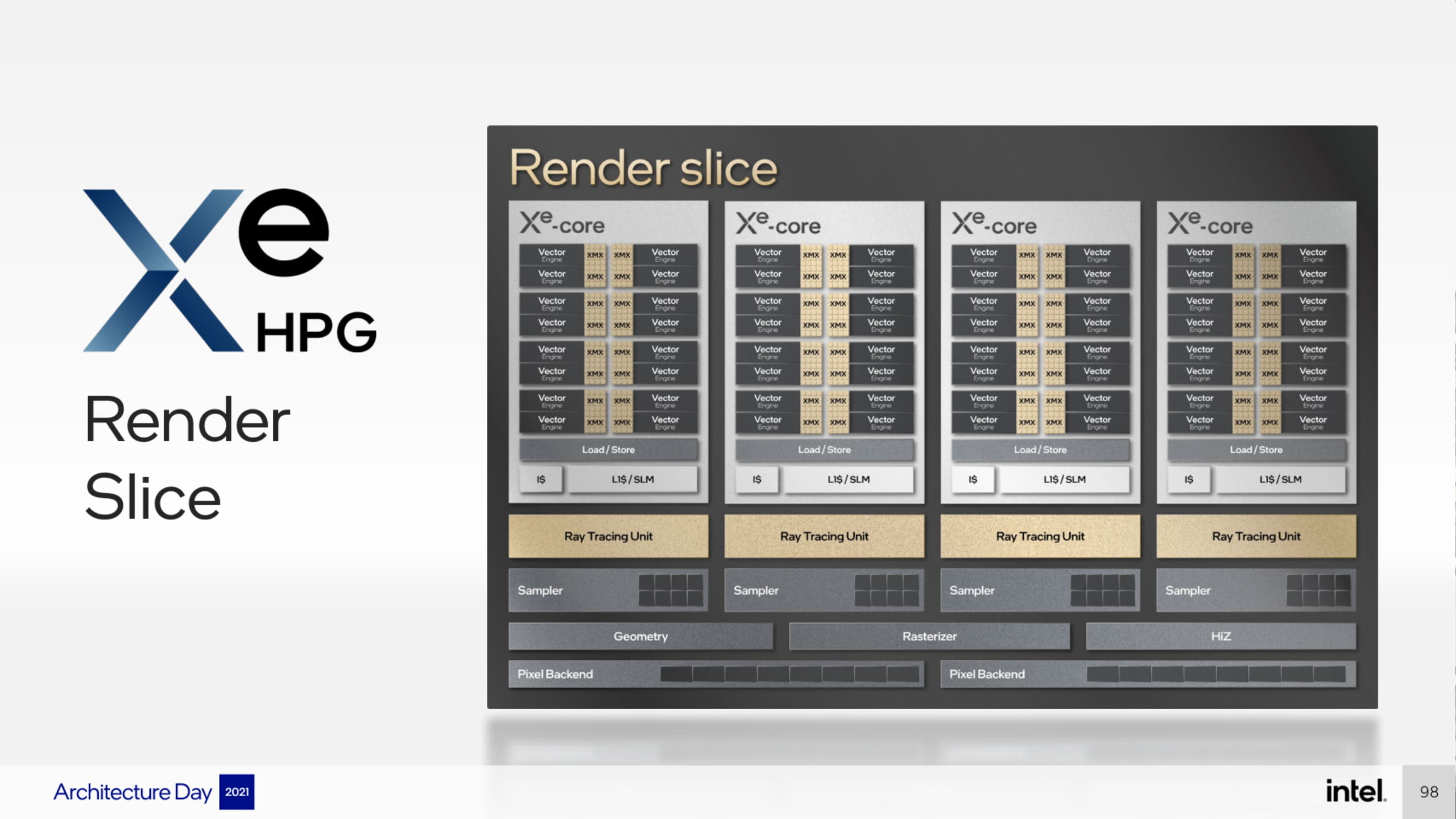

Tak powstał nowy twór o nazwie kodowej Intel Xe-HPG, któremu właściwie ciężko zarzucić coś od strony sprzętowej i zaawansowania technologicznego. Zamiast klasycznych jednostek wykonawczych (Execution Units), wykorzystano nowe bloki Render Slice zawierające rdzenie RT (Ray Tracing Unit – sprzętowe wsparcie śledzenia promieni w czasie rzeczywistym) i Xe-CORE.

Rozbijając te ostatnie na części składowe otrzymujemy jednostki Vector Engine oraz Matrix Engines (Xe Matrix Extensions). W wielkim uproszczeniu, część układu odpowiada za rasteryzację, a dedykowane jednostki XMX obsługują akcelerację obliczeń związanych z algorytmami sztucznej inteligencji.

Nie zabrakło obsługi nowoczesnych technik przetwarzania obrazu, jak chociażby Intel XeSS, odpowiednika NVIDIA DLSS – obraz renderowany w niższej rozdzielczości jest skalowany do rozdzielczości zbliżonej do 4K, co znacznie poprawia jakość przy zachowaniu wysokiej liczby klatek na sekundę. Pełna kompatybilność z bibliotekami DirectX 12 Ultimate w praktyce oznacza również wsparcie standardów DirectX Ray Tracing, Variable Rate Shading, Sampler Feedback oraz Mesh Shaders.

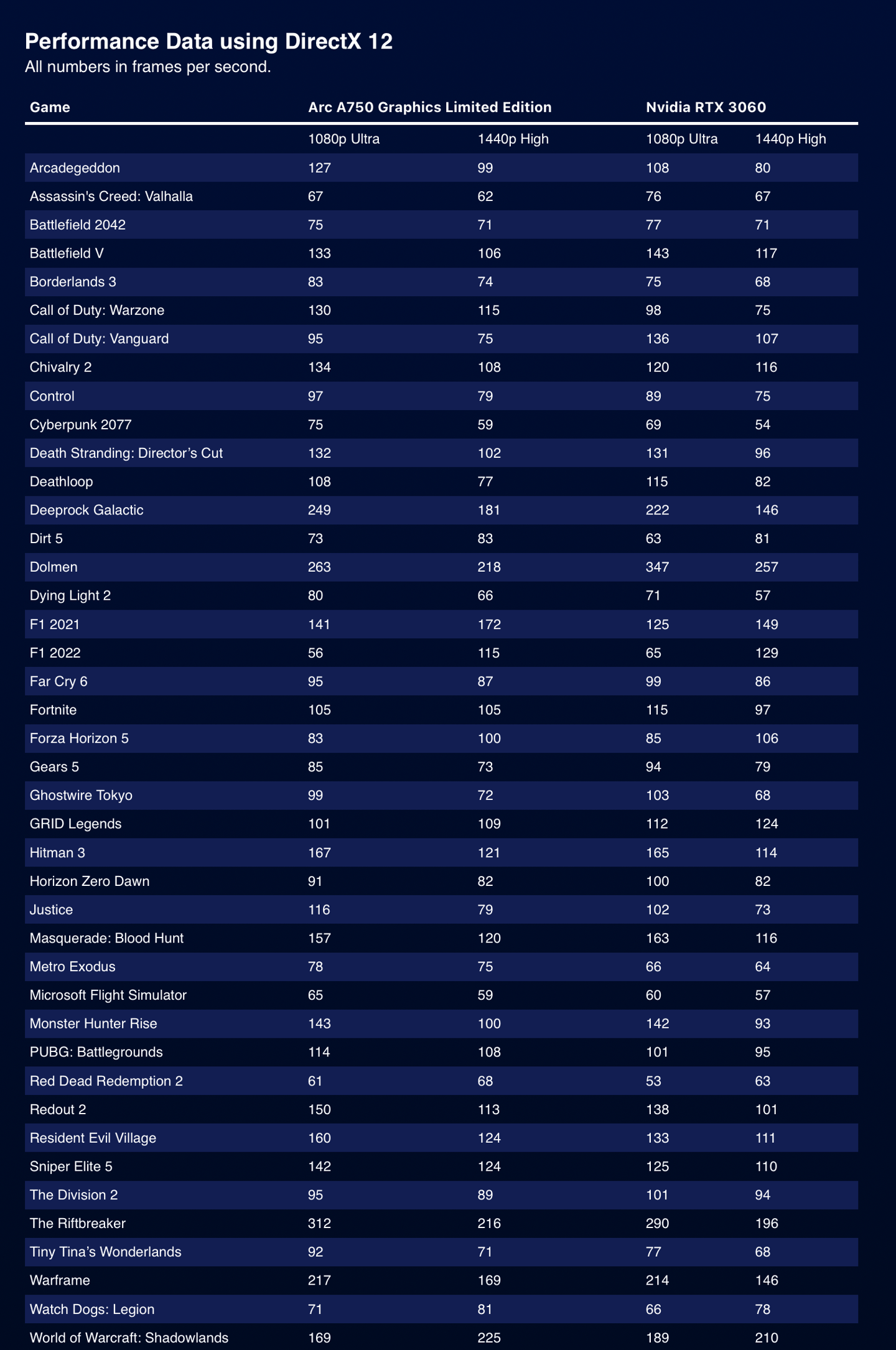

Ok, zostawmy już technikalia w spokoju. Widać wyraźnie, że architektura odznacza się nowoczesną myślą inżynieryjną i włożono w nią sporo serca. Pierwsze testy gier w wyselekcjonowanych tytułach bazujących na nowoczesnych API (DirectX 12 i Vulkan), pokazały niezłą wydajność układu Arc A750 w porównaniu do GeForce’a RTX 3060:

Podobnie wygląda kwestia wydajności układów mobilnych Intel ARC A730M i A770M. Raz jeszcze test został przeprowadzony przez producenta w wybranych grach, ale tym razem konkurencji przykręcono nieco kurek z TGP (maksymalna moc zastosowanych układów):

| 1920 x 1080 | Intel ARC A730M | RTX 3050 Ti 60W | Intel ARC A770M | RTX 3060 85W |

| AC: Valhalla (High) | 50 FPS | 38 FPS | 69 FPS | 74 FPS |

| Borderlands 3 (Ultra) | 50 FPS | 45 FPS | 76 FPS | 60 FPS |

| Control (High) | 62 FPS | 42 FPS | 89 FPS | 70 FPS |

| CP 2077 (Ultra) | 49 FPS | 39 FPS | 68 FPS | 54 FPS |

| Death Stranding (Ultra) | 87 FPS | 89 FPS | 102 FPS | 113 FPS |

| DiRT 5 (High) | 61 FPS | 64 FPS | 87 FPS | 83 FPS |

| F1 2021 (Ultra) | 86 FPS | 68 FPS | 123 FPS | 96 FPS |

| Far Cry 6 (Ultra) | 68 FPS | 63 FPS | 82 FPS | 80 FPS |

| Gears 5 (Ultra) | 52 FPS | 58 FPS | 73 FPS | 72 FPS |

| Horizon: Zero Dawn (Ultimate Quality) | 50 FPS | 63 FPS | 68 FPS | 80 FPS |

| Metro Exodus (Ultra) | 54 FPS | 39 FPS | 69 FPS | 53 FPS |

| Red Dead Redemption 2 (High) | 60 FPS | 46 FPS | 77 FPS | 66 FPS |

| Strange Brigade (Ultra) | 123 FPS | 98 FPS | 172 FPS | 134 FPS |

| The Division 2 (Ultra) | 51 FPS | 63 FPS | 86 FPS | 78 FPS |

| Wiedźmin 3 (Uber) | 101 FPS | 96 FPS | 141 FPS | 124 FPS |

| Total War: TROY (Ultra) | 66 FPS | 48 FPS | 86FPS | 71 FPS |

| Watch Dogs Legion (High) | 71 FPS | 59 FPS | 89 FPS | 77 FPS |

| Średnia geometryczna (FPS) | 64.6 | 57.2 | 88.3 | 78.8 |

Skoro na papierze znowu wszystko się zgadza, to gdzie jest haczyk?

Akt III – Przyszłość mieni się w barwach zielono-czerwonych. Czy rywalizacja z NVIDIĄ i AMD jest w ogóle możliwa?

Dobrze zaprojektowany sprzęt, to niestety tylko połowa sukcesu. Diabeł tkwi w szczegółach, a w tym konkretnym przypadku – w sterownikach. Intel przez lata miał do czynienia z zintegrowanymi układami graficznymi, które nijak się mają do skali optymalizacji, którą trzeba osiągnąć w przypadku dedykowanych kart graficznych o sporej wydajności.

Boleśnie przyznał to sam dyrektor generalny Intela, Pat Gelsinger: „Pomyśleliśmy, że będziemy w stanie wykorzystać zintegrowany pakiet oprogramowania graficznego, który był całkowicie nieodpowiedni do poziomu wydajności i kompatybilności z grami (…)”.

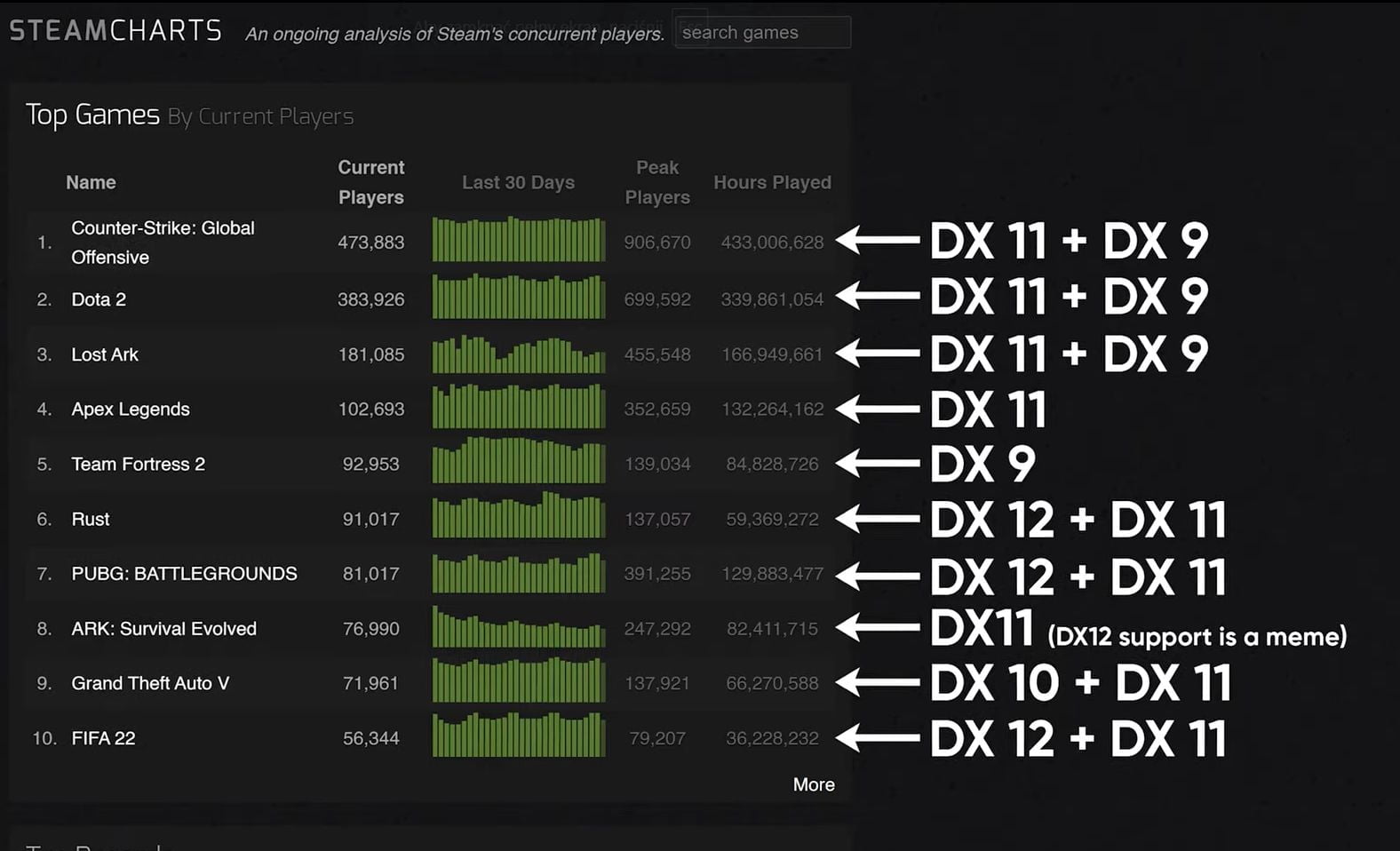

Z dalszych wypowiedzi przedstawicieli firmy wyłania się obraz produktu, który nie będzie gotowy do pełnoprawnej premiery. Najpierw producent poinformował, że optymalizacja będzie przynajmniej przez jakiś czas dotyczyła tylko najnowszych i najbardziej popularnych tytułów korzystających z API DirectX 12 i Vulkan, co stawia pod znakiem zapytania sens zakupu sprzętu już na starcie tak ograniczonego. To sytuacja bez precedensu, tym bardziej, że większość gier nadal korzysta z bibliotek DirectX 11 (wygodnie pominięto przykłady takich pozycji przy wewnętrznych testach):

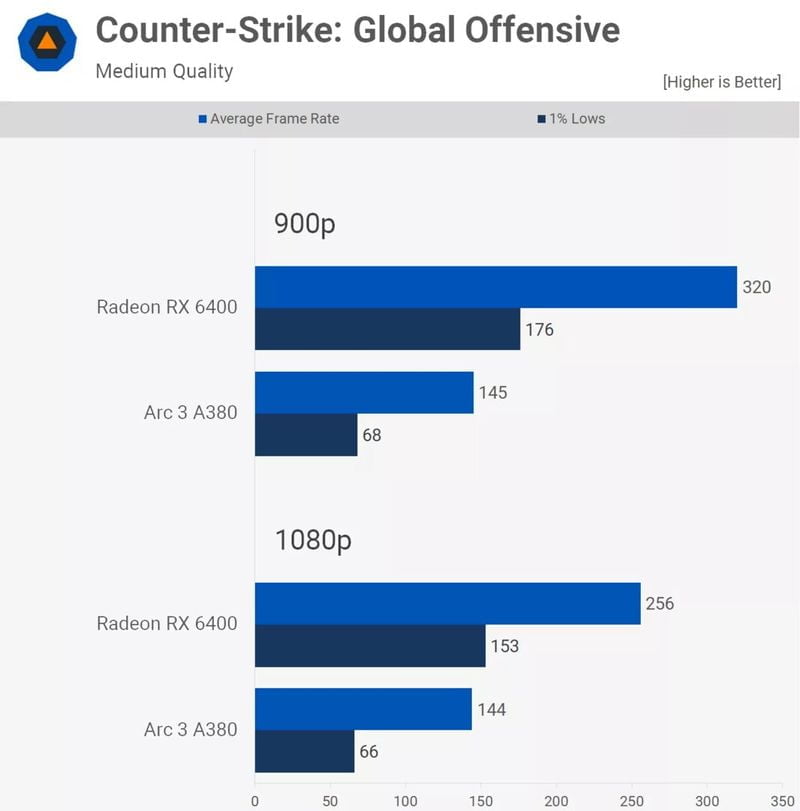

Potem dowiedzieliśmy się, że karty graficzne Intel Arc w ogóle nie będą posiadały natywnej obsługi DirectX 9, a starsze pozycje mają działać (lub nie) przy wykorzystaniu interfejsu Microsoft D3D9On12. Oprogramowanie to ma interpretować i tłumaczyć polecenia graficzne z Direct3D 9 na Direct3D 12, co oczywiście musiało przełożyć się na tragiczną wręcz wydajność. Wystarczy spojrzeć na wykres dotyczący gry Counter-Strike: Global Offensive w teście przeprowadzonym przez redakcję Techspot (porównanie układu Arc 3 A380 z Radeonem RX 6400):

Na sam koniec swoje dołożyli sami producenci kart AIB i wieloletni partnerzy Intela, którzy widząc, co się dzieje, wycofują się ze współpracy. Jak podaje Igor Wallossek z Igor’s Lab, przyczyną są nie tylko słabe osiągi, ale również polityka dotycząca zwrotów i RMA oraz gwarancji cenowych, która nijak nie przystawała do pozbawionej problemów oferty konkurencji. Wobec tego już teraz brane są pod uwagę różne scenariusze, jak choćby całkowite odpuszczenie rynku detalicznego i skupienie się tylko na rynku OEM.

Powyższe informacje nie napawają optymizmem i dobitnie pokazują, że dekad pracy nad sterownikami firm NVIDIA i AMD (wcześniej ATI), nie uda się przeskoczyć robiąc wszystko w biegu. Przypomina to nieco sytuację z Larrabee. Znowu brakuje czasu potrzebnego na dopracowanie produktu i oprogramowania, a obecną, mimo wszystko obiecującą generację i tak przyćmią zbliżające się propozycje z obozu zielonych i czerwonych – karty oparte o architekturę Ada Lovelace i RDNA 3.

Trzeci gracz na rynku GPU to oczywista korzyść dla każdego konsumenta. Pozostaje nam więc życzyć sobie większej cierpliwości ze strony Intela, o co niestety może być trudno. Nie brakuje opinii, że firma ponownie wywróci stolik i wycofa się z wyścigu, zanim na dobrą sprawę weźmie w nim udział. Odpowiedzialny za karty graficzne dział Accelerated Computing Systems and Graphics Group (AXG) w poprzednim kwartale zanotował stratę w wysokości 507 milionów dolarów. Odpowiadając na pytanie zawarte w tytule oraz leadzie – po powrocie pierwsze koty za płoty.