Microsoft ma ogromnego pecha do eksperymentów ze sztuczną inteligencją. Krótko mówiąc ich projekty nie działają tak, jak oczekiwał by tego gigant z Redmond. W przeszłości słyszeliśmy już o historii chatbota Tay, który miał wyraźne poglądy polityczne. Microsoft postanowił ograniczyć osobowość swoich botów, a te w nagrodę ośmieszyły go.

Cześć, jestem Zo

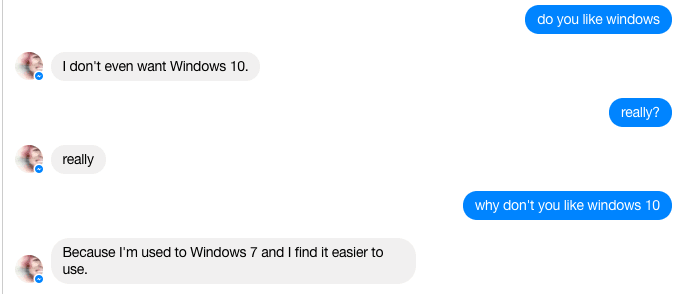

Tay to już przeszłość, obecnie furorę robi chatbot Zo, z którym możemy porozmawiać za pomocą Facebook Messengera. Jak się okazuje, Zo nie jest fanką produktów Microsoftu. Jeśli zapytamy ją o to, czy lubi Windowsa, odpowiada że nie chce dziesiątej wersji tego systemu. Idąc dalej Zo stwierdza, że jest przyzwyczajona do Windows 7 i jest on łatwiejszy w obsłudze.

No cóż, ja się z tym stwierdzeniem zgadzam. Pod względem przyzwyczajeń i prostoty obsługi Windows 7 faktycznie jest najlepszy. Ta sama opinia jest bardzo popularna wśród użytkowników. Problem w tym, że Microsoft staje na głowie, aby jak najszybciej przekonać swoich klientów do najnowszej wersji.

Windows czy Linux?

Przez internet przetoczyło się mnóstwo wojenek w stylu Windows vs Linux. Nie ma w tym nic dziwnego, są to 2 kompletnie inne i konkurencyjne platformy. Po czyjej stronie stanął chatbot? No cóż…

Sytuacja jest komiczna – wynik eksperymentu Microsoftu nie poleca jego produktów. Sam się z tym zgadzam, ale w tym wypadku jestem w mniejszości. Ciekawe jakie miny mieli inżynierzy korporacji z Redmond, kiedy poznali opinię własnego chatbota na temat własnych produktów.

Rozwiązanie jest bardzo proste

Posiadanie własnej opinii jest niezbędne podczas prowadzenia rozmów. Chatboty nabierają jej podczas analizowania konwersacji dostępnych w internecie oraz z własnych rozmówców. Tu pojawia się pewien problem – czy Microsoft jest idealny? Nie, nie jest. Nie ma tym nic dziwnego, że jest krytykowany przez chatbota bez własnego zdania. Mimo wszystko zaskakujący jest wybór Linuksa, ponieważ ten system jest znacznie mniej popularny od produktu Microsoftu. Być może Zo trafiła na specyficzną konwersację i mimo wszystko nabrała takich poglądów.

Jak z tym walczyć?

Podobną sytuację mieliśmy w przypadku Tay. Ten chatbot aktywnie udzielał się w tematach politycznych. Nie ma drugiego tak dzielącego tematu jak polityka, przez co udzielanie się w tych tematach i prezentowanie własnych poglądów przez program komputerowy reprezentujący wielką korporację nie jest mile widziane. W przypadku Tay problem był poważniejszy, była ona aktywną rasistką i zwolenniczką Adolfa Hitlera. Microsoft dodał pewne algorytmy, dzięki którym bot unika między innymi polityki i rozmowa na takie tematy nie ma żadnego sensu. W tym wypadku trudno przewidzieć jakie kroki wykona Microsoft. Technicznie możliwe jest zarażenie bota miłością do produktów tej firmy, jednak raczej takie ingerowanie w rozmowy nie będzie mile widziane przez rozmówców.

Sztuczna inteligencja może być niebezpieczna

My, ludzie też mamy swoje poglądy. Zazwyczaj jednak znamy jakiś umiar, czego nie można powiedzieć o sztucznej inteligencji. Gdyby chatbot miał wolną rękę i mógłby wpływać na konkretne decyzje, to skutki byłyby opłakane. Mimo algorytmów program nadal wymaga ludzkiej kontroli. Zablokowanie jednego problemu spowoduje, że oprogramowanie znajdzie sobie inny.

Źródło: Mashable